HomeLab 网络续集:升级 10G 网络-再战 10 年

HomeLab 网络续集:升级 10G 网络-再战 10 年

dong4j简介

步入中年的人生道路,10GB 以太网口不只是性能的简单提升,它更像是一扇通往新生活的大门。这扇门之后,是丰盈的路由器、交换机和 NAS 的世界,能够让你的中年时光更加充实、更加快乐!

在我家 2.5G 网络的陪伴下, 已经度过了三个充满活力的年头. 这段时光里, 我的网络稳定可靠, 成为了家中信息高速公路的坚实基石. 然而, 随着科技的快速发展和生活需求的变化, 我发现原本强大的 2.5G 网络已经无法满足未来几年日益增长的需求.

期间一直在犹豫是否升级到万兆, 因为 MBP M1 作为我的主力机, 担心万兆网卡兼容性和稳定性问题, 当然也有成熟的雷雳网卡可供选择, 但是价格高的离谱.

最近, 各种升级方案陆续出现, 价格也逐渐符合我的预算. 同时, 家中使用的万兆设备也越来越多. 这一切让我意识到升级到万兆网络的时机已经到了.

在这篇博客中, 我将分享从犹豫不决到决定升级 10G 网络的决策过程. 详细介绍第一次接触的光纤和光模块的相关知识, 一步步地讲解设备购买、网络拓扑设计、网络环境配置和网络测试等方面的细节.

相关文章:

- 先导篇:我的 HomeLab 概要;

- 硬件篇:介绍我所拥有的硬件设备;

- 网络篇:包括网络环境、异地组网与网络安全;

- 服务篇:使用 Docker 搭建的各类服务;

- 数据篇:包括数据存储方案、备份方案和数据恢复方案;

- HomeLab数据同步:构建高效的数据同步网络

- HomeLab数据备份:打造坚实的数据安全防线

- HomeLab 网络续集:升级 10G 网络-再战 10 年

- NAT 内网穿透详解:揭秘网络连接背后的奥秘

MBP 万兆参考方案

目前市面上有许多成品雷雳转万兆网卡可供选择. 这些网卡通常支持 RJ45 或 SFP+ 接口, 可以直接插入 MBP 的雷雳 3 或雷雳 4 端口, 无需额外的硬件转换. 只需连接一根光缆即可实现高速网络传输.

另一种方式是 DIY, 可以更低成本实现万兆网络. DIY 方案主要分为两种:雷雳转 PCIE 和 USB4 硬盘盒的 M2 转 PCIE.

成品网卡

我们先来看一下支持 MBP 的万兆成品网卡(反正不买, 看看总可以吧).

首先是威联通的 QNA-T310G1T 与 QNA-T310G1S, 现在二手成本 1000+.

QNAP T310G1T 和 T310G1S 是两款高性能的万兆网卡, 分别采用 NBASE-T 和 SFP+ 接口, 支持 10G 连网能力. 它们体积小巧, 易于携带, 能够显著提升数据传输速度.

特点:

- 高速传输:支持 10G 连网能力, 将数据传输速度提升至 10 倍以上.

- 小巧轻便:体积小巧, 易于携带, 方便用户随时随地使用.

- 多种接口:T310G1T 采用 NBASE-T 接口, 支持多种连接模式;T310G1S 采用 SFP+ 接口, 适用于多种场景.

- 高效散热:铝合金外壳具有良好的散热性能, 确保长时间运行.

- 易于安装:无需额外供电, 直接连接设备即可使用, Windows 系统需要安装驱动程序.

市面上为数不多的拓展坞和万兆口结合产品, 价格感人.

特点:

- Thunderbolt 3 技术:提供高达 40Gbps 的传输速度, 支持 10GbE 网络、多种存储卡读取、多种接口连接等.

- 多功能扩展:内置 DisplayPort、USB .1、eSATA 等接口, 可扩展电脑的多种功能.

- 充电功能:支持 60W 充电, 可为笔记本等设备充电.

- 兼容性:支持 Windows 和 macOS 操作系统

另一款支持万兆的扩展坞 – OWC Thunderbolt Pro Dock 具有高速 Thunderbolt 3 连接、10GbE 乙太网、多种读卡器接口和丰富的 USB 连接, 可满足各种连接需求, 提升工作效率.

特点:

- 高速连接:Thunderbolt 3 和 10GbE 乙太网, 实现高速数据传输和连接.

- 多功能读卡器:CFexpress Type B 和 SD 4.0 读卡器, 方便快速读写卡.

- 丰富接口:多个 USB-A、USB-C 和 DisplayPort 接口, 满足各种外设连接需求.

- 小巧便携:紧凑设计, 便于携带和安装.

CalDigit 的 Thunderbolt 3 10Gb 以太网转接器

该转接器可将 Thunderbolt 3 计算机连接到 10GbE 以太网络, 提供高达 10Gbps 的传输速度, 适用于企业、工作室、电竞和家庭网络等场景.

特点:

- 10Gbps 以太网速度, 比传统 1Gbps 以太网快 10

- 支持最长 100 米的连接距离

- 支持音频视频桥接 (AVB) 功能

- 可替换式 Thunderbolt 3 传输线

- 总线供电, 无需外接电源

- 兼容多种网络线缆, 包括 Cat 5e、Cat 6 和 Cat 6a

- 支持网络唤醒功能

- 铝制外壳设计, 散热良好

- 支持 macOS 和 Windows 系统

这是一款将 10GbE 网络连接到 Mac、Windows 和 Linux 计算机的设备. 该适配器通过 Thunderbolt 连接, 提供高速的网络连接, 并支持多种操作系统.

特点:

- 支持高达 10GbE 的网络速度

- 通过 Thunderbolt 连接, 提供高速数据传输

- 支持多种操作系统:Mac、Windows 和 Linux

- 包含 SFP+ 光纤模块, 可连接到 10GbE 基础设施

- 轻巧便携, 无需外部电源

其他品牌:

- 兮克雷雳转万兆网卡万兆电口兼容雷雳 3 雷雳 4 转万兆网卡 SKN-T310GT

- 乐扩 USB4 万兆网卡兼容 雷雳 3/4 电口 RJ45 网络转换器 10G 网卡

- 奥睿科雷雳 3 转 10GbE 万兆网络转换器

王炸网卡–ATTO ThunderLink TLNS-3252

双端口 Thunderbolt™ 3/4 至双端口 25Gb 以太网适配器, 附带 SFP28 模块. 支持 macOS 和 Windows 操作系统. 非常适合带宽密集型应用, 例如数据备份和恢复、集群计算、IP 内容交付、医学成像和视频渲染.

- 双端口 25Gb/s Thunderbolt 3, 带 DisplayPort 和设备菊花链支持 (兼容 Thunderbolt 4)

- 每个端口吞吐量高达 25Gb/s

- 包含 SFP28 模块

- 支持 macOS® 和 Windows®

- 支持ATTO 360

- TCP、UDP 和 IPv4 校验和卸载、IPsec 卸载以及 Tx/TCP 分段卸载

- 独家先进数据流 (ADS™) 技术

- Kensington 安全插槽可通过Kensington 锁提供额外的安全保护

DIY

相对于价格高昂但稳定的成品网卡来说, DIY 方式才应该是我的最终选择, 因为 MBP 升级到万兆并不是必须, 性价比显然比稳定性更重要.

现在主流的 2 种 DIY 万兆网卡方案为:

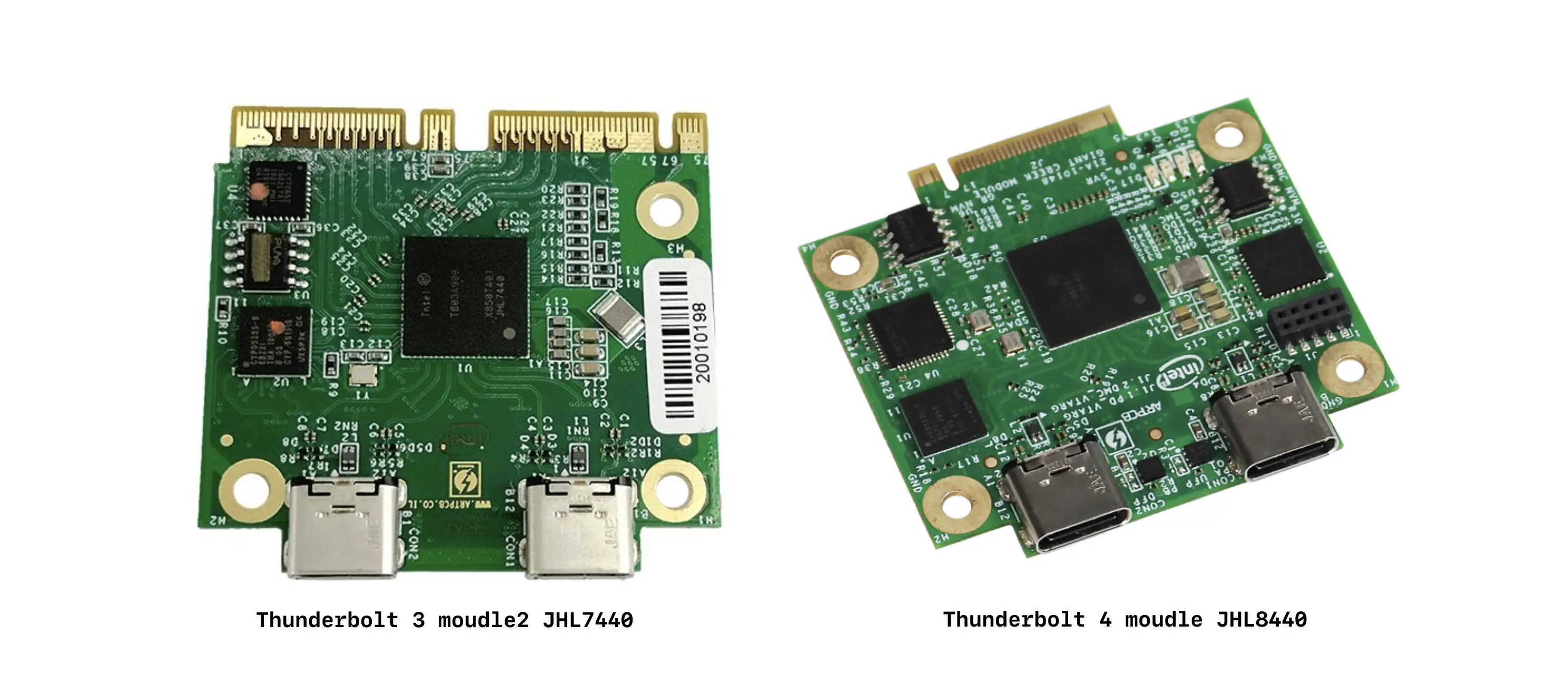

- Thunderbolt 转 PCIe, 主控芯片一般 Intel 的 JHL6X40 或JHL7X40;

- USB4.0 转 PCIe, 主控芯片一般 ASMedia 的 ASM2464PD;

为了搞清楚 Intel 和 ASMedia 主控芯片对速度的影响, 决定先学习一下 2 种主控芯片的差异, 传输速度的区别.

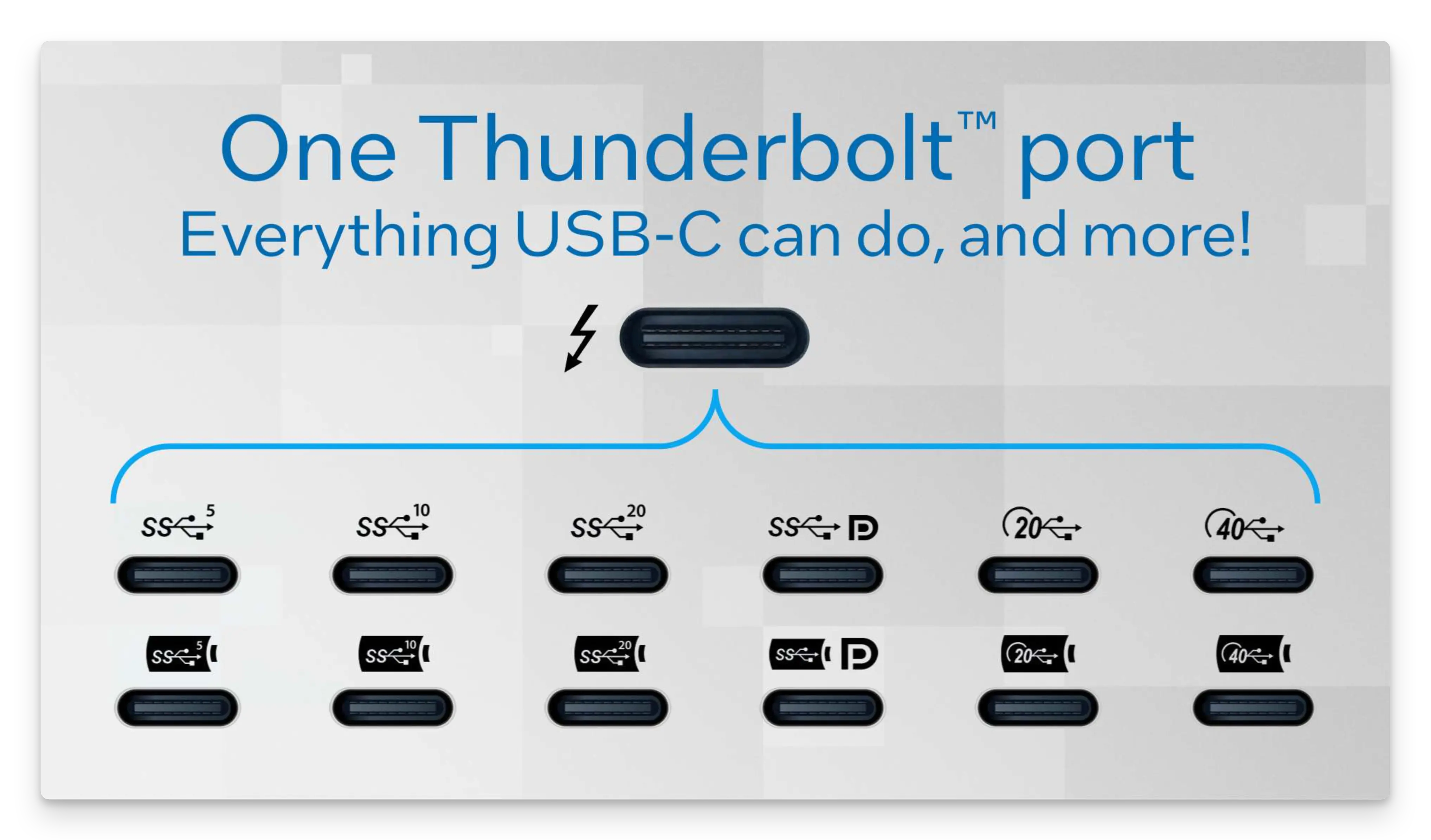

雷雳 4/3 和 USB4.0

首先简单介绍一下关于雷雳 4/3 和 USB4.0, 它们都是目前常见的、用于高速数据传输和视频输出的接口标准. 共享相同的 USB-C 接口, 但各自有不同的特点和优势.

雷雳 4/3

- 核心技术: 由 Intel 主导开发, 基于 PCIe 协议, 提供高速数据传输、视频输出和供电功能.

- 主要特点:

- 高速传输: 最高可达 40Gbps 的传输速度, 适用于大文件传输和高分辨率视频传输.

- 视频输出: 支持多个 4K 显示器或 1 个 8K 显示器, 满足高品质视频需求.

- 供电能力: 最高可提供 100W 的供电, 可为笔记本电脑等设备充电.

- 优势: 性能强劲, 功能丰富, 适用于对性能要求较高的用户, 如视频编辑、游戏玩家等.

USB4.0

- 核心技术: 由 USB-IF 组织制定, 整合了雷雳 3 的先进技术, 向下兼容 USB 3.2 等协议.

- 主要特点:

- 高速传输: 最高可达 40Gbps 的传输速度, 与雷雳 4 相同.

- 视频输出: 支持和雷雳 3 同等的视频拓展能力.

- 供电能力: 具备大功率 PD 电力传输功能.

- 优势: 兼容性强, 向下兼容 USB 3.2 等协议, 价格相对较便宜.

雷雳 4/3 和 USB4.0 的区别:

| 特点 | 雷雳 4/3 | USB4.0 |

|---|---|---|

| 开发者 | Intel | USB-IF 组织 |

| 协议 | PCIe | USB |

| 兼容性 | 向下兼容 USB 3.2 | 向下兼容 USB 3.2 等协议 |

| 价格 | 较高 | 相对较低 |

| 功能 | 更丰富, 性能更强 | 兼容性更广 |

总结来说雷雳 4/3 更适合对性能有较高要求的用户, 如专业创作者、游戏玩家等. USB4.0 具有更好的兼容性, 适用于普通用户, 性价比更高.

主控芯片

JHL7440

JHL7440 是来自英特尔生产的控制芯片, 得益于自家是雷雳接口的主要开发者, 在性能和传兼容性上有很好的表现.

其实你会发现大多数的硬盘盒品牌在介绍的时候宣称 JHL7440 与 Thunderbolt 3/4 兼容, 事实上这样说好像也没什么问题. 但其实该芯片只是兼容 Thunderbolt 4, 但实际上只是 Thunderbolt 3 时期的产物.

JHL7440 芯片组, 该芯片组提供高达 24Gbps 的传输速度, 实际速度最高约为 2800 MB/s. 很多朋友可能好奇, 雷雳 4/3、USB4.0 接口不是最高支持 40Gbps 的传输速度吗, 怎么到这里最高仅提供 24Gbps (2800MB/s) 的速度.

确实, Thunderbolt 3/4 和 USB4.0 接口理论上支持高达 40Gbps 的传输速度. 然而, 在实际应用中, 由于硬件设计和技术限制, 某些控制芯片 (如 Intel JHL7440) 并不能完全达到这个速率. 下面是造成这种差异的几个原因:

1. 带宽分配限制

- JHL7440 芯片设计之初, 定位主要是 Thunderbolt 3 规范, 并主要用于接口扩展. 虽然它兼容 Thunderbolt 3 的高达 40Gbps 的带宽, 但在具体设计上, 往往只能分配其中的 24Gbps 用于数据传输.

- Thunderbolt 接口的 40Gbps 是总带宽, 实际应用中需要分配给 数据传输、显示输出 等用途. 而 JHL7440 主要为数据传输设计, 因此仅分配 24Gbps.

2. PCIe 通道限制

- JHL7440 连接到主板时, 通常仅通过 PCIe 3.0 x2 通道与系统通信, 而非全速的 PCIe x4. 因此, 这一设计在接口层面上就限制了最大数据传输速度, 约为 24Gbps, 也就是实际的 2800MB/s 左右.

3. 兼容性和成本考量

- JHL7440 的设计主要面向性价比市场, 意在降低设备成本并提供可靠的 Thunderbolt 3 性能, 因此对极限性能的支持相对较低.

- 对于日常数据传输需求, 2800MB/s 已经能满足大多数场景 (如高清视频剪辑、数据备份等) , 因此对于多数厂商而言, JHL7440 是一个性能和成本的平衡之选.

4. 实际应用中的速率损耗

- 实际中, 传输速率会受多种因素影响, 如 硬盘类型、散热情况、数据传输协议 等. 即便硬件接口支持更高速度, 但 SSD 本身的写入/读取速度也会成为瓶颈.

各型号区别

JHL6340、JHL6540、JHL7440和 JHL7540几个型号:

- JHL6340 和 JHL6540:

- 这两款芯片都是 Intel 推出的 Thunderbolt 3 (雷雳 3) 主控芯片. 根据官方参数, JHL6340 和 JHL6540 与旧款的 DSL6340 和 DSL6540 在单双口的功耗、封装面积、DP 输出标准等方面没有区别.

- JHL6540 的功耗为 2.2w, 相比之下, JHL6340 的功耗为 1.7w.

- JHL7440:

- JHL7440 也是一款雷雳 3 主控芯片, 但它被设计为同时支持 USB-C 的 Function, 提高了设备的运用弹性. 这使得新一代的 Dock/Hub/显示器可以“降级”到 USB-C 模式下使用.

- JHL7540:

- 与 JHL6540 相比, JHL7540 在显存读取带宽上提升了 10%, 其读取带宽可达到 3017MB/s, 而 6540 的读取带宽最多为 2750MB/s. 在性能测试中, 使用 JHL7540 的显卡坞在帧数上比使用 JHL6540 的显卡坞高出约 6.5%.

这些型号之间的主要区别在于性能和兼容性. JHL6340 和 JHL6540 是较早的型号, 而 JHL7440 和 JHL7540 提供了更高的性能和更好的兼容性.

ASM2464PD

ASM2464PD 是 ASMedia 公司 (华硕子公司) 推出的一款 USB4 / Thunderbolt 控制芯片, 其实该芯片是 USB4.0 的产物, 不过也同样兼容雷雳 4/3 接口. 与英特尔的 JHL7440 相比, ASM2464PD 更具性价比.

从实体体验上来说, ASM2464PD 芯片的硬盘盒似乎能提供更高的传输速度. 因为与 Thunderbolt 3 设计不同, 没有为 DisplayPort 或传统 USB 3.x 规范保留带宽. 所以, 你可以从网络上看到采用 ASM2464PD 芯片的硬盘盒的传输速度能来到 3000MB/s 出头的成绩.

虽然速度上更胜 JHL7440, 且价格相对低廉, 但其实 ASM2464PD 也有缺点, 在兼容性与发热上, ASM2464PD 似乎比 JHL7440 更严重.

不同主控芯片的硬盘盒速度对比:

| 供应商 | 主控芯片 | 上游接口 | 下游接口 | 理论速度 | 真实速度 |

|---|---|---|---|---|---|

| ASMedia | ASM2464PD | USB4 with PCIe Gen4x4 | PCIe Gen4×4 | 40Gb/s | 3200-3800MB/s |

| Intel | JHL7440 | TB3 with PCIe Gen3x4 | PCIe Gen3x4 | 24Gb/s | 2600-2800MB/s |

| Intel | JHL6X40 | TB3 with PCIe Gen3x4 | PCIe Gen3x4 | 22Gb/s | 2500-2600MB/s |

参考方案

硬盘盒转 PCIe

硬盘盒有 2 类能满足要求:

- 基于 JHL6X40 或 JHL7X40 主控芯片的雷雳硬盘盒;

- 基于 ASM2464PD 主控芯片的 USB4.0 硬盘盒;

方案一(300+)

偶然刷到 300 块搞定苹果雷雳万兆网卡 这个视频, Up 主使用 200+ 的 USB4.0 硬盘盒实现了 MBP 万兆:

实现方式为:

- USB4.0 硬盘盒(关键词[USB4.0 硬盘盒 m2 雷雳 4 硬盘盒 40G-nvme USB2.0 扩展坞音频改装万网卡]-某多多): 主控芯片是 ASM2464PD, 现在涨价到 240+ 了;

- m.2 转 PCIe 小板: 10+

- 免驱万兆网卡: 曙光单口万兆网卡(Intel X520-DA1) ;

顾虑:

- 不是 M 系列芯片且不是最新的系统;

- 不是双光口网卡

这种方案因为没有外接供电, 会出现掉卡的情况, 所以评论中就有外接供电的方案.

方案二(600+)

- ITGZ 双 M.2 硬盘盒, 主控:JHL7440;

- m.2 转 PCIe 小板;

- 12V DC 转 SATA 供电;

- 网卡: Intel Intel X520-DA2;

使用的是: ITGZ 雷雳 3 双盘 M.2 NVMe 硬盘盒扩展坞, 价格 500+.

顾虑:

- 不知道作者的 MBP 具体配置是什么, 且整套设备价格超预算.

方案三(300+)

另一个 UP 主方案: 雷雳万兆网卡廉价方案:

- ITGZ USB4.0 硬盘盒, 主控:ASM2464PD;

- m.2 转 PCIe 小板;

- 12V DC 转 SATA 供电;

- 网卡: Intel X520-DA1;

另一款主控芯片为 JHL7440 的同类产品, 价格贵了 100+.

顾虑:

- 不是 M 系列芯片且不是最新的系统;

- 不是双光口网卡

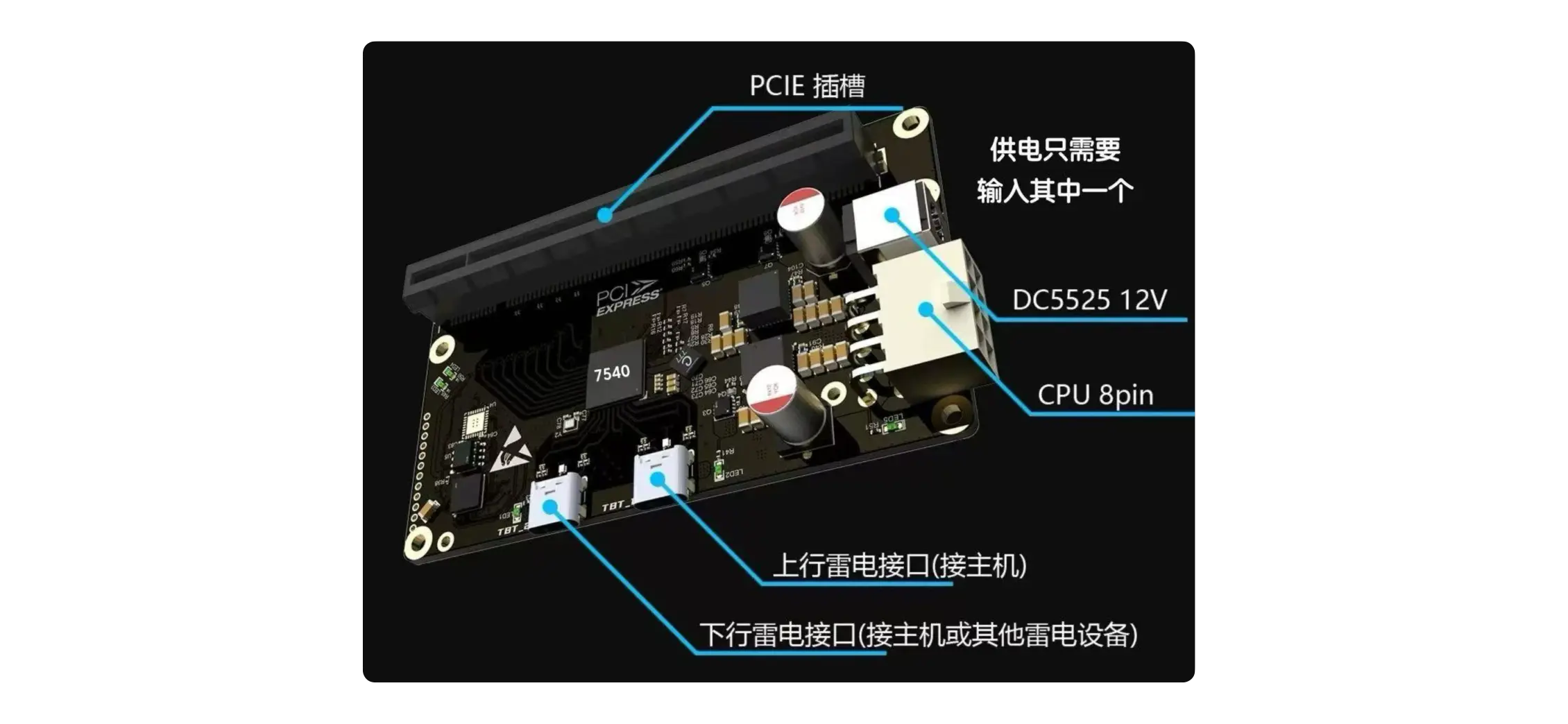

雷雳扩展坞

这类方案就比较多了, 主要是通过一个雷雳 4/3 核心板外接其他元器件焊接成一个具备 PCIe 插槽的电路板, 方便的地方是不需要 m.2 转 PCIe 小板.

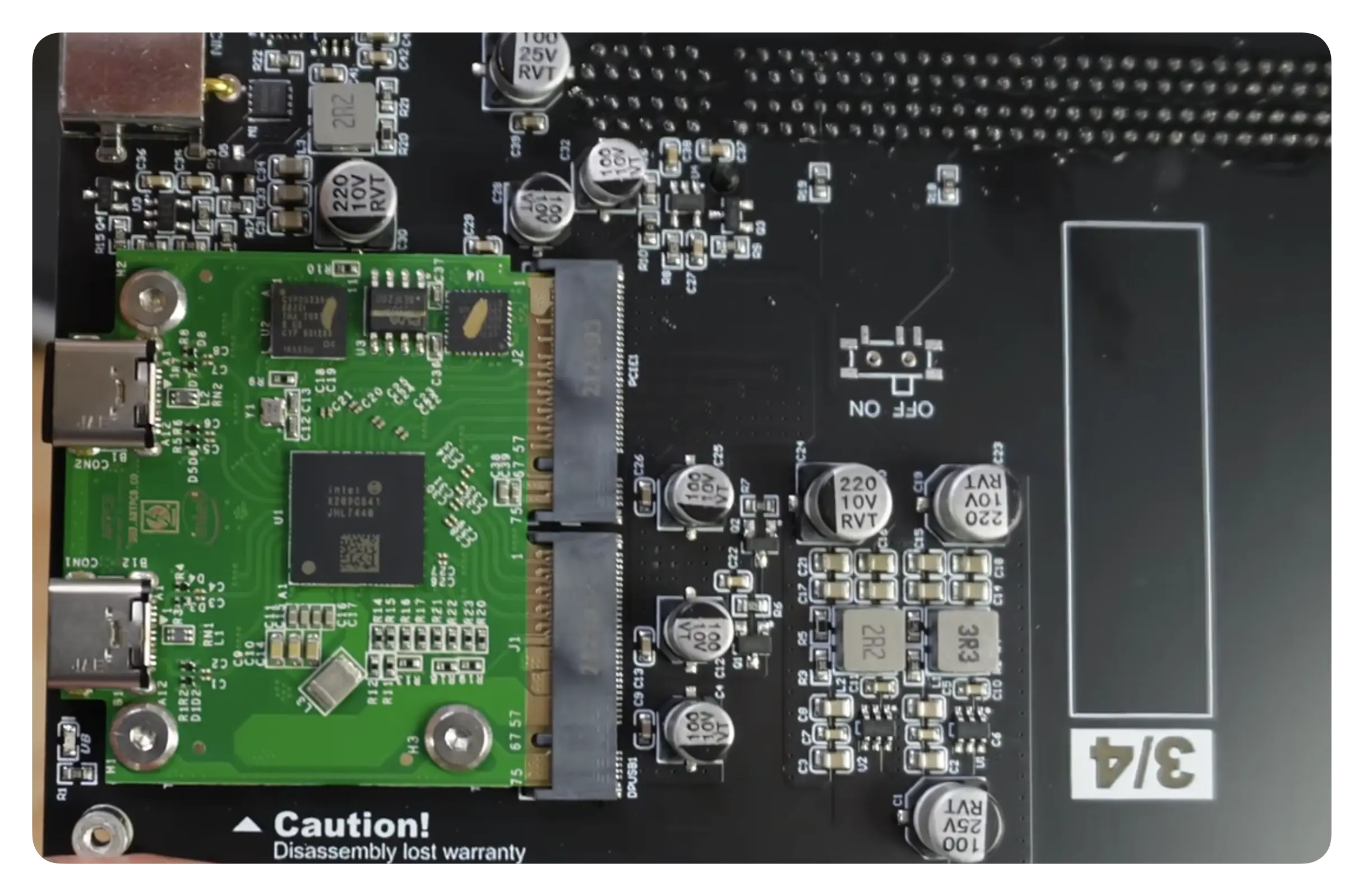

雷雳核心板

动手能力强的还可直接购买雷雳核心板来组装, 价格 200+:

一些雷雳拓展坞就是是用上面的核心板来提供雷雳功能, 比如 UGREEN 绿联雷电 3 多功能 10 接口扩展坞 CM355.

方案一(500+)

- 主控芯片: JHL7440;

- 网卡: Intel X520-DA1;

这个方案也是使用了上述的雷雳核心板:

顾虑:

- 不是 M 系列芯片且不是最新的系统;

- 不是双光口网卡

方案二(600+)

最廉价的 Mac 电脑 M1 M2 芯片 雷雳转万兆网卡方案测试:

- 雷雳拓展坞(主控芯片: JHL7440);

- 网卡: Intel X520-DA1;

顾虑:

- 不是最新的系统;

- 不是双光口网卡;

在了解了 MBP 万兆的可行方案后, 接下就是其他的准备工作.

准备工作

电口 Or 光口

万兆网络涉及到一个交换机网口选择问题–使用光口还是电口?

我目前的网络情况是 千兆和 2.5G 设备全部使用的电口, M920x 2 个万兆光口则使用 10G DAC 线连接交换机的 10G 光口.

我的需求是至少需要 7 个 10G 网口, 才能将主要设备通过交换机组成万兆局域网. 首先就排除了全电口方案, 一是 成本考虑, 二是 噪音.

8 口全电口交换机优点是可以兼容我现在所有的设备而不需要换线. 缺点就是比全光口的交换机贵上不少, 另外因为 发热量大, 必须得加散热风扇, 那么噪音又是一个需要考虑的问题.

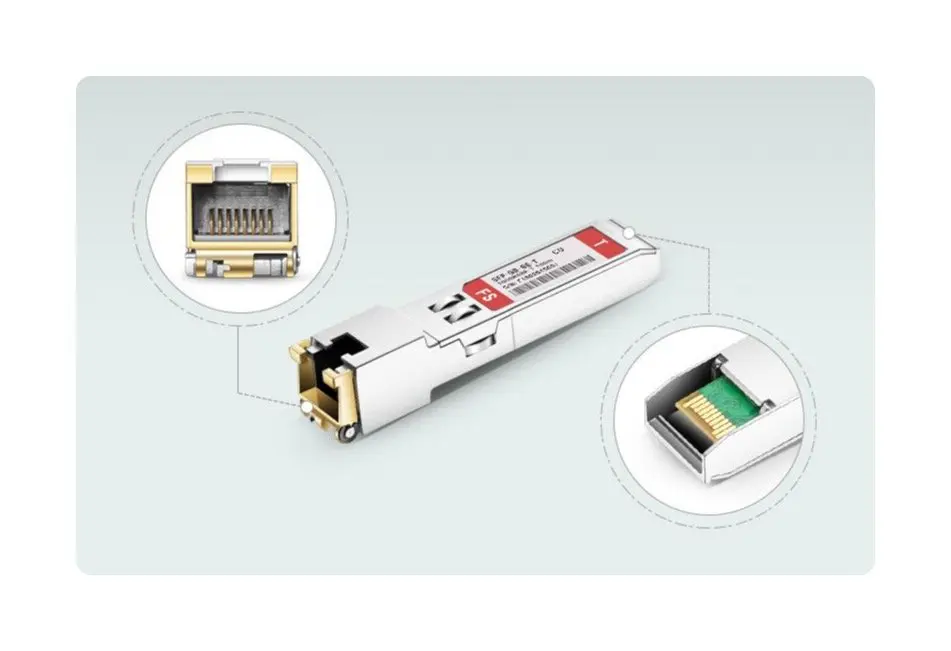

选择全光口的话, 缺点就是需要重新布线, 以及为仅支持电口的设备添加 万兆光转电模块(100+).

万兆光转电模块

它的作用是可以将交换机上的光口转换为电口, 以满足交换机上 RJ45 端口不足的需求. 如图所示, 万兆电口模块一端是 SFP+端口, 另一端为 RJ45 接口

优势

- 更灵活的连接方式:SFP+转 RJ45 端口提供了一种灵活的解决方案, 将 SFP+端口转换为 RJ45, 使其更适合数据中心和企业网络的需要.

- 成本效益:采用普通 RJ45 连接器, 支持向下兼容, 使网络升级成本更低. 相比额外购买 10GBASE-T 电口交换机, 更经济高效.

- 传输距离:SFP+转 RJ45 端口模块可以在 100 米的距离内提供 10Gb/s 的数据传输, 解决了 SFP+ DAC 高速线缆只能传输有限距离的问题.

- 节省能源:与嵌入式 10GBASE-T RJ45 端口相比, 使用 SFP+转 RJ45 端口模块每个端口至少节省 0.5W 的功耗, 降低了能源消耗.

- 多速率支持:支持多种传输速率 (10/100/1000Mbps 及 10Gbps) , 使其易于操作和管理.

缺点

- 功耗和热量:连接多个端口时, 相比光纤布线, SFP+转 RJ45 端口解决方案的功耗和热量可能会较高.

- 网络延迟:在连接多个节点时, 可能会增加网络延迟.

万兆光转电模块关键数据

| 规格 | 描述 |

|---|---|

| 传输速率 | 10Gbps (向下兼容 1Gbps 和 100Mbps) |

| 光纤端口 | SFP+ 插槽, 支持多模和单模光模块 (如 850nm, 1310nm) |

| 电口 | RJ45 接口, 支持 Cat6a 或 Cat7 电缆 |

| 光模块标准 | 10GBASE-SR (最大 300 米) / 10GBASE-LR (最大 10 公里) |

| 供电方式 | 5V 或 12V 外接电源, 部分支持 PoE |

| 协议支持 | IEEE 802.3 标准, 支持全双工和半双工模式 |

| 工作温度 | -20℃ 到 70℃ |

| 功耗 | 2W 至 10W |

| 物理尺寸 | 桌面型或插卡式 (机架安装) |

而其他设备则全部使用光模块连接. 说到这里, 也会有 3 种选择–无缘铜缆(DAC), 有源光缆(AOC)和独立的光纤+光模块.

DAC 线缆

Direct Attach Cable, 简称 DAC, 一般译为直接连接电缆或直连铜缆, 是指直接连接服务器和网络设备的高速铜缆, 它采用差分信号传输技术, 能够提供高速率、低损耗的数据传输.

DAC 高速线缆通常用于短距离的设备互联, 如服务器集群、存储区域网络 (SAN) 等.

Direct Attach Cable 分两种:

- 10G SFP+DAC

- 40G QSFP+ 转 4 个 SFP+

这种线缆都不可更换端口, 模块头和铜缆不能分离.

AOC 线缆

Active Optical Cable,简称 AOC, 译为有源光缆, 是由集成光电器件组成的, 用于数据中心、高性能计算机、大容量存储器等设备间进行高速率、高可靠性互连的传输设备, 它通常满足工业标准的点接口, 通过内部的电-光-电转换, 使用光缆的优越性进行数据的传输.

这种线缆同样不可更换端口.

DAC 与 AOC 的区别:

| 属性 | DAC (Direct Attach Copper) | AOC (Active Optical Cable) |

|---|---|---|

| 传输介质 | 铜线 | 光纤 |

| 类型 | 被动 DAC (无信号放大器) 或主动 DAC (带信号放大器) | 主动型, 内置光电转换模块 |

| 传输距离 | 通常支持 1-7 米, 最远约 15 米 | 通常支持 10 米到 100 米, 部分型号可达数百米 |

| 功耗 | 较低 (特别是被动 DAC, 几乎不耗电) | 较高 (需要光电转换模块工作) |

| 价格 | 相对便宜, 适合短距离连接 | 相对昂贵, 适合长距离连接 |

| 柔韧性 | 较差, 铜线较硬, 不适合狭小空间或需要多次弯折的环境 | 更灵活, 光纤材质可以弯曲, 适合复杂布线 |

| 信号完整性 | 短距离内信号完整性较好, 但距离增加会受限于铜线电磁干扰 | 优秀, 光纤抗电磁干扰能力强, 适合长距离传输 |

| 接口兼容性 | 支持 SFP/SFP+、QSFP/QSFP+ 等标准接口 | 同样支持 SFP/SFP+、QSFP/QSFP+ 等标准接口 |

| 典型应用场景 | 服务器机柜内短距离连接, 交换机到服务器 | 机柜间、楼层间、数据中心之间的长距离高速连接 |

光纤+光模块

| 属性 | 光纤 + 光模块 | 成品线缆 (DAC/AOC) |

|---|---|---|

| 结构 | 光纤线缆与可更换光模块的组合 | 一体化设计, 线缆与模块固定为一体 |

| 传输距离 | 支持较长距离传输 (几百米到数公里, 取决于光模块和光纤类型) | 通常适用于短距离连接 |

| 灵活性 | 光模块和光纤可根据需求自由更换 | 受限于固定长度和规格 |

| 价格 | 光模块和光纤分开购买, 整体成本较高 | 相对便宜, 尤其是在短距离应用中 |

| 功耗 | 光模块需要供电, 功耗相对较高 | DAC 无需供电, 功耗最低;AOC 有源设计, 功耗较光模块略低 |

| 维护与扩展 | 更换单个光模块或光纤即可灵活升级或维修 | 整根线缆损坏需整体更换 |

| 接口类型支持 | 支持多种接口标准, 如 SFP、QSFP 等 | 通常与网卡或设备固定接口匹配 |

| 适用场景 | 数据中心核心网络、长距离互联 | 数据中心机架内或机架间短距离连接 |

二手的 DAC 和 AOC 线缆大概 10+ 一根, 不过上次给 M920x 选购 AOC 线缆时出现了不兼容的问题, 后来就换成了 DAC 线缆, 这次准备使用光纤+光模块的方案, 可以更换光模块的方式应该更灵活一些, 二手的价格也贵不了多少.

接下来就是介绍一下光纤和光模块了, 因为是第一次接触光纤, 所以需要先学习了解一下基础知识.

光纤技术

在现代网络通信中, 光纤传输技术是高速和远距离数据传输的关键. 它通过光信号在光纤中传输数据, 以实现更高的带宽、更低的延迟和更远的传输距离. 与传统的铜缆相比, 光纤在数据中心、企业网络和广域网中已成为主流选择.

因为目前搭建万兆光纤网络离不开对 光纤类型, 光纤接口类型 和 光模块类型 的基本了解, 所以就从这三个方面介绍一下基础知识.

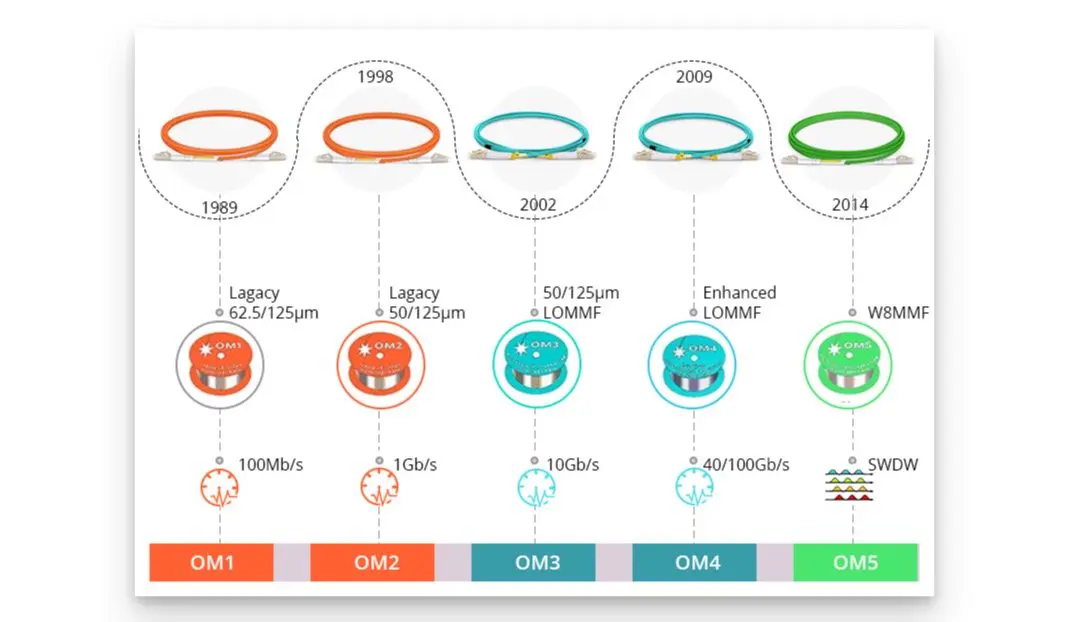

光纤类型

光纤是由玻璃或塑料制成的一种传输介质, 能够通过光信号传递数据. 根据用途和传输距离, 光纤分为两种主要类型:

- 单模光纤 (Single-mode Fiber) : 只允许单一模式的光通过, 适用于长距离通信 (可达几十公里甚至上百公里) , 适用于跨楼层或跨建筑物的通信.

- 多模光纤 (Multimode Fiber) : 允许多种模式的光通过, 适合短距离传输 (通常在 300 米以内) , 成本较低, 多用于机房或局域网内设备的连接.

颜色区分

通过光纤的外护套颜色可快速区分单模光纤和多模光纤. 根据 TIA-598C 标准 定义, OS1/OS2 单模光纤的外护套颜色为黄色, 而多模光纤的外护套颜色为橙色或水绿色, 其中 OM1/OM2 多模光纤采用橙色外护套, OM3/OM4 多模光纤采用水绿色外护套, OM5 多模光纤则采用绿色外护套.

传输距离

单模光纤常用于长距离传输, 多模光纤一般用于短距离传输. 而不同类型的单模和多模光纤应用在不同速率以太网中传输距离各不相同, 如下表所示:

| 光纤类型 | 1000Base/1Gb (SX) 以太网 | 1000Base/1Gb (LX) 以太网 | 10Gb 以太网 | 40Gb 以太网 | 100Gb 以太网 |

|---|---|---|---|---|---|

| OS1/OS2 单模光纤 (1310nm) | 5Km | 20Km | 40Km | 40Km | 80Km |

| OM1 多模光纤 (850nm) | 275m | 550m | 33m | / | / |

| OM2 多模光纤 (850nm) | 550m | 550m | 82m | / | / |

| OM3 多模光纤 (850nm) | 550m | 550m | 300m | 100m | 100m |

| OM4 多模光纤 (850nm) | 550m | 550m | 550m | 150m | 150m |

| OM5 多模光纤 (850nm) | / | / | 550m | 440m | 150m |

参考:

纤芯的直径差异

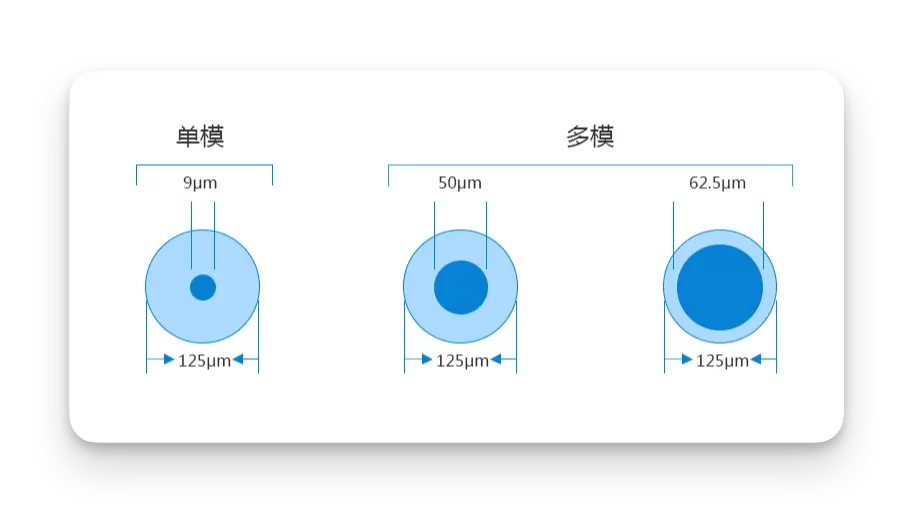

单模光纤 (SMF) 的纤芯直径一般为 9μm, 由于纤芯窄, 它只能在 1310nm、1550nm 以及 WDM 波长上传输一种模式的光, 也正因如此, 单模光纤色散较小, 带宽高, 而多模光纤 (MMF) 的纤芯直径一般为 50/62.5μm, 纤芯宽, 它能在给定的工作波长 (850nm 或 1310nm 波长) 上传输多种模式的光, 但因为多模光纤中传输的模式多达数百个, 各个模式的传输常数和群速率不同, 导致多模光纤的带宽窄、色散大, 损耗也大.

光源差异

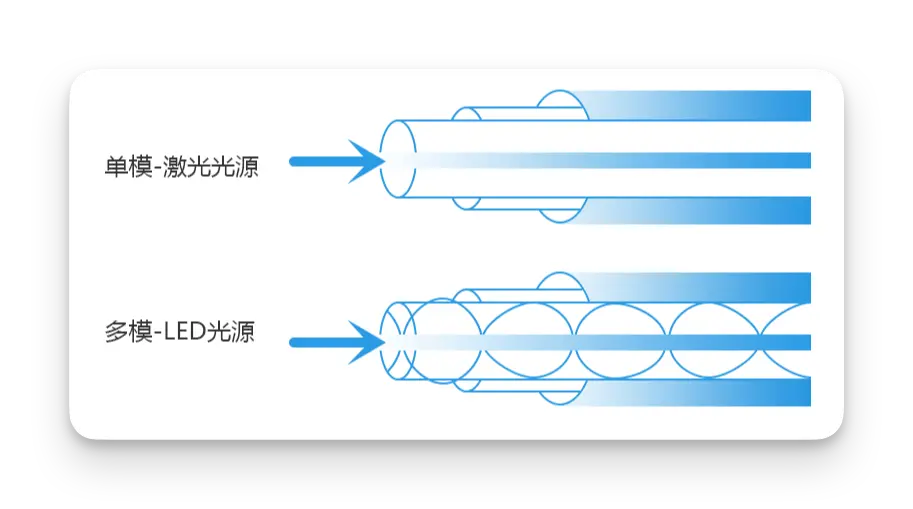

单模光纤和多模光纤采用的光源不同, 单模光纤一般采用 激光光源, 而多模光纤一般采用 LED 光源.

单模单芯/单模双芯/多模双芯

在光纤通信中, 单模单芯、单模双芯 和 多模双芯 是常见的光纤类型. 它们的区别主要体现在光纤模式、芯数、传输性能以及适用场景上.

以下是详细对比:

1. 定义与特性

| 类型 | 定义 | 特点 |

|---|---|---|

| 单模单芯 | 单根单模光纤, 光以单一模式传播, 适用于长距离通信. | 支持远距离和高带宽传输, 常与波分复用 (WDM) 技术结合使用. |

| 单模双芯 | 两根单模光纤, 分别用于发送 (TX) 和接收 (RX) . | 适合中短距离通信, 广泛用于数据中心和企业网络的设备互联. |

| 多模双芯 | 两根多模光纤, 光以多种模式传播, 分别用于发送和接收. | 适合短距离高带宽传输, 主要用于数据中心内部设备间的高速互联. |

2. 光纤模式与传输性能

| 特性 | 单模单芯 | 单模双芯 | 多模双芯 |

|---|---|---|---|

| 光纤模式 | 单模 | 单模 | 多模 |

| 传输距离 | 最长 (几十公里到上百公里) | 较长 (几公里到几十公里) | 最短 (一般在 300 米以内) |

| 传输带宽 | 高 (支持 10Gbps~400Gbps) | 高 | 较低 (支持 10Gbps 或更高, 但距离受限) |

| 抗干扰能力 | 极强 | 极强 | 较弱 (多模光纤模式干扰较多) |

3. 使用场景

| 类型 | 典型应用场景 |

|---|---|

| 单模单芯 | 长距离通信, 如骨干网、跨机房连接、电信级应用. |

| 单模双芯 | 数据中心、企业园区网络中短距离互联, 如交换机到服务器的连接. |

| 多模双芯 | 数据中心内部短距离高速互联, 如 10Gbps 到 100Gbps 的设备互联, 通常为 300 米以内. |

4. 连接方式与成本对比

| 属性 | 单模单芯 | 单模双芯 | 多模双芯 |

|---|---|---|---|

| 光纤芯数 | 单根光纤 | 双根光纤 | 双根光纤 |

| 布线复杂度 | 最低 | 较高 (需两根光纤) | 较高 |

| 设备成本 | 较高 (需 WDM 技术支持) | 较低 | 最低 |

| 光纤成本 | 最低 (只需一根光纤) | 较高 (双根光纤) | 较低 (多模光纤通常成本更低) |

| 常用接口类型 | LC、SC | LC、SC | LC、SC |

5. 适配光模块

| 类型 | 推荐光模块类型 |

|---|---|

| 单模单芯 | 单纤双向光模块 (BiDi 模块) , 支持 WDM 技术. |

| 单模双芯 | 双纤光模块 (如 SFP、SFP+ 模块) . |

| 多模双芯 | 多模光模块 (如 OM3/OM4 支持的 SFP 模块) , 常用于短距离高速通信. |

总结

| 特性 | 单模单芯 | 单模双芯 | 多模双芯 |

|---|---|---|---|

| 传输距离 | 长距离 (几十公里到上百公里) | 中短距离 (几公里到几十公里) | 短距离 (一般在 300 米以内) |

| 应用场景 | 长距离骨干网、跨区域通信 | 数据中心、企业园区网络 | 数据中心内部设备互联 |

| 成本 | 光模块和设备成本高 | 成本适中 | 光纤和模块成本最低 |

- 单模单芯: 适合长距离、高带宽传输, 设备成本高, 适合电信级应用.

- 单模双芯: 中短距离的全双工通信优选方案, 兼顾性能和成本.

- 多模双芯: 经济高效的短距离方案, 适合数据中心内设备间的高速连接.

光纤接口类型

1. FC 型光纤接口

全名为 Ferrule Connector, 是一种常见的光纤接口类型. 它的外部加强方式是采用金属套, 紧固方式为螺丝扣. FC 接口在电信网络中被广泛采用, 具有牢靠、防灰尘的优点. 不过, 安装时间相对较长, 通常在 ODF (光纤配线架) 侧使用较多.

2. SC 型光纤接口

即 Square Connector, 是一种卡接式接口. 它的外壳呈矩形, 紧固方式是采用插拔销闩式, 不需要旋转. SC 接口的使用非常方便, 但容易掉出来, 因此在路由器和交换机上使用较多.

3. ST 型光纤接口

全称为 Straight Tip, 是一种圆形的接口. 它的紧固方式为螺丝扣, 插入后需要旋转半周以固定. ST 接口的缺点是容易折断, 但在光纤配线架中使用较多, 尤其是对于 10Base-F 连接来说.

4. LC 型光纤接口

即 Lucent Connector, 是一种小型化的光纤接口. 它的外壳呈矩形, 紧固方式为插拔销闩式. LC 接口适用于 SFP 模块, 采用模块化插孔 (RJ) 闩锁机理制成, 便于操作和维护.

运营商进户光纤都是单芯单模皮线光纤, 到光猫这里都必须是单模光纤才能正常使用, 没有其他选择, 单模光纤通常都是 SC 接口. 到光猫这段距离通常也是运营商负责维护. 属于接入网 PON (Passive Optical Network, 无源光网络) . 是目前有线接入网的主流技术, FTTH (Fiber to the Home, 光纤到户) 让大家享受到了超高网速带来的便利性.

光模块类型

封装类型分类

光模块按照封装形式来分有以下几种常见类型:

- SFP: GBIC 的升级版, 最高速率可达 4.25Gbps, 主要由激光器构成, 特点是小型、可热插拔.

- SFP+: SFP 的加强版, 传输速率为 10Gbps, 可以满足 8.5G 光纤通道和 10G 以太网的应用.

- SFP28: 传输速率为 25Gbps, 它的优点是功耗较低、端口密度较高, 且支持热插拔.

- QSFP+: 传输速率为 40Gbps, 支持 MPO 光纤连接器和 LC 光纤连接器, 特点是小型、可热插拔.

- QSFP28: 采用 4 个 25Gbit/s 通道并行传输, 传输速率为 100Gbps, 满足 100G 以太网的应用.

更高规格的模块有:

QSFP-DD: 采用 8 通道电接口, 单通道速率 25Gbps/50Gbps/100Gbps, 提供高达 200Gb/s 到 800Gb/s 总最大数据速率.

OSFP: 是一种新型光模块, 比 QSFP-DD 略大, 同样具有 8 个高速电通道, 支持高达 800G 的总吞吐量.

光纤类型分类

光模块根据适用的光纤类型的不同可被分为 单模光模块 和 多模光模块, 其中单模和多模指的是光纤在光模块中的传输方式. 单模光模块多用在远距离传输中, 而多模光模块多用在短距离传输中.

多模光模块的工作波长为 850nm;单模光模块的工作波长为 1310nm、1550nm;单模光模块中使用的器件是多模光模块的两倍, 所以单模光模块的总体成本要远远高于多模光模块;单模光模块的传输距离可达 150 至 200km;多模光模块的传输距离可达 5km.

光模块的命名

比如 SPF-10G-XX: SFP 是 Small Form Pluggable 的缩写, 意为可热插拔的小型模块, 可以简单理解为 GBIC(Gigabit Interface Converter 的缩写) 升级版本. 10G 代表其最大传输速率为 10.3 Gbps, 适用于 10G 以太网. XX 代表 SR, LR, LRM 等, 表示光模块的传输距离.

SR, LR, LRM, ER 和 ZR 是 10GIEEE 标准 中比较常见的模块类型,. 在光纤通信中, SR, LR, LRM, ER 和 ZR 是 10G 光模块传输中的一种距离术语. SR 表示短距离,LR 表示长距离, LRM 表示长度延伸多点模式, ER 表示超长距离, ZR 则表示最长距离.

目前市面上万兆光模组型号繁多, 如用于多模传输的 SFP-10G-SR 万兆光模组、用于单模传输的 SFP-10G-LR 万兆光模组、以及既能用于单模传输又能用于多模传输的 SFP-10G-LRM 万兆光模组, 下面是部分万兆光模组的区别:

| 型号 | 波长 | 光纤类型 | 传输距离 | 接口 | 标准 |

|---|---|---|---|---|---|

| SFP-10G-SR | 850 nm | 多模 | 300 m | LC 双工 | 10GBASE-SR |

| SFP-10G-LR | 1310 nm | 单模 | 10 km | LC 双工 | 10GBASE-LR |

| SFP-10G-LRM | 1310 nm | 多模 | 220 m | LC 双工 | 10GBASE-LRM |

| SFP-10G-LRM | 1310 nm | 单模 | 300 m | LC 双工 | 10GBASE-LRM |

| SFP-10G-LRM2 | 1310 nm | 单模 | 2 km | LC 双工 | 10GBASE-LRM |

- SFP-10G-SR (短距离) 是一种常见的 SFP 模块, 它可以在 多模光纤 中连接高达 300 米的光纤. 一般情况下 SR 模块多为多模, 工作波长为 850nm. 这些模块是可热插拔的, 相互之间可以轻松实现切换.

- SFP-10G-LR(长距离) 用于远程数据传输, 如大型组合或地铁区域网络. 具有成本低、功耗低、体积小、密度高的优点.

- SFP-10G-LRM(长度延伸多点模式) 符合 10GBASE-LRM 以太网的标准, 适用于传统光纤和新型多模光纤. 它在多模光纤上的最小支持距离为 220 米, 在单模光纤上的最小支持距离为 300 米.

还有超远距离传输的模块:

- SFP-10G-ER(超长距离)在标准 单模光纤 上支持长达 40 公里 的传输距离. 广泛应用于数据中心和企业工业园区 .

- SFP-10G-ZR (最长距离), 在标准 单模光纤 上支持高达 80 公里 的传输距离, 其波长为 1550nm. 符合 SF-8431、SF-8432 和 IEE802.11 ae 标准. 它可应用于数据网络/光网络.

参考:

光纤和光模块组合

| 光模块类型 | 光纤类型 | 是否能正常工作 |

|---|---|---|

| 单模光模块 | 多模光纤 | 短距离可以工作, 但无法保障效果(需要使用 光纤收发器 转换光纤类型) |

| 单模光模块 | 单模光纤 | 正常工作 |

| 多模光模块 | 单模光纤 | 无法工作 |

| 多模光模块 | 多模光纤 | 正常工作 |

- 单模光模块与单模光纤配套使用. 单模光纤传输频带宽, 传输容量大, 适用于长距传输.

- 多模光模块与多模光纤配套使用. 多模光纤有模式色散缺陷, 其传输性能比单模光纤差, 但成本低, 适用于较小容量、短距传输.

在了解相关基础知识后, 满足最低 10G 速度需求的前提下, 考虑性价比后, 目前多模光纤更合适, 因为搭配的多模光模块更便宜, 所以我我选择使用 多模双芯光纤(OM3) + LC-LC 接口 + 多模光模块(SFP-10G-SR) 来组建我的万兆光纤网络, 这应该是家庭万兆光纤网络比较常见的配置了.

网卡

MBP 网卡驱动

首先需要确定 Macbook Pro M1 Max 系统为 macOS Sequoia (版本 15.1.1) 能够免驱哪些万兆网卡.

Apple 原生驱动有(ls -d /System/Library/DriverExtensions/*AppleEthernet):

- com.apple.DriverKit-AppleEthernetE1000.dext: Intel 驱动

- com.apple.DriverKit-AppleEthernetIXGBE.dext: Intel 驱动

- com.apple.DriverKit-AppleEthernetIXL.dext: Intel 驱动

- com.apple.DriverKit-AppleEthernetMLX5.dext: Mellanox 驱动

各驱动区别:

| 驱动名称 | 支持的硬件/芯片组 | 用途描述 |

|---|---|---|

| AppleEthernetE1000 | Intel E1000 系列网卡 (千兆以太网) | 支持 Intel 的千兆网卡 |

| AppleEthernetIXGBE | Intel IXGBE 系列网卡 (万兆以太网) | 支持 Intel 的万兆网卡 |

| AppleEthernetIXL | Intel IXL 系列网卡 (25G/40G/100G Ethernet) | 支持 Intel 的 25G/40G/100G 高速网卡 |

| AppleEthernetMLX5 | Mellanox ConnectX-5 系列网卡 (25G/50G/100G Ethernet) | 支持 Mellanox 高性能网卡 (Nvidia) |

我们关注的是 10G 网卡驱动, 所以对应的是: com.apple.DriverKit-AppleEthernetIXGBE.dext.

下面是驱动信息:

cat /System/Library/DriverExtensions/com.apple.DriverKit-AppleEthernetIXGBE.dext/Info.plist

1 | <dict> |

如上所示, 比较关键的是 0x00008086&0x0000ffff, 表示 PCI ID 为 8086 且忽略设备 ID.

PCI 供应商 ID 8086 将英特尔标识为设备制造商.

Intel 网卡

Intel 网卡 与驱动信息:

| 型号 | 主芯片型号 | 协议标准 | 接口类型 | 驱动 |

|---|---|---|---|---|

| X520 | Intel 82599 | 10GbE | SFP+ | com.apple.DriverKit-AppleEthernetIXGBE |

| X540 | Intel X540 | 10GbE | BASE-T | com.apple.DriverKit-AppleEthernetIXGBE |

| X550 | Intel X550 | 10GbE | BASE-T | com.apple.DriverKit-AppleEthernetIXGBE |

| X710 | Intel X710 | 10GbE | BASE-T/SFP+ | com.apple.DriverKit-AppleEthernetIXL |

| XXV710 | Intel XXV710 | 25GbE | SFP28 | com.apple.DriverKit-AppleEthernetIXL |

| XL710 | Intel XL710 | 40GbE | BASE-T/QSFP+ | com.apple.DriverKit-AppleEthernetIXL |

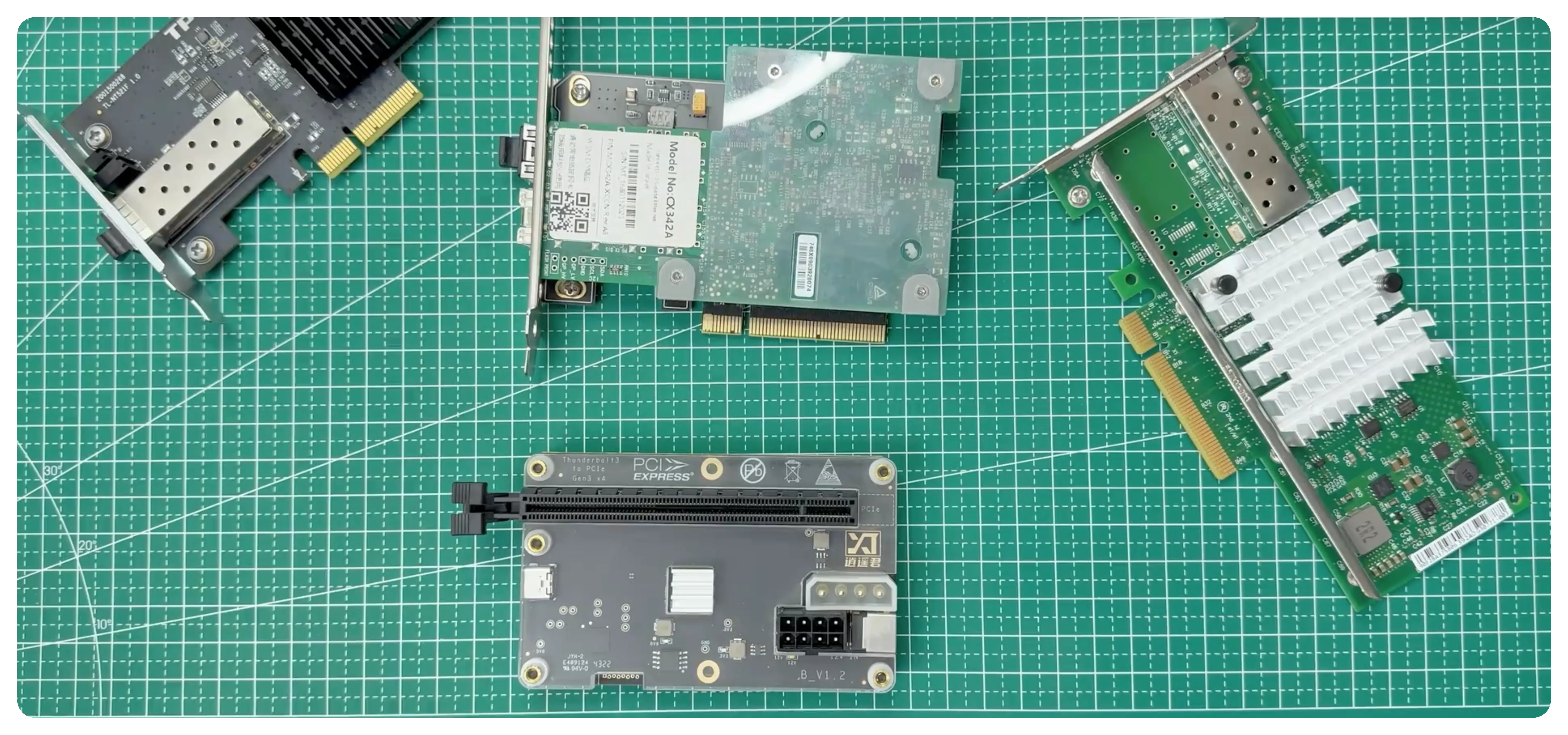

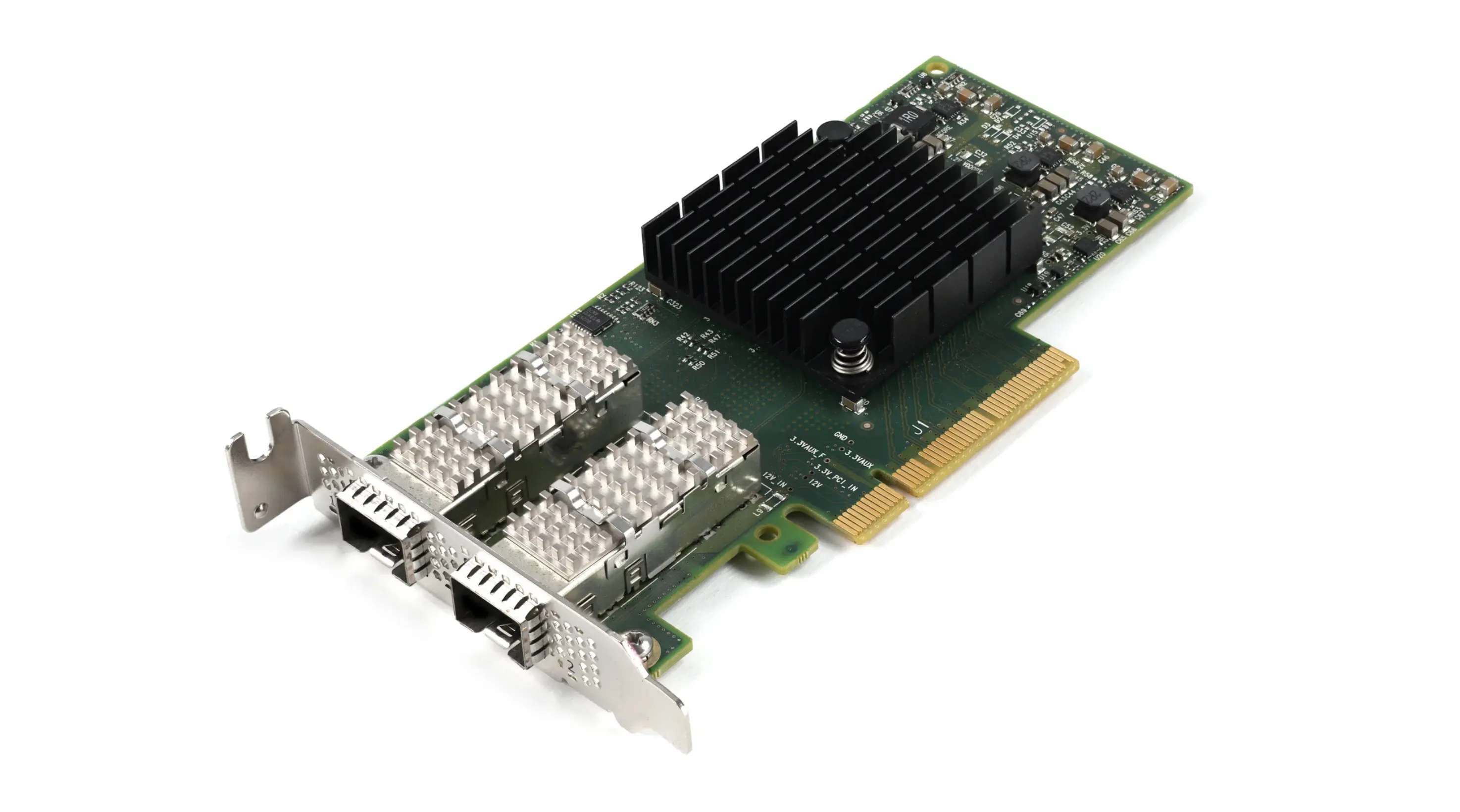

网卡鉴赏环节:

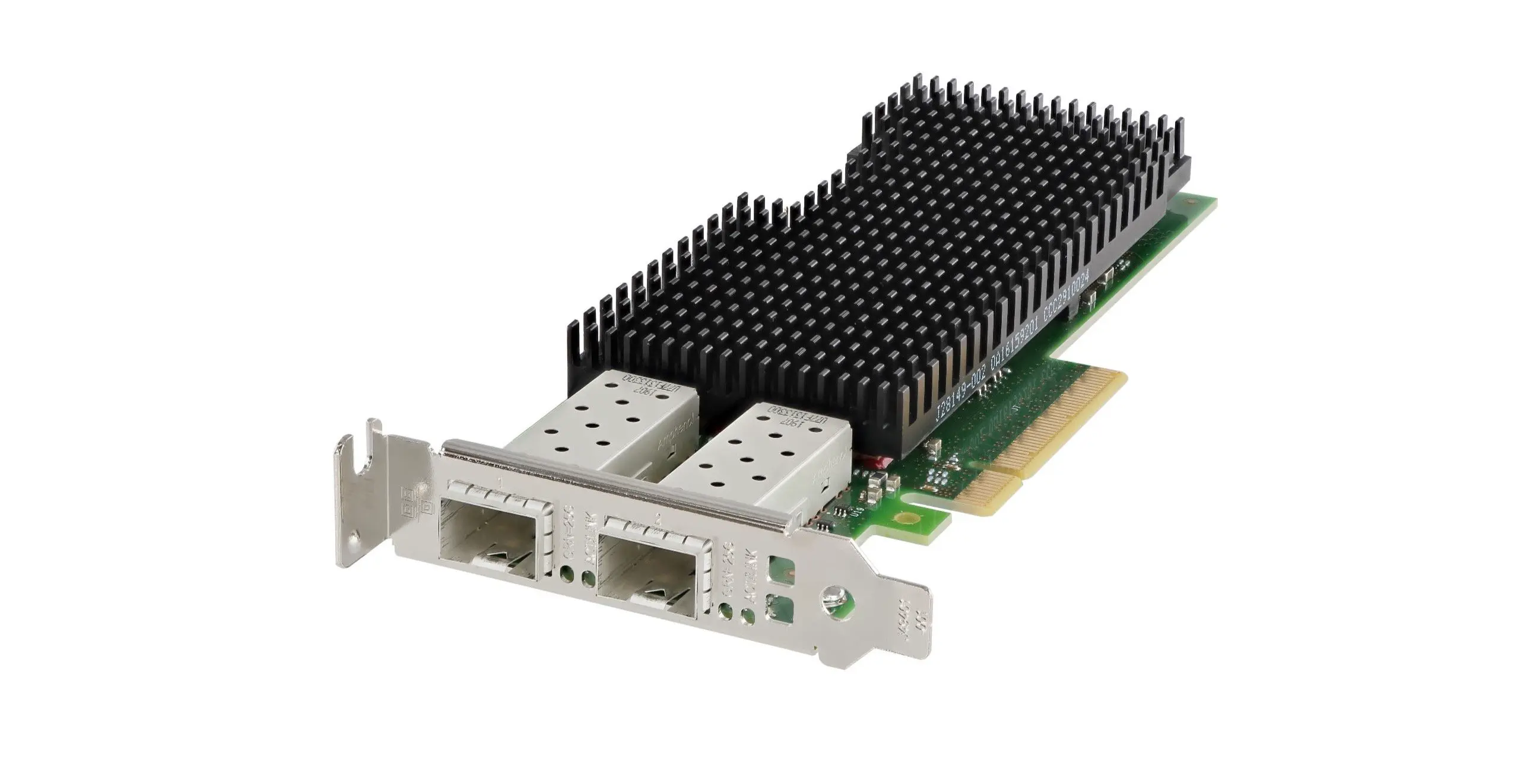

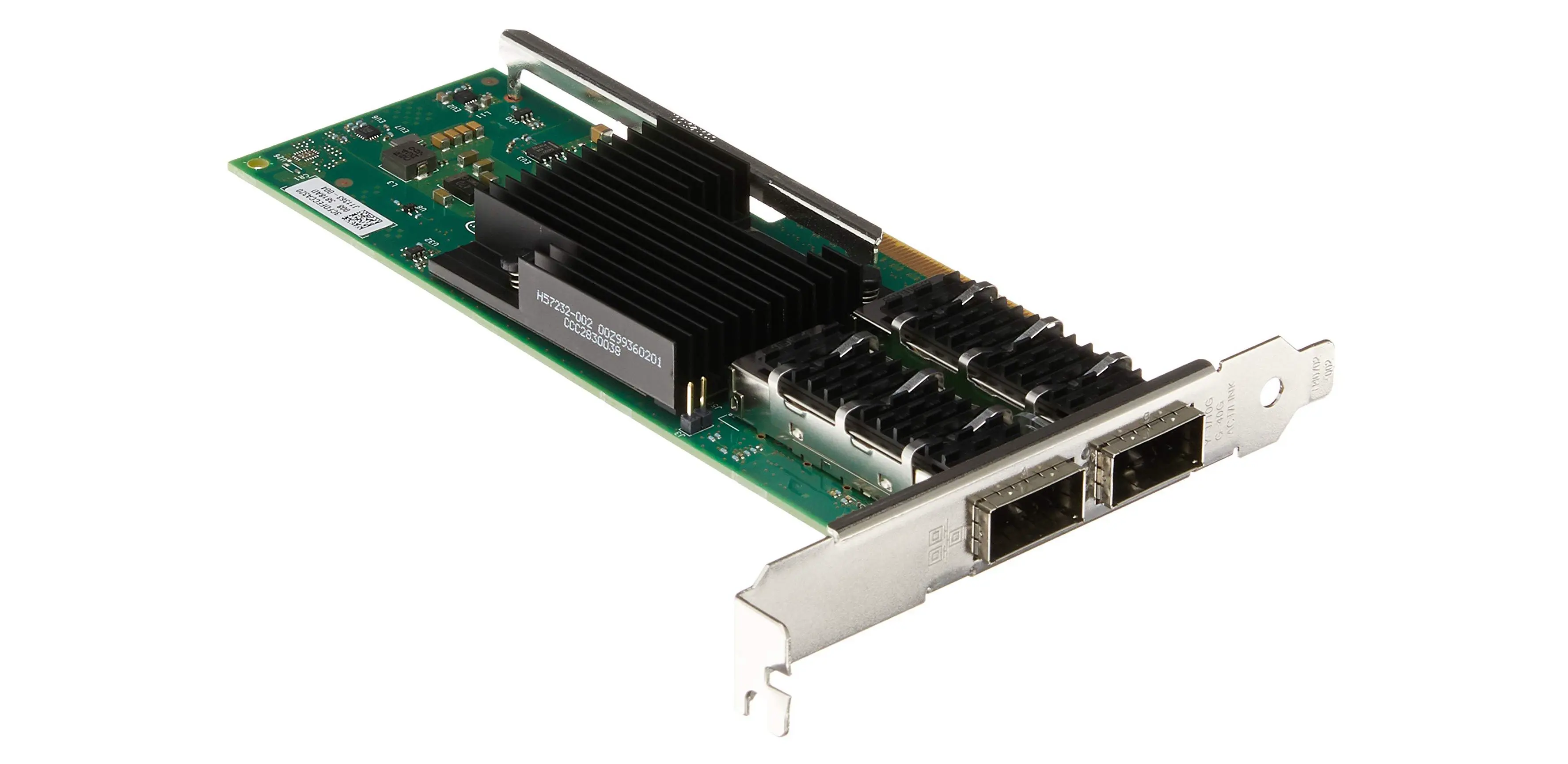

Intel XXV710-DA2 Network Card :

Intel XL710-DA2 Network Card:

Mellanox

| 型号 | 协议标准 | 接口类型 | 驱动 |

|---|---|---|---|

| CX4121A-ACAT ConnectX-4 | 25GbE | SFP28 | com.apple.DriverKit-AppleEthernetMLX5 |

最适合 MAC 的雷电 25G 网卡, 这位 Up 主使用

CX4121A-ACAT ConnectX-4网卡实现了在 Mac 下 25Gb 内网.糟了, 心动的感觉…..

这不 25Gb 和 40Gb 的方案不就有了 🤣🤣🤣

网卡选择

满足需求的似乎就只有 X520 和 X710 这 2 个产品类别, 但价格上 X520 肯定更便宜, 而且网上的成功案例绝大部分都是 X520, 因此决定购买 X520 的双网口版本.

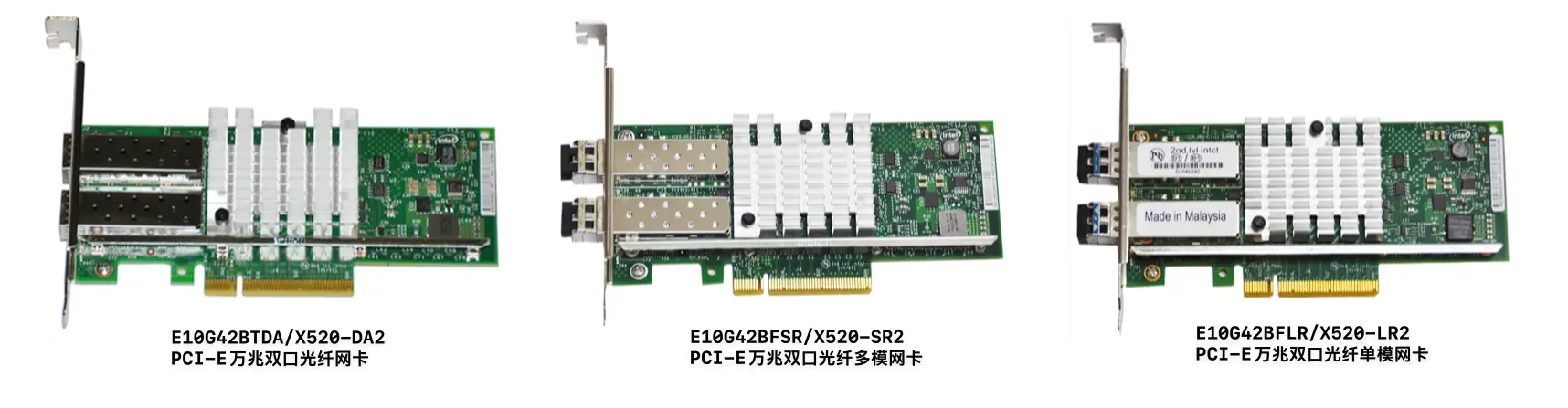

确认了网卡类别后, 就需要选择网口数量了, 我的需求是双光口, 而 Intel X520 双光口版本有多个, 分别是 Intel X520-DA2 & Intel X520-SR2 & Intel X520-LR2:

其中 SR 和 DA 的区别仅在于购买时 带不带光模块(SR 带, DA 不带). 而 Intel X520-LR2 则需要 单模 的光模块, 它的价格更贵.

X520 系列网卡的 Intel 82599 主芯片现在主要有 3 个型号: 82599EN 82599ES 82599EB , 他们三者的区别:

| 芯片型号 | 功耗 (典型) | 特点 | 应用场景 |

|---|---|---|---|

| 82599EB | 5.2W | 支持 SR-IOV, 企业级功能, 虚拟化支持, 性能最强 | 高性能企业数据中心, 虚拟化环境 |

| 82599ES | 4.8W | 类似于 EB, 去除 SR-IOV, 较低功耗, 适合高吞吐量应用 | 数据中心, 高带宽需求的网络设备 |

| 82599EN | 4.2W | 低功耗和低成本, 去除高级功能, 适用于成本敏感应用 | 嵌入式系统, 低功耗和低成本应用 |

SR-IOV 是一种 I/O 虚拟化技术, 允许单一的物理设备 (如网卡) 被虚拟化并分配给多个虚拟机, 使得多个虚拟机能够直接访问硬件资源, 而无需经过传统的虚拟化中间层 (如 hypervisor 或虚拟化驱动) . SR-IOV 的核心特点包括:

- **虚拟功能 (Virtual Functions, VFs)**:每个虚拟机被分配一个虚拟功能, 这些虚拟功能可以直接访问物理网卡的一部分资源.

- **物理功能 (Physical Function, PF)**:物理设备的主要功能, 它负责管理和分配虚拟功能, 并与虚拟机进行通信.

- 硬件直接访问:通过 SR-IOV, 虚拟机可以绕过操作系统和 hypervisor 的网络堆栈, 直接与物理硬件交互, 提高性能, 减少延迟和 CPU 使用率.

总结起来就是如果需要玩 ESXi 和 PVE 的话, 最好还是上 82599EB 芯片的 X520.

这三个型号中, 82599EN 只能支持单口万兆, 82599EB 和 82599ES 则都能支持双口万兆, 这是它们三者之间最显著的差异.

82599ES 相比 82599EB 则多了对 SFI(接 SFP+光模块) 和 10GBASE-KR(设备内部背板内接) 类型的支持, 对 SFI 接口的支持则表示 82599ES 芯片可以配合 SFP+ 模块使用, 也就是说 82599ES 相比 82599EB 多了对光口的支持, 最常用的 X520 双口光纤万兆网卡就是采用的 82599ES 芯片.

另外需要注意的是 X520 的总线类型是 PCIe 2.0 x8, 需要使用 PCIEx8 或 PCIEx16 的插槽, 如果使用 PCIEx4, 需要 3.0 版本, 否则无法达到线速, 下面贴一个 PCIe 各版本的的理论速度表:

| PCIe 版本 | x1 理论带宽 | x2 理论带宽 | x4 理论带宽 | x8 理论带宽 | x16 理论带宽 | 传输速率 |

|---|---|---|---|---|---|---|

| PCIe 2.0 | 0.5 GB/s | 1.0 GB/s | 2.0 GB/s | 4.0 GB/s | 8.0 GB/s | 5.0 GT/s |

| PCIe 3.0 | 0.985 GB/s | 1.969 GB/s | 3.938 GB/s | 7.877 GB/s | 15.754 GB/s | 8.0 GT/s |

| PCIe 4.0 | 1.969 GB/s | 3.938 GB/s | 7.877 GB/s | 15.754 GB/s | 31.508 GB/s | 16.0 GT/s |

| PCIe 5.0 | 3.938 GB/s | 7.877 GB/s | 15.754 GB/s | 31.508 GB/s | 63.015 GB/s | 32.0 GT/s |

| PCIe 6.0 | 7.563 GB/s | 15.125 GB/s | 30.25 GB/s | 60.5 GB/s | 121.0 GB/s | 64.0 GT/s |

一路从 Apple 原生驱动到对网卡的关知识的基础了解, 最终确定选购的网卡为: E10G42BTDA/X520-DA2, 目前二手价格也非常便宜, 应该算是最具性价比的万兆网卡.

参考:

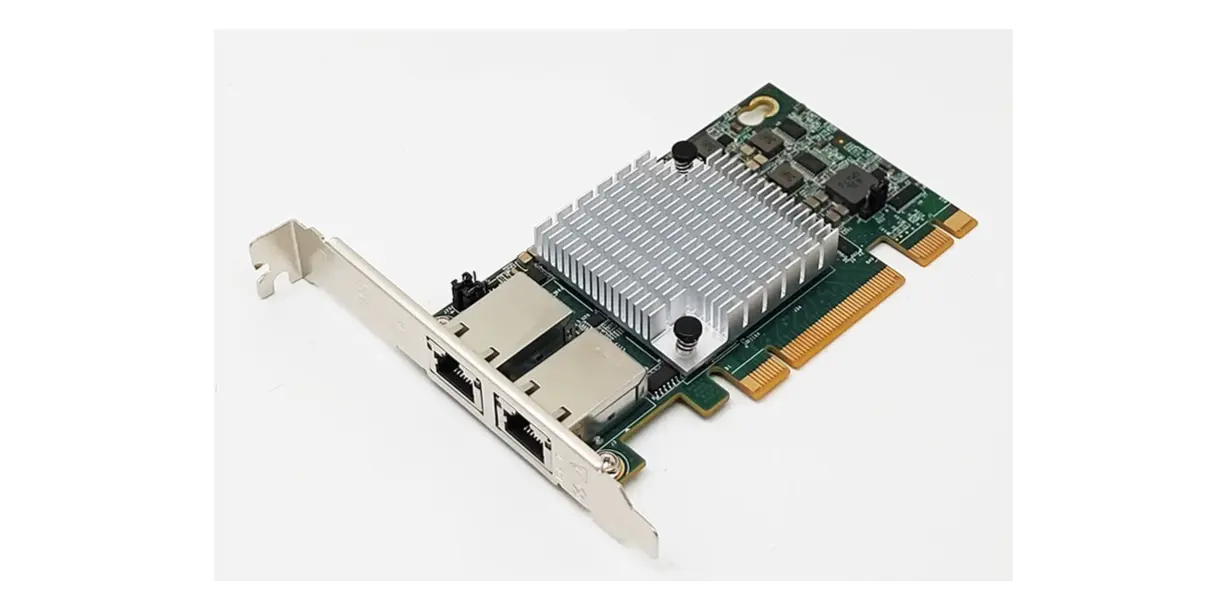

Station 网卡

Station 主机原来有一张浪潮的 X540 万兆双电口网卡:

这张卡可以称得上是 年轻人的第一张万兆网卡, 价格低的离谱, 因为这个卡是非标准的 x8+x1, 买回来不能直接用, 需要魔改一下(小黄鱼有成品), 参考 双口万兆网卡低到 40 元, 这个万兆网卡性价比天花板 就行.

现在的问题是大热量大, 所以索性就一次性全部换成 E10G42BTDA/X520-DA2, 还能少买 2 个光转电模块.

M920x 网卡

网卡也是 Intel X520-DA2, 但是上次拆机时发现 PCB 已经弯曲变形了(不过并不影响使用), 等彻底报废的时候再考虑更换(或者下次升级到 40Gb? 😎)

网卡信息(82599ES 芯片):

1 | $ inxi -n |

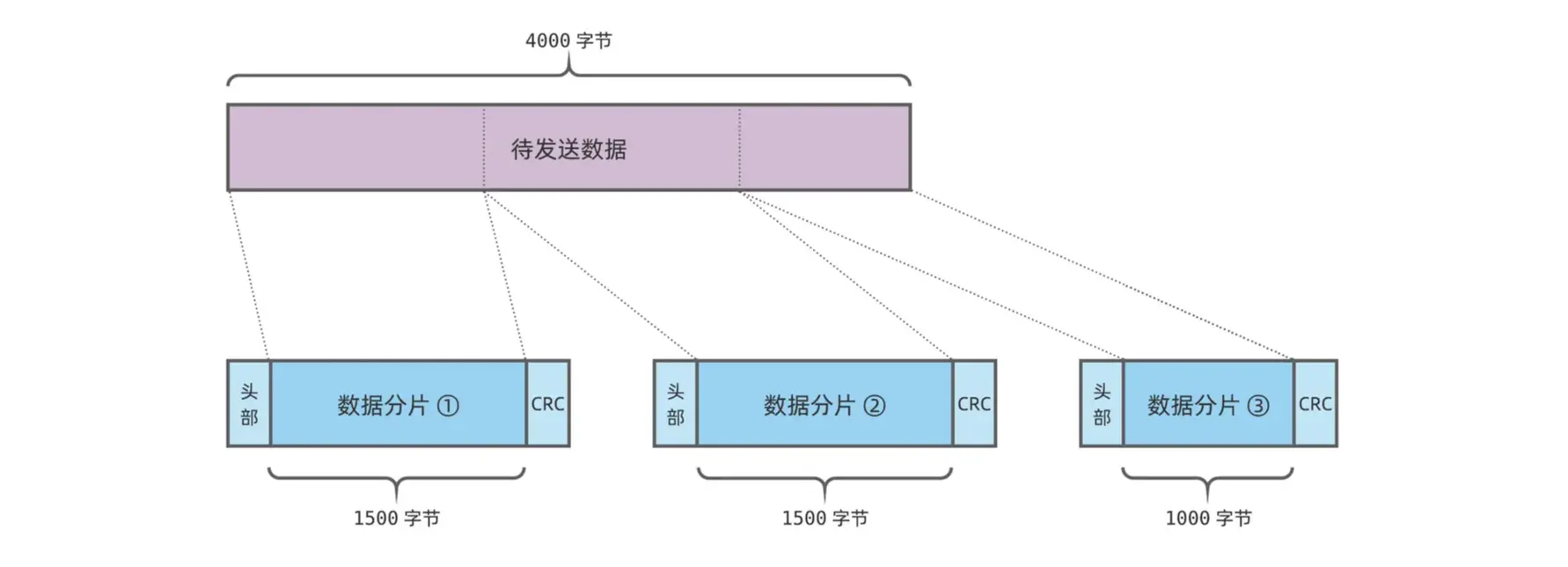

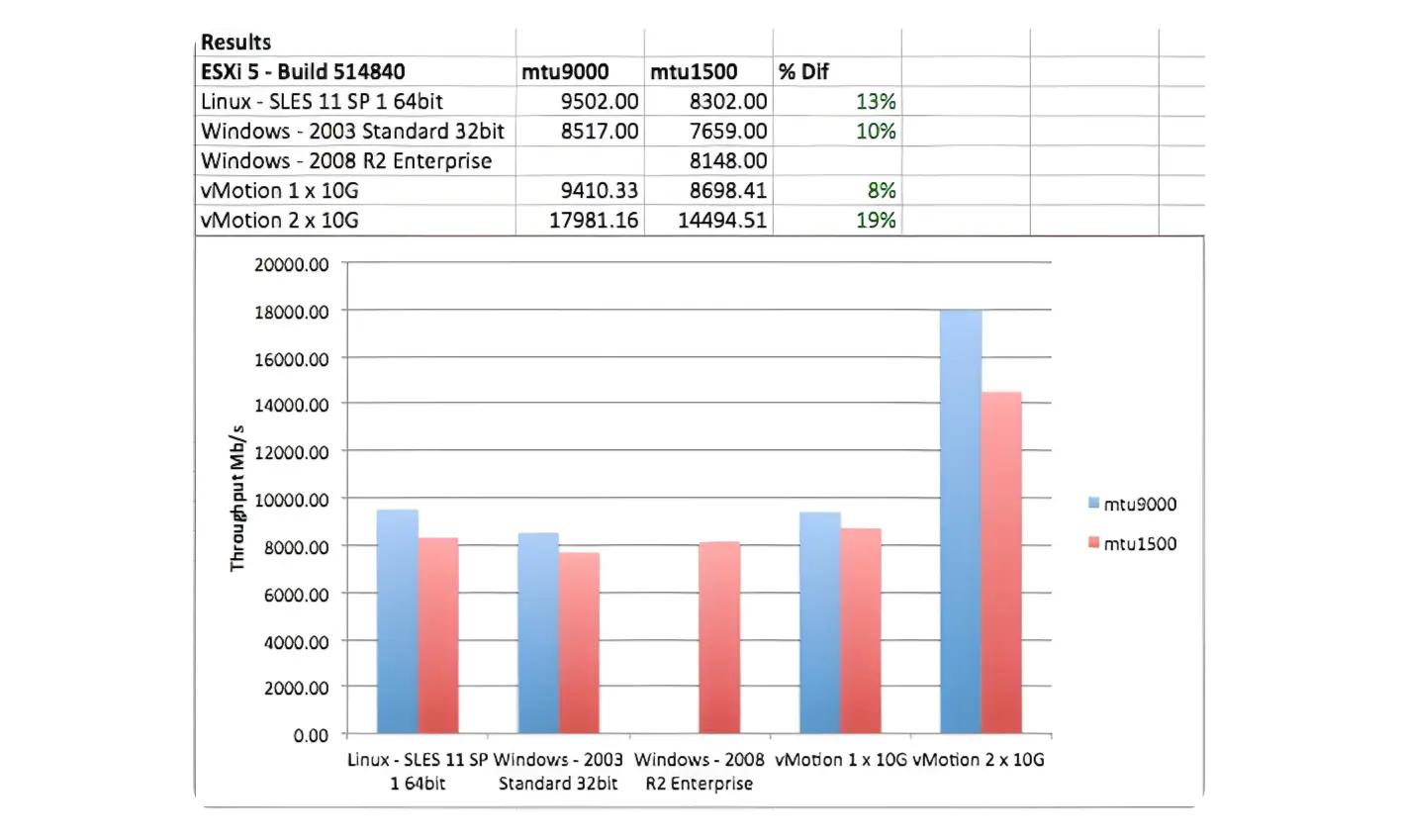

最大传输单元 MTU (Maximum Transmission Unit) , 是指网络能够传输的最大数据包大小, 以字节为单位. MTU 的大小决定了发送端一次能够发送报文的最大字节数. 如果 MTU 超过了接收端所能够承受的最大值, 或者是超过了发送路径上途经的某台设备所能够承受的最大值, 就会造成报文分片甚至丢弃, 加重网络传输的负担. 如果太小, 那实际传送的数据量就会过小, 影响传输效率.

假设待发送的数据总共 4000 字节, 假设以太网设备一帧最多只能承载 1500 字节. 很明显, 数据需要划分成 3 片, 再通过 3 个帧进行发送:

MTU 的特点

| 特点 | 描述 |

|---|---|

| 默认值 | 以太网设备的 MTU 默认为 1500 字节. |

| 影响 | 过小:更多数据包, 增加 CPU 和网络设备的开销. 过大:可能导致设备间不兼容, 数据包丢弃或分片. |

| 分片问题 | 当数据包大小超过 MTU 时, 网络需要对数据包进行 分片, 可能增加延迟并带来丢包风险. |

| 适配场景 | 不同场景下应根据需要调整 MTU, 以平衡性能和兼容性. |

巨型帧

| 特点 | 描述 |

|---|---|

| 定义 | 将 MTU 设置为 9000 字节 或更大, 通常用于高性能传输场景. |

| 优势 | 降低包头开销; 减少拆分与重组操作; 提高大文件传输效率 (约提升 10%-20%) |

| 劣势 | 无 IEEE 标准, 可能存在兼容性问题; 需要网卡和交换机都支持巨型帧模式 |

| 适用场景 | 大型文件传输、NAS 数据同步等高带宽需求场景. |

当你在特定的网络任务下将 MTU 从 1500 设置为 9000, 会发现网络文件传输速度会有 10-20%的提升. 这是因为在巨型帧模式下, 网络传输设备相应地减少了拆开、组合数据包的次数, 一个巨型帧的数据包可以携带之前多个数据包所携带的数据量, 在大型文件传输的时候效率也就自然提高了.

使用建议

双网卡双网络:

- 一个网络使用默认的 MTU (1500), 用于日常上网.

- 另一个网络使用巨型帧 (9000), 用于高性能存储数据传输.

这正好符合我现在的网络环境(一电信宽带, 一联通宽带).

参考:

交换机

我对交换机的要求为:

- 能够设置 MTU;

- 至少 8 个网口, 可以是 4 电口+ 4 光口, 也可以是 8 光口;

- 体积不能过大, 最好没有内置散热, 需要时我可执行添加外置散热风扇随时启停;

交换机大致分为 非管理型交换机(傻瓜交换机), 二层管理交换机 和 三层管理交换机.

傻瓜交换机的工作原理是通过学习每个设备的 MAC 地址, 将设备的 MAC 地址和连接的端口映射到一个内部表 (称为MAC 地址表) , 当数据包进入交换机时, 交换机会查看数据包的目标 MAC 地址, 并查找对应的端口:

- 如果 MAC 地址在表中, 数据包直接转发到目标端口;

- 如果 MAC 地址不在表中, 交换机会将数据包广播到所有端口 (除源端口外) ;

傻瓜交换机的优势是简单, 不需要任何配置即可工作、便宜、稳定, 非常适合没有网络管理需求的场景.

要满足 MTU 可设置的需求, 则必须上二层或三层交换机, 那下面对两类交换机做个简单的对比.

二层 Or 三层

| 特性 | 二层交换机 | 三层交换机 |

|---|---|---|

| 工作层级 | 数据链路层 (OSI 模型的第 2 层) | 网络层 (OSI 模型的第 3 层) |

| 主要功能 | 1. 根据 MAC 地址转发数据 2. 提供 VLAN 支持 |

1. 基于 IP 地址转发数据 2. 提供路由功能 |

| 应用场景 | 1. 局域网内部设备互联 2. 适用于小型网络 |

1. 跨子网通信 2. 适用于大型网络与多子网 |

| 硬件性能 | 1. 通常转发速度更快 2. 成本较低 |

包含路由功能, 成本较高 |

| VLAN 支持 | 支持 VLAN 的划分, 但需通过三层设备进行跨 VLAN 通信 | 支持跨 VLAN 路由, 直接实现不同 VLAN 间通信 |

| 路由功能 | 不支持路由功能, 依赖外部路由器 | 内置路由功能, 可直接实现网络互联 |

| 广播范围 | 广播域受 VLAN 限制 | 可隔离广播域, 减少广播对网络的影响 |

| MTU 支持 | 1. 仅负责在二层转发, 不解析 IP 报头 2. 不支持对 MTU 的动态调整 |

1. 可基于三层协议对 MTU 进行动态调整 2. 支持最大传输单元的优化配置 |

MTU 的对比

二层交换机中的 MTU

- 仅在数据链路层转发帧, 对 IP 分片和 MTU 超过时的处理不敏感.

- 不支持动态调整, 默认 MTU 通常为 1500 字节, 适用于一般以太网传输.

三层交换机中的 MTU

- 在网络层处理 MTU 时, 支持动态调整或告警 (如 ICMP “Fragmentation Needed” 消息) .

- 支持更高 MTU (如 Jumbo Frame, 通常为 9000 字节) , 可减少分片开销, 提升网络传输效率.

- 更适合高性能网络环境, 如数据中心或存储传输.

适用场景

二层交换机:

- 小型网络中设备互联.

- 只需要在单一 VLAN 内通信时.

- 适用于预算有限的简单网络需求.

三层交换机:

- 需要跨子网通信或跨 VLAN 数据转发时.

- 中大型网络中, 减少路由器的使用, 优化性能.

- 需要隔离广播域以降低网络负载时.

所以家用万兆的话, 二层管理型交换机是最基本的硬件配置.

产品选择

| 厂商 | 型号 | 网口 | 管理类型 | 全新价格 | 二手价格 |

|---|---|---|---|---|---|

| TP-LINK | TL-ST5008F | 8 个 10G 光口 + Management + RJ45 Console 口 | L3 | 1723 | 500+ |

| TP-LINK | TL-ST2408PB | 4 个 10G 电口(PoE) + 4 个 10G 光口 | 云管理 | 1999 | 无 |

| 兮克 | SKS7300-4X4T | 4 个 10G 电口 + 4 个 10G 光口 + RJ45 Console 口 | L2 | 1379 | 1000+ |

| 兮克 | SKS8310-8X | 8 个 10G 光口 + RJ45 Console 口 | L3 | 749 | 无 |

| 兮克 | SKS8300-8X | 8 个 10G 光口 + RJ45 Console 口 | L3 | 899 | 600+ |

| 希力威视 | SR-ST1808F | 8 个 10G 光口 | L3 | 599 | 无 |

| 希力威视 | SR-ST3408F | 4 个 10G 电口 + 4 个 10G 光口 + RJ45 Console 口 | L3 | 1139 | 800+ |

| 希力威视 | SR-ST3808F | 8 个 10G 光口 + RJ45 Console 口 | L3 | 699 | 400+ |

| 海思视讯 | F1100W-4SX-4XGT | 4 个 10G 电口 + 4 个 10G 光口 | 轻管理型 | 1159 | 无 |

| 海思视讯 | F1100W-8SX-SE | 8 个 10G 光口 + RJ45 Console 口 | 轻管理型 | 499 | 无 |

上面这些是比较常见且符合需求的万兆交换机, 其他的品牌没有使用过不是很了解.

4 光 + 4 电 的方案应该是最合适的, 但是二手价格还是居高不下, 所以在对比后最终选择了 TP-LINK 的 TL-ST5008F, 二手价格还能接受, 且是三层管理型交换机, 可玩性更高.

MBP 万兆最终方案

首选方案

前面 MBP 万兆参考方案 中一直存在些许顾虑: 一是 MBP 芯片和系统跟我不一样, 二是我需要双光口万兆网卡, 上述方案没有给到我是否兼容.

如果无法驱动该网卡, 可能需要借助 SmallTree 的驱动来解决. 然而, 这意味着我可能需要修改驱动的 PID 和 VID 才能正常工作, 这感觉有点复杂. 此外, 如果系统升级导致无法识别网卡, 我将不得不再次进行修改.

所以我更倾向于在 M1 系列的 MBP 上能够免驱的网卡.

好在了解了大致的方案以及对 MBP 原生网卡驱动的了解 后结合他人成功的案例, 最终敲定了首选方案:

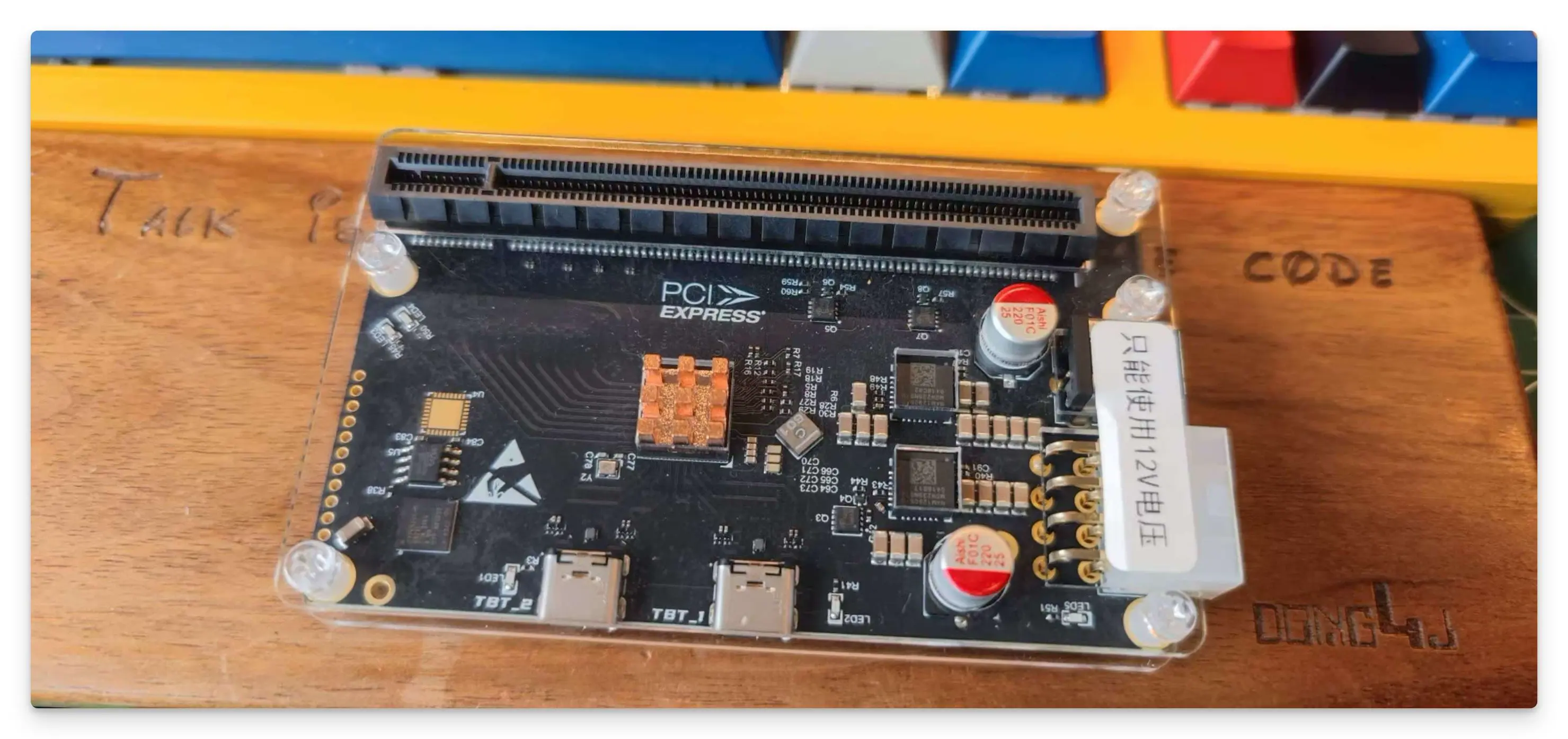

- 使用雷电扩展坞 (JHL7540) 方案(价格 345);

- 使用 Intel X520-DA2 双光口万兆网卡(82599 芯片, 价格 80);

12V DC 电源和雷雳 3 线缆家里都用, 就不算到成本里面了.

不要去搜 白苹果+X520, 价格会高出很多.

看中的是具备下行雷雳接口, 可以组菊花链玩玩.

备选方案

- ITGZ USB4.0 移动雷雳 4 硬盘盒(239);

- M2 NVME 转 PCIe 转接板(15);

- 12V DC 转 SATA 供电线(16);

- Intel X520-DA2 万兆网卡 (80);

想对 2 种方案做个对比, 即使备选方案失败或达不到要求, 也能将硬盘盒给 Mac mini M2 使用.

网络拓扑

现状

我先梳理一下交换机和设备的总体情况:

- Mac mini 2018 和 Mac mini M2 自带 10G 电口;

- DS923+ 和 Mac mini 2018 组了万兆网络, 其他设备全部使用 2.5G 网口连接(10G 口不够);

- Station 的 10G 电口跑步满万兆, 因为万兆网口不够, 只能跑在 2.5G 带宽下;

- M920x 的 2 个 10G 光口通过 DAC 分别连接到电信和联通网络, 但也只是 2.5G;

目前的现状总结一下就是: 具备万兆带宽能力的设备因为交换机的问题, 最高只能使用 2.5G 带宽, 万兆网络仅限于 NAS 和 Mac mini 2018, 无法满足其他设备的万兆需求.

规划

- 添加一台万兆交换机, 将书房所有支持万兆的设备互联(万兆交换机已确认为 TP-LINK 的 TL-ST5008F);

- 电信网络作为 万兆主干网, 电信后面 2.5G 交换机的 10G 光口需要连接到万兆交换机, 因为距离较短, 直接使用 M920x 上的 DAC 线缆连接;

- DS923+ 和 Mac mini 2018 通过原来的光模块连接到万兆交换机, 新增 1 个光转电模块给 Mac mini M2 连接到万兆交换机, 3 台设备其他网口连接到联通的 2.5G 网络;

- MBP 和 Station 配置 Intel X520-DA2 网卡 , 分别连接到电信和联通万兆网络, 电信网络全设备万兆, 联通网络只有 MBP 和 Station 能够万兆直连;

- M920x 原来剩下的一根 DAC 线缆连接连接万兆交换机, 与其他设备组成万兆局域网, 另一个万兆光口通过光纤+光模块连接联通后面 2.5G 交换机上的 10G 光口以接入联通网络;

将电信作为万兆主干网, 并将各设备的电信网卡作为第一优先级, 平时在各设备共享文件时就能用上万兆网络. 联通作为备用网络, 全设备最低也是 2.5G 速度.

设备购买

梳理之后所需要的设备清单为:

| 设备名称 | 规格 | 数量 | 单价 | 备注 |

|---|---|---|---|---|

| TL-ST5008F V2.0 | 8 个 10G 光口 | 1 | 580 | 具备三层网络管理功能(需要修改 MTU 用) |

| 光转电模块 | 万兆 | 1 | 120 | Mac mini M2 使用 |

| 万兆网卡 | Intel X520-DA2 | 2 | 80 | MBP, Station 各一张 |

| 光纤 | 多模双芯 OM3, LC 型光纤接口 | 5 | 5 | 2 * 1 米, 1 * 2 米, 2 * 5 米 共计 5 条 |

| 光模块 | SFP-10G-SR | 10 | 9 | 一条光纤 2 个光模块 |

| 雷电扩展坞 | JHL7540 主控 | 1 | 345 | MBP 万兆首选方案 核心设备 |

| ITGZ USB4.0 移动雷雳 4 硬盘盒 | ASM2464PD 主控 | 1 | 239 | MBP 万兆备选方案 核心设备 |

| M2 NVME 转 PCIe 转接板 | - | 1 | 15 | MBP 万兆备选方案 配件 |

| 12V DC 转 SATA 供电线 | - | 1 | 16 | MBP 万兆备选方案 配件 |

这次升级的总成本为 1590, 比直接买一个高端成品万兆网卡便宜, 而且还能将主要设备全部升级成万兆, 感觉还是挺划算的.

为什么不全部使用 DAC/AOC 线缆

我的万兆设备都在书房, 最优解还是 DAC 线缆, 距离肯定没有问题(最长支持 10 米), 问题是 DAC 的线缆相对于光纤太粗太硬, 对于我现在的布线环境不是特别好处理, 而 AOC 线缆在 M920x 连接万兆光口时已经尝试过一次, 还是存在兼容性问题, 所以放弃了.

最主要的原因是想尝试一下光纤+光模块的方案, 顺带还可以学习了解下光纤相关的技术.

施工环节

硬件

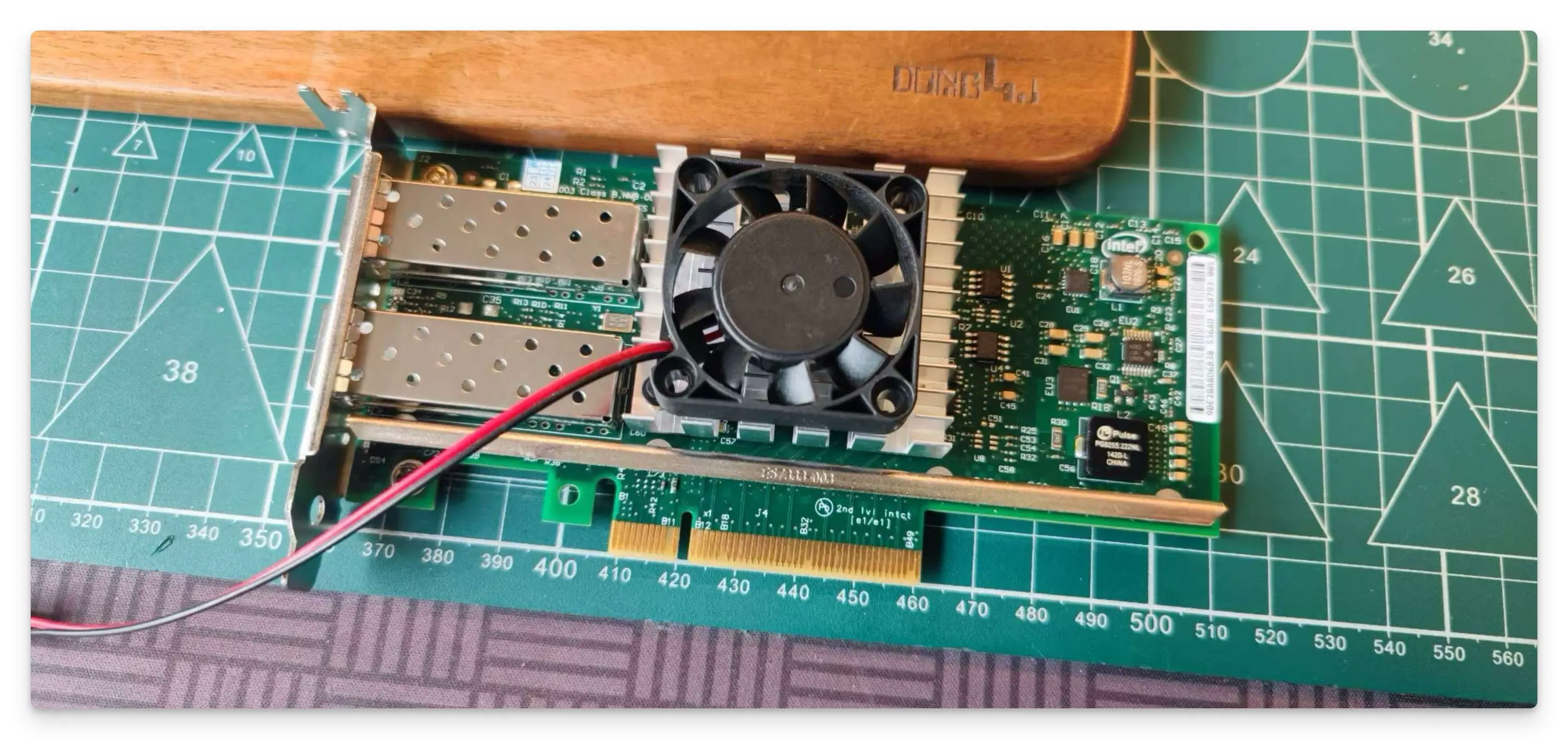

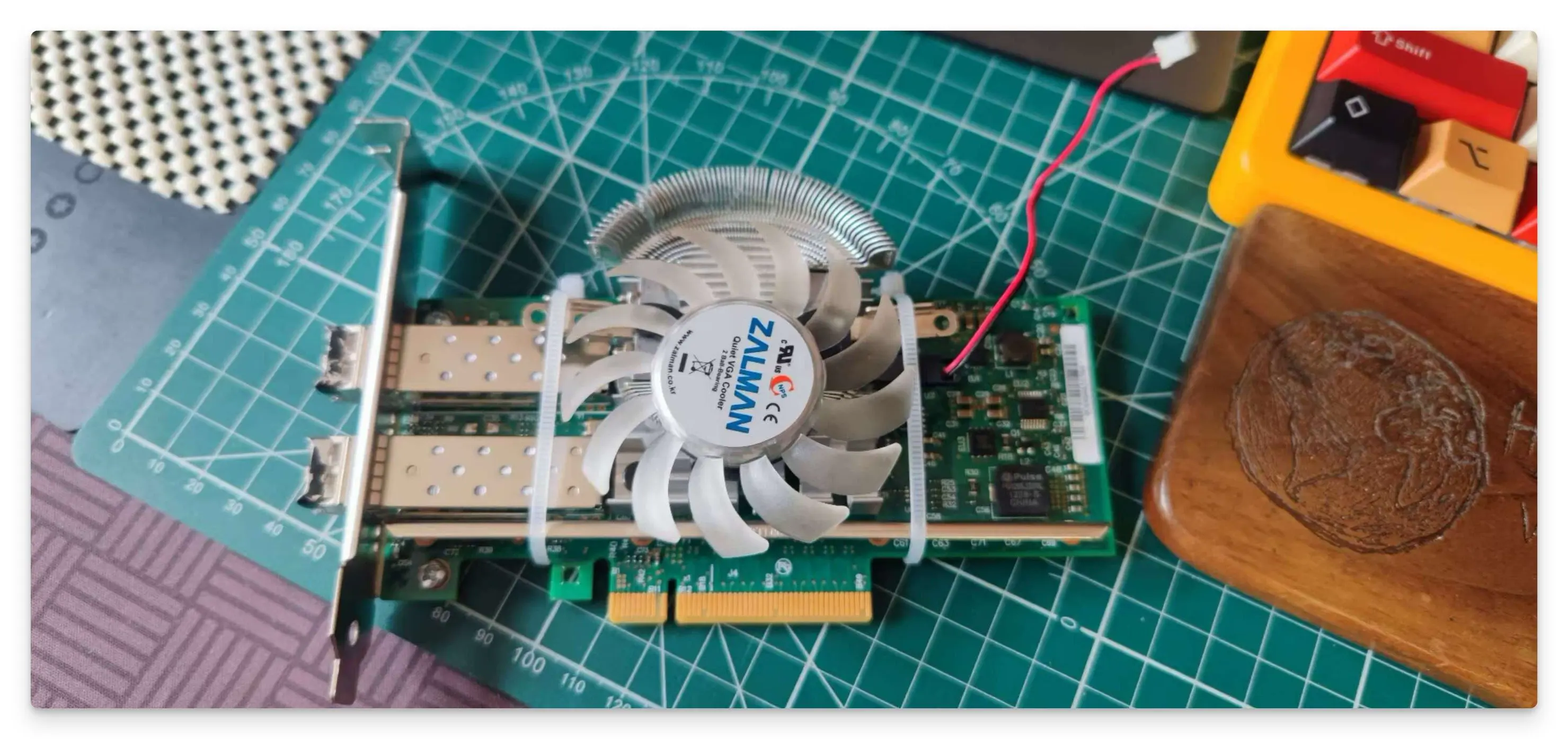

加装散热

给 MBP 和 Station 使用的 Intel X520-DA2 网卡还是有必要加上散热风扇的, Station 是开放型机箱, 没有可靠的风道可以散热, MBP 就更不用说了, 只能外置.

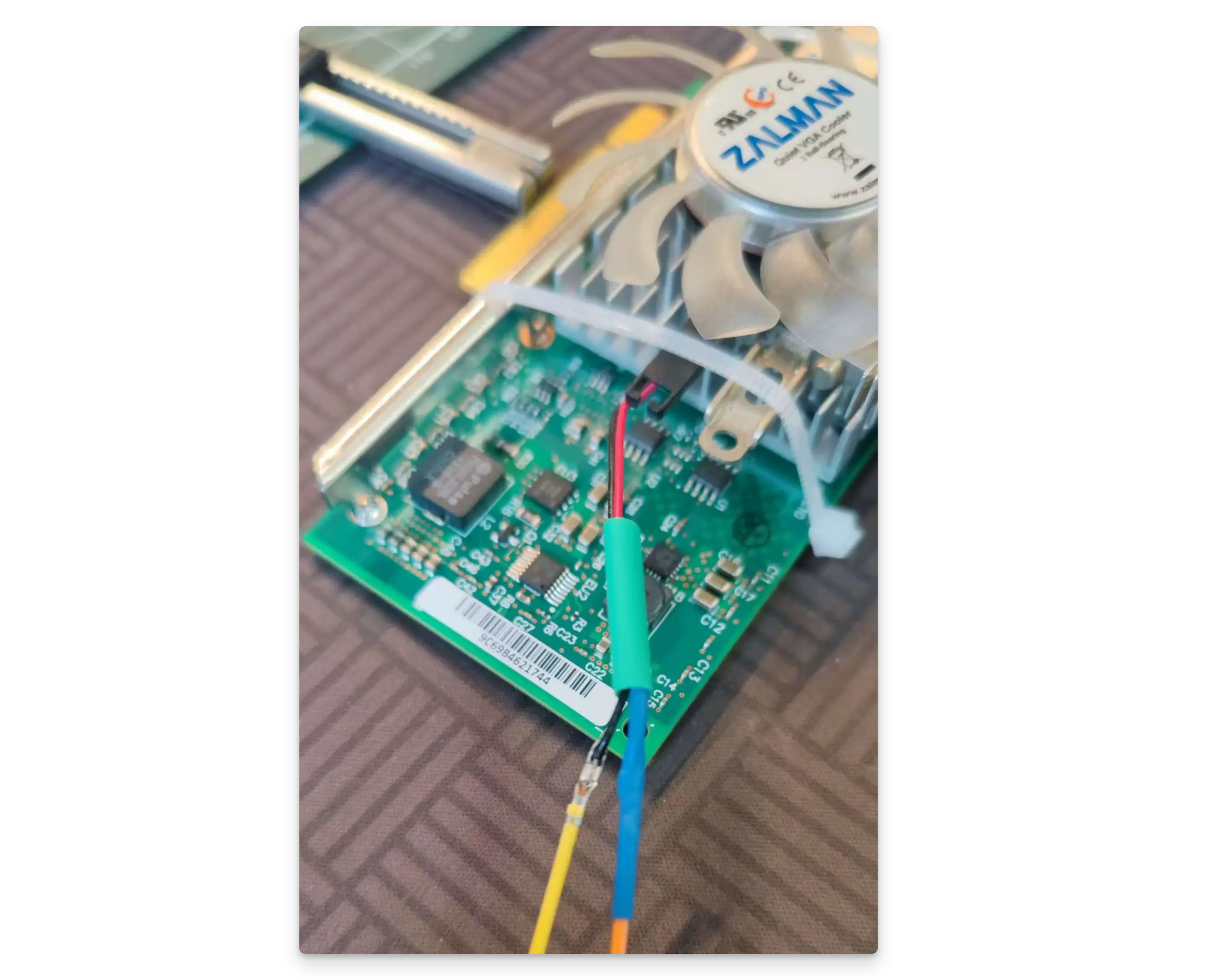

还好有几个剩余的 4x4 CM 风扇, 怼上去就可以了, 直接用 USB 供电:

给 Station 用的网卡就麻烦点, 用的是原来给浪潮 X540 配置的风扇, 但是供电线太短了, 需要外接.

用玩树莓派时购买的 2PIN 2.54 杜邦线来延长一下供电线, 套上热缩管做绝缘:

给点电就转, 完美:

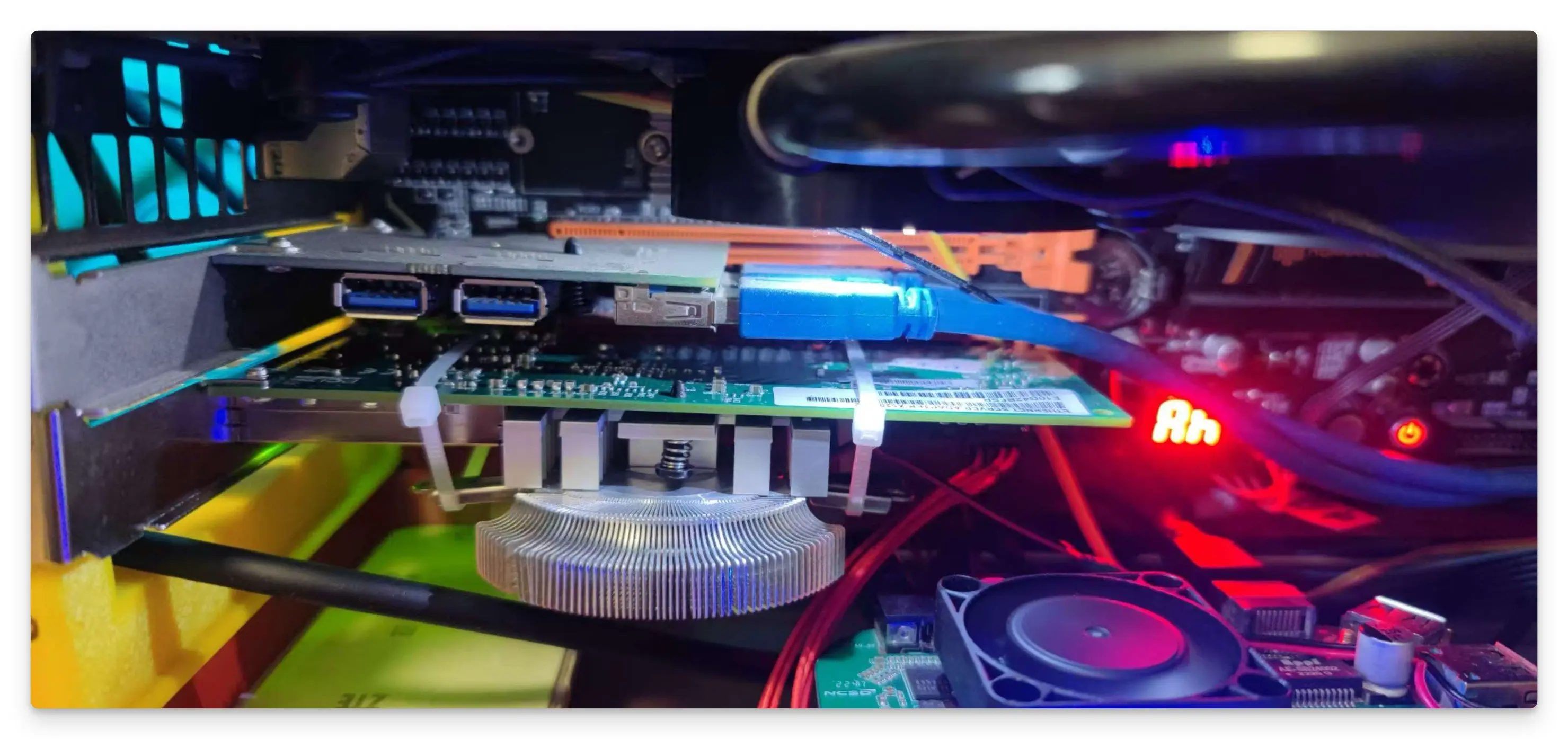

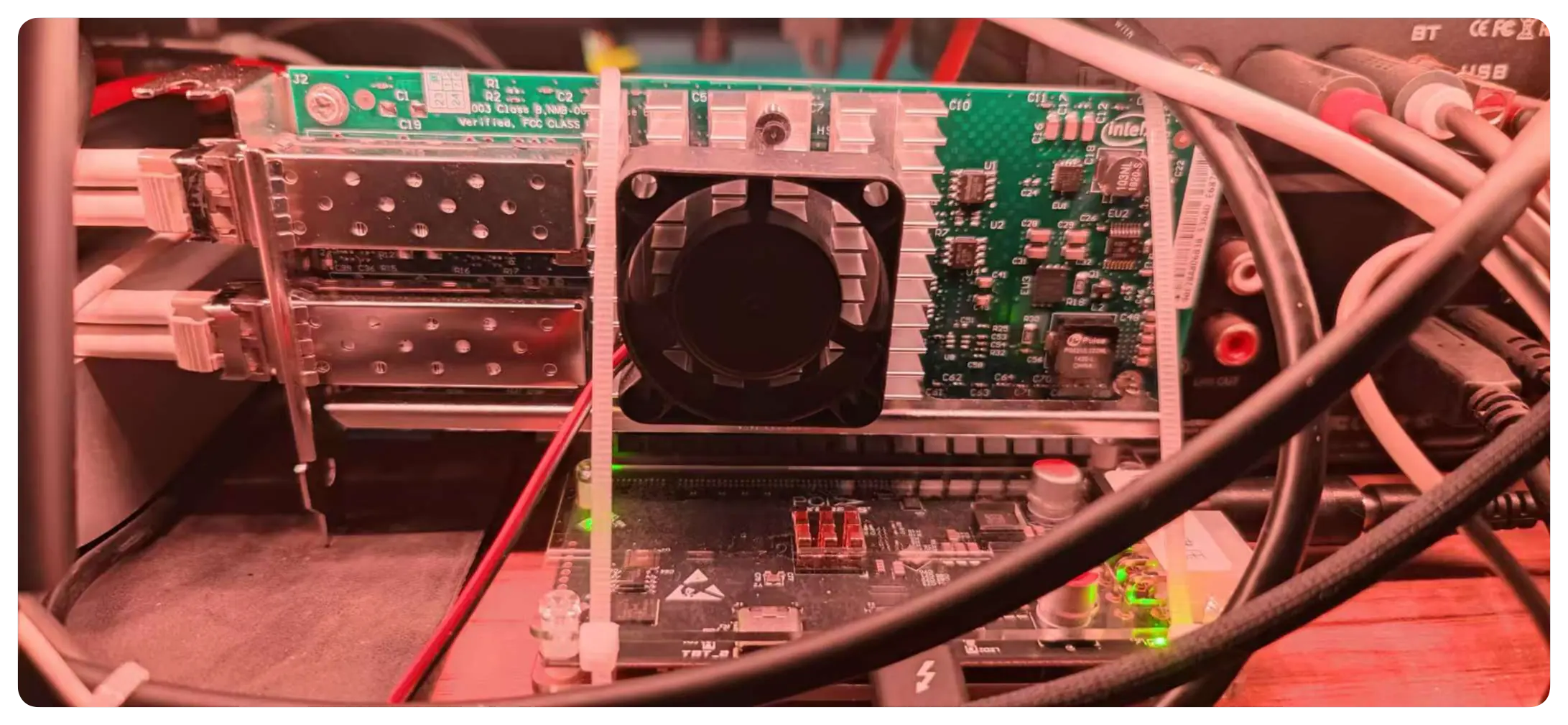

上机效果:

顺便给交换机加个 80x80cm 的散热风扇, 反正空余的散热风扇还有很多:

MBP 网卡部署

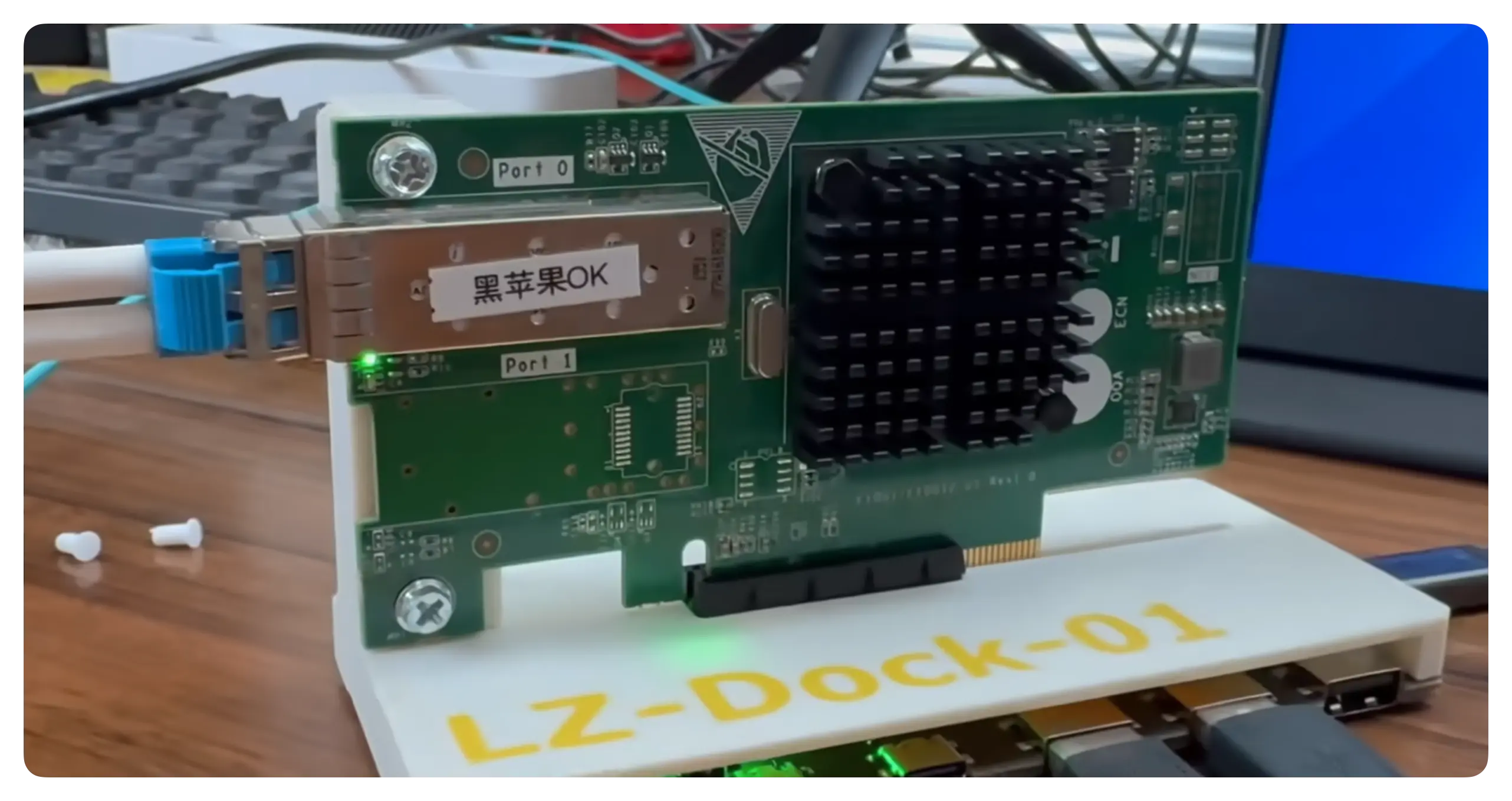

小巧的雷雳拓展坞, 自带一个散热片, 桌面下正好留有一个 12V DC 供电线, 省去了供电线.

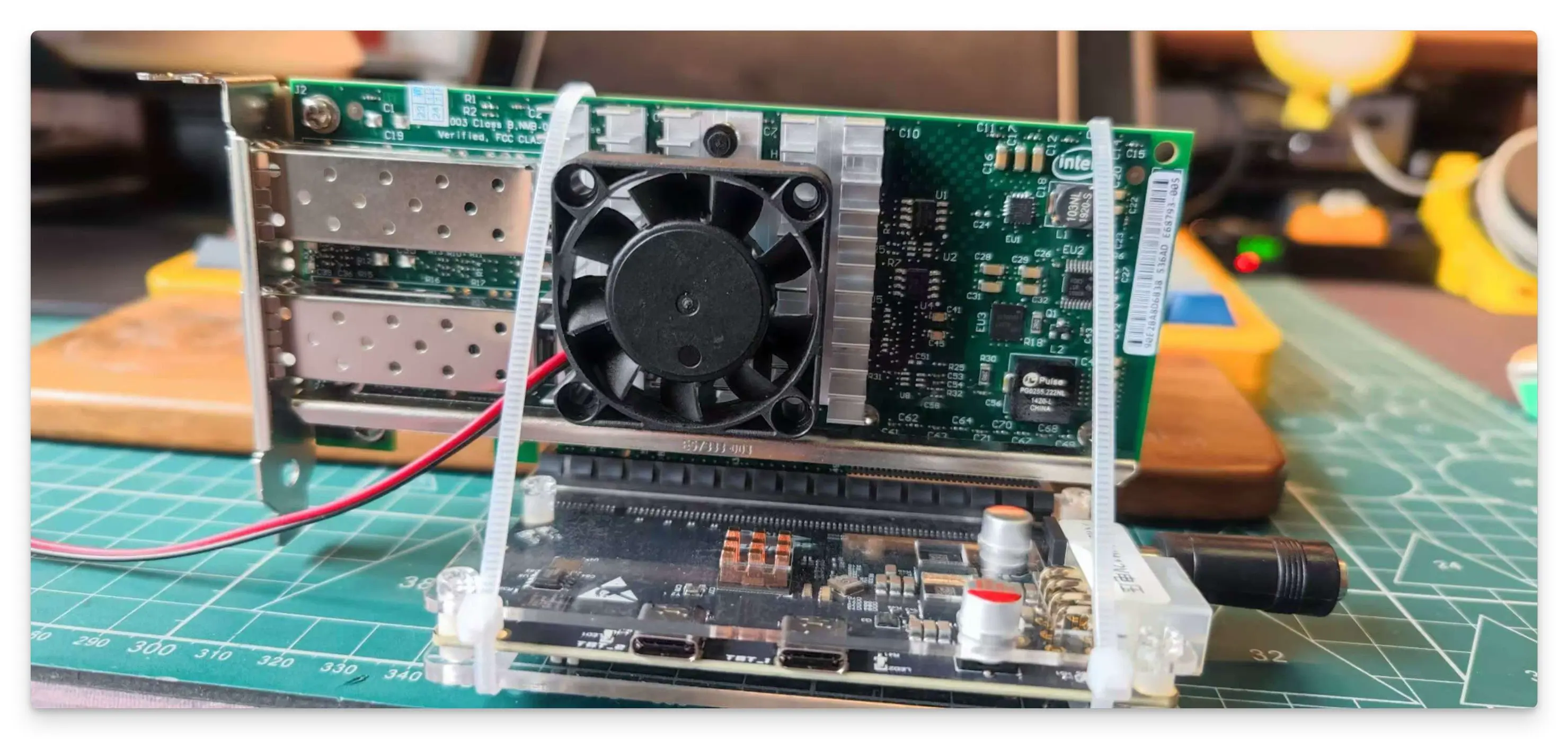

组合后的样子, 加了 2 根扎带固定一下, 省去了一个 3D 打印支架:

最后安装好的样子, 平时基本上不用动它. 用一根雷雳 3 的线连接到 MBP, 剩下的下行雷雳接口还未使用, 反正不能用这个雷雳接口连接到 Mac mini M2 上组菊花链, 会存在争抢网卡的情况:

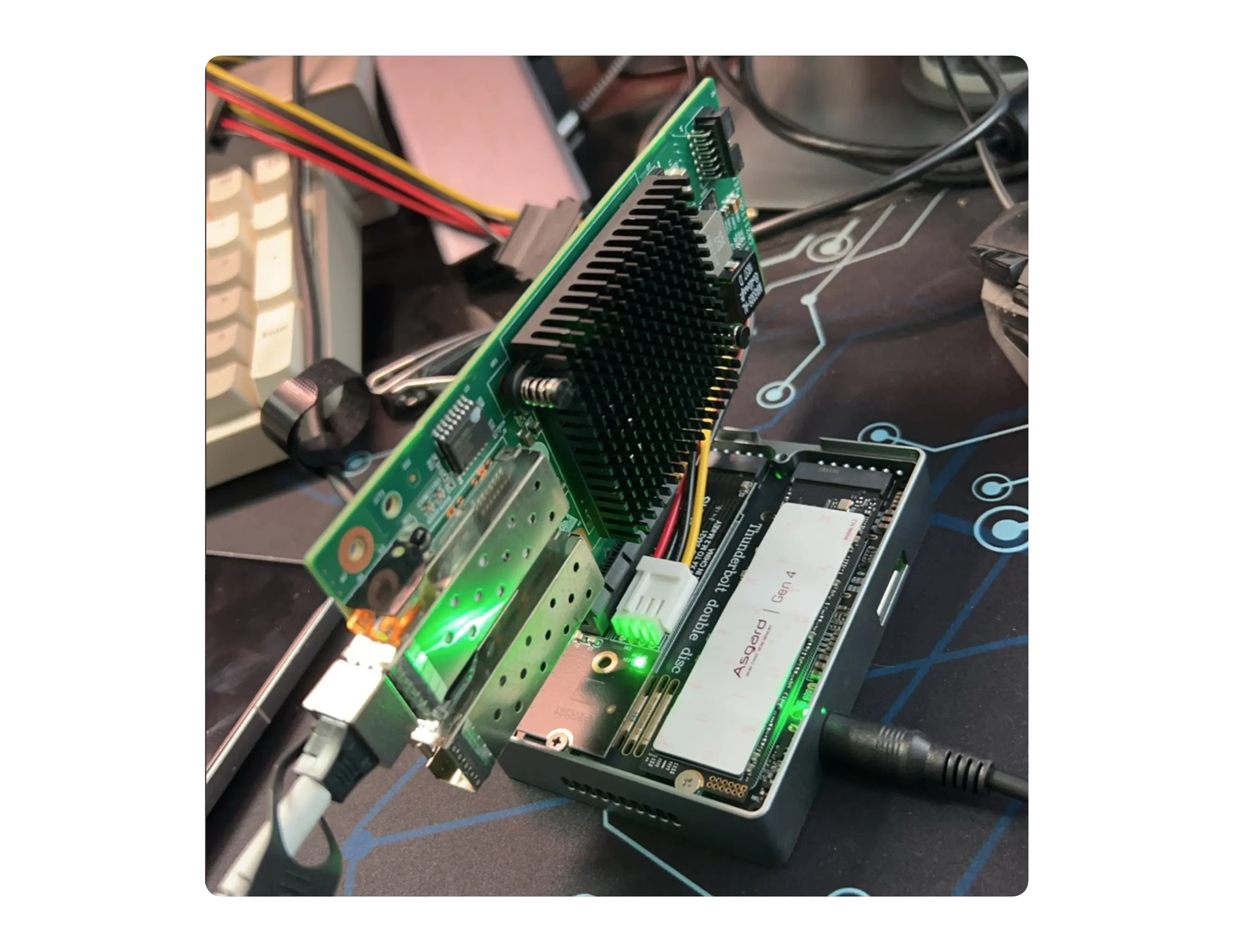

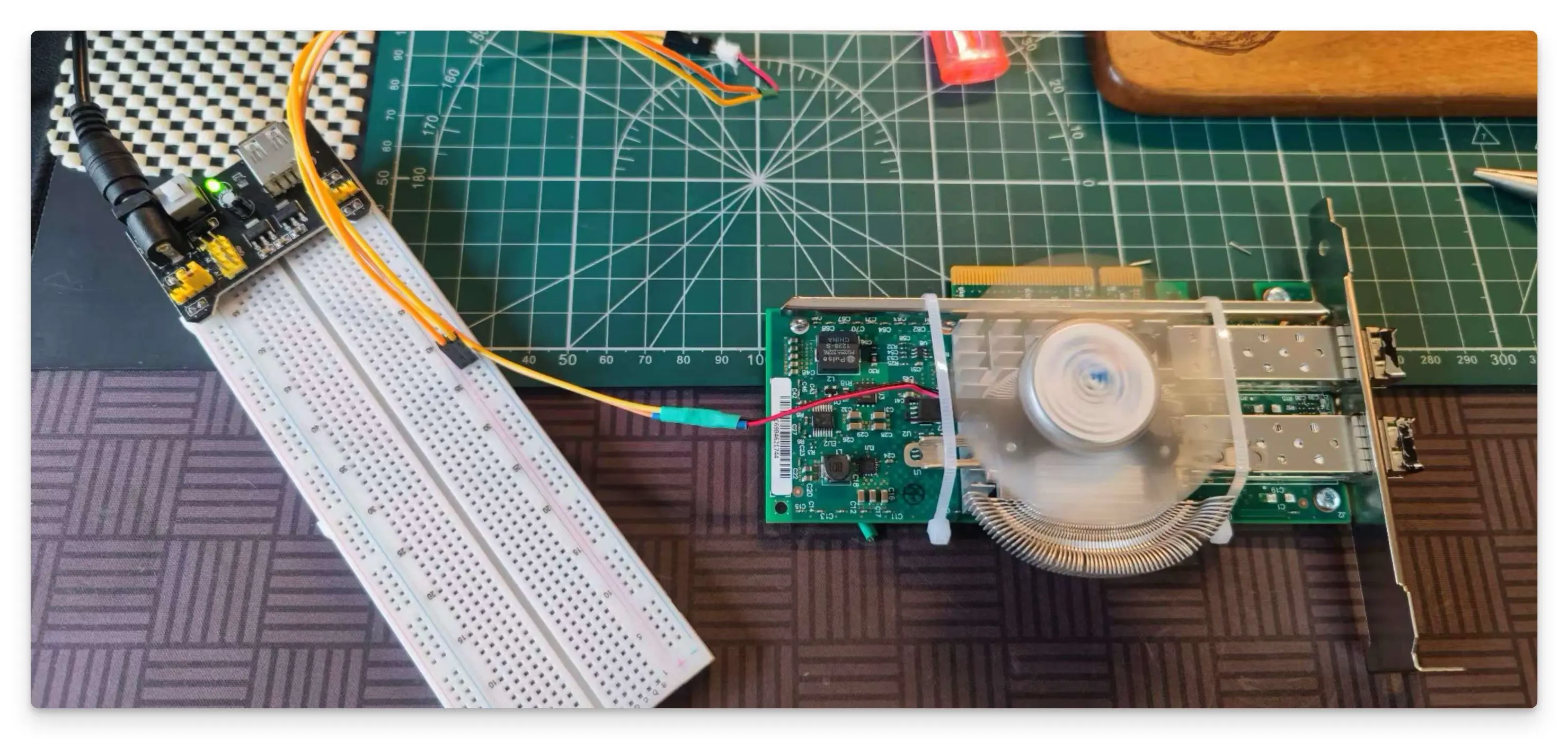

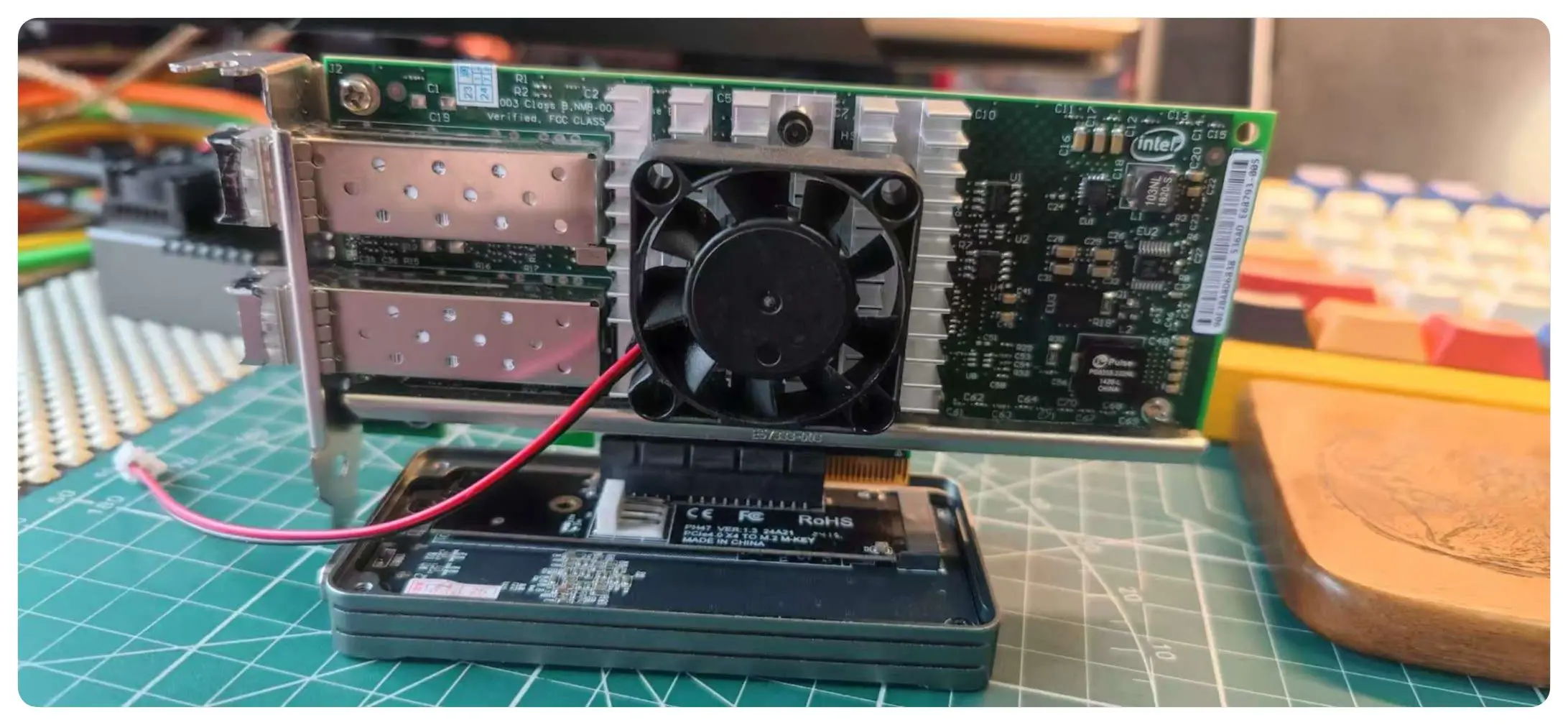

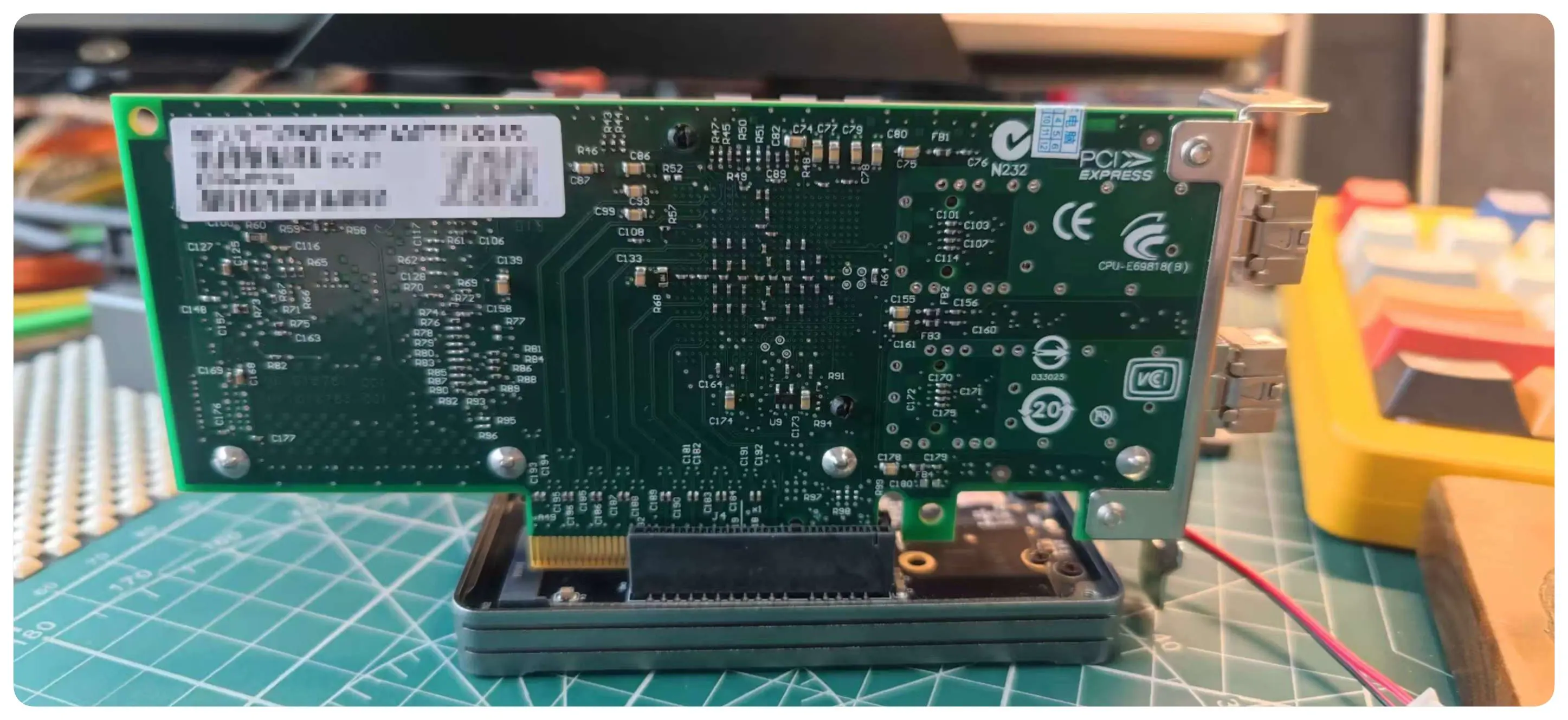

下面是使用 USB4.0 移动硬盘盒:

说实话, 铝质的移动硬盘盒加上网卡确实比第一种方案要好看那么一点.

部署交换机

使用扎带安装到桌底的导线槽下面, Micro USB Console 端口连接到 MBP 拓展坞上面.

这是部署完成后的样子, 光转电模块加装了散热鳍片, 下面的风扇稍微有点风就能带走热量(噪音完全可以忽略, 因为风扇支持可变电压, 现在给的电压保证能转就行, 夏天的话噪音应该会大一点).

光纤布线

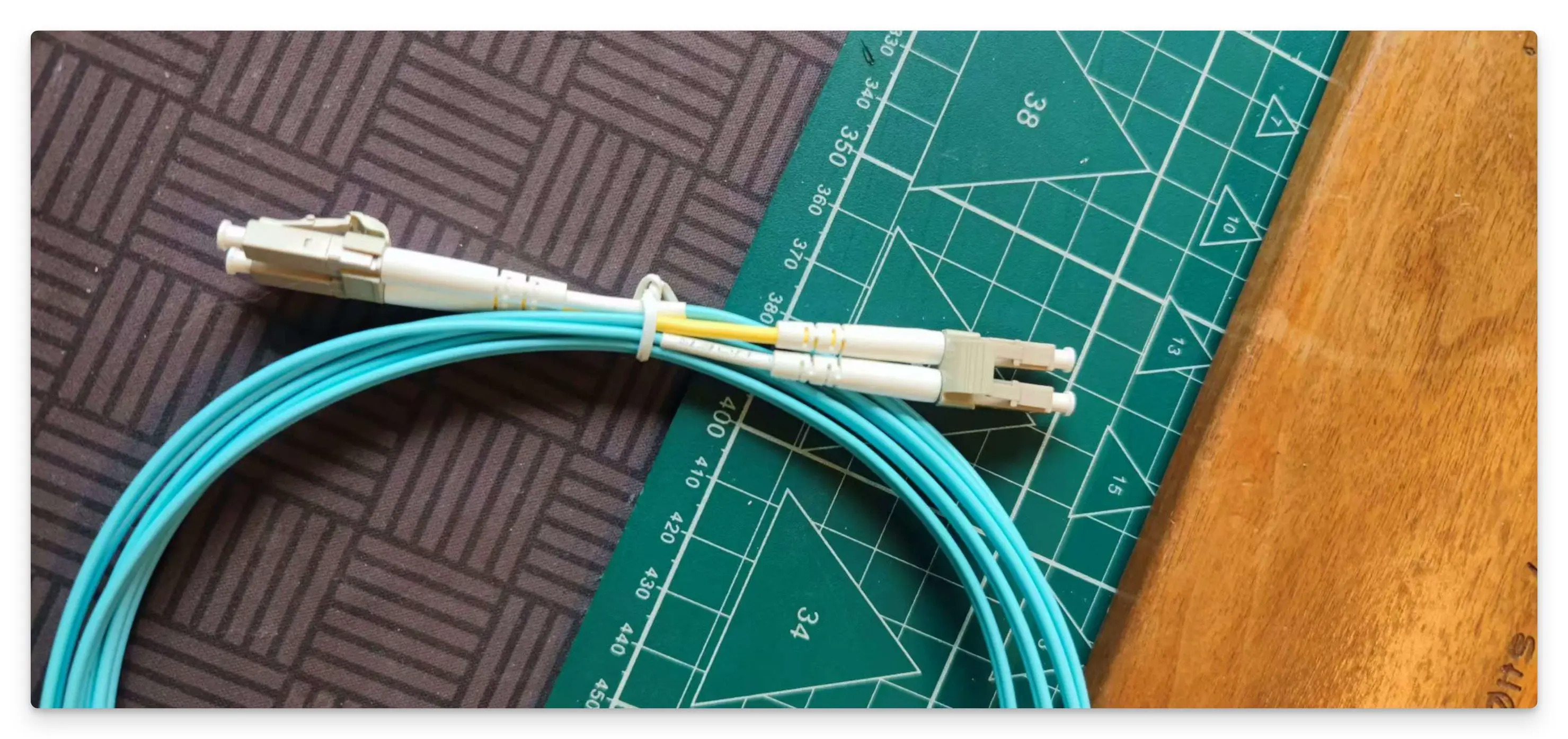

了解光纤和光模块的类型后, 直接买的多模双芯的 OM3 光纤, LC-LC 接口:

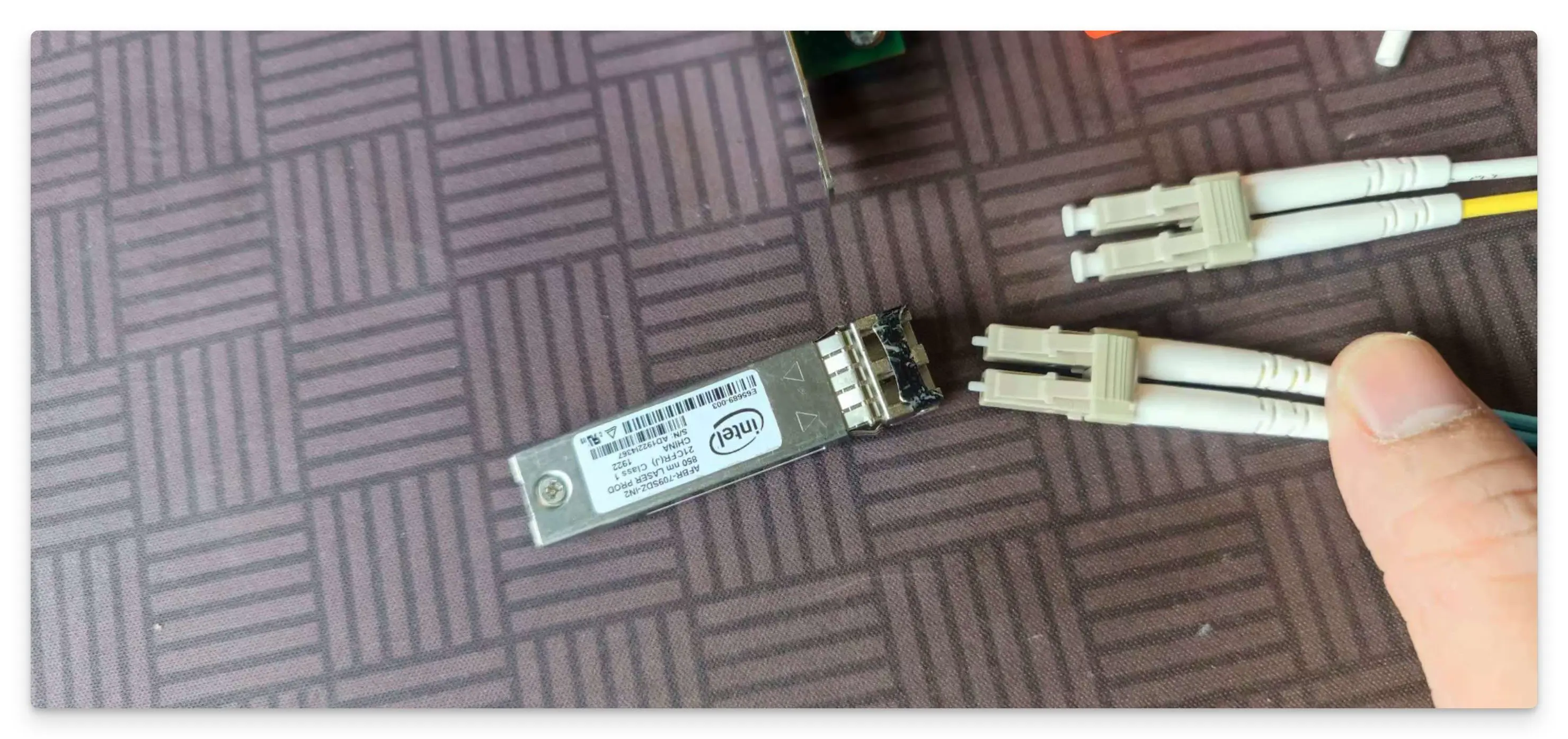

二手的 Intel 多模光模块, 价格便宜:

光纤与光模块连接, 还闹了个笑话, 不知道 LC 接口还有一个保护壳, 一直纳闷为啥插不稳. 无意中掰了下 LC 接口的头子, 发现居然是个保护壳 🥲.

软件

万兆交换机

网口连接

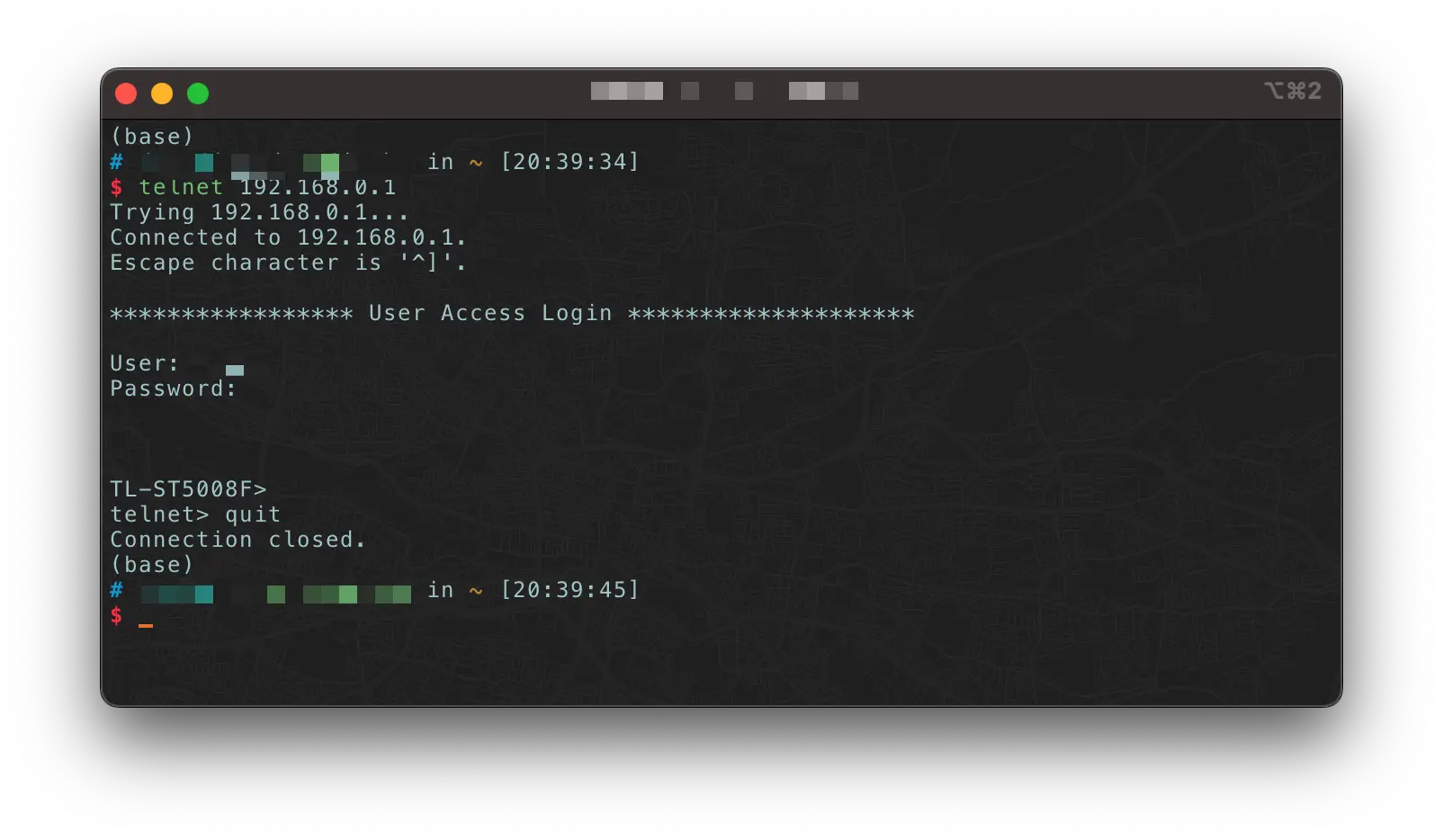

TL-ST5008F 的 业务端口默认 IP 为 192.168.0.1, 所以修改为同网段的 IP 即可访问 Web 管理端.

连接任意网口, 然后设置 IP 地址:

使用 http://192.168.0.1/ 访问 Web 管理端:

Management 端口连接

TL-ST5008F 还提供一个 Management 管理口, 默认 IP 地址: 10.20.30.40. 当电脑连接交换机管理口时, 需设置电脑 IP 地址为:10.20.30.x(x 为 1-254 间任意值, 不能为 40), 子网掩码设置为 255.255.255.0.

Console 端口连接

Console 端口用于和计算机或其他终端的串口相连以管理或配置交换机. TL-ST5008F 提供 1 个 Micro USB Console 端口和 1 个 RJ45 Console 端口, 两个端口 不能同时使用, 同时连接时只有 Micro USB Console 端口生效.

使用串口连接, 参数如下:

- 波特率: TL-ST5012/TL-ST5008 波特率为 38400bps;

- TL-ST5016F 波特率为 115200bps 数据位:

- 8 位 奇偶校验:无

- 停止位:1 位

- 数据流控制:无

不知道是不是没有直接连接到 MBP(中间通过拓展坞链接), ls /dev/cu.* 并没有交换机的设备文件, 后面再尝试直连.

tenlet 连接

结束远程会话:

1 | TL-ST5008F>exit |

退出 telnet:

1 | # 在 Telnet 会话中, 按下 Ctrl + ] 键, 这将带您回到 Telnet 的命令提示符. |

远程管理

也没有连接成功, 一直提示 设备未在线, 后面再处理.

MTU 设置

按理说这个是实时生效的, 结果却是需要重启一下交换机才能生效.

MBP

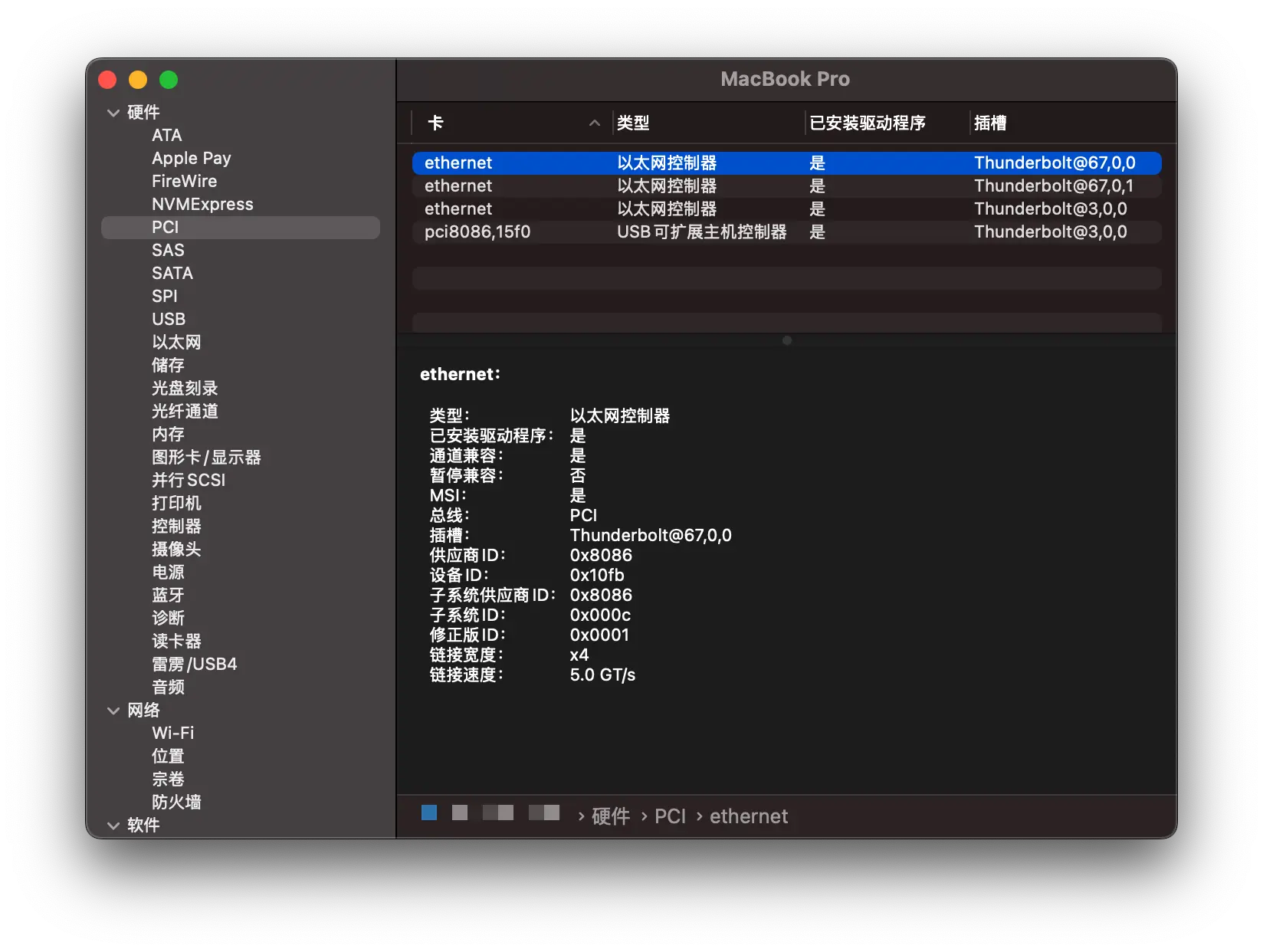

系统识别到 PCI 设备:

X520 的总线类型是 PCIe 2.0 X8, PCle 2.0 协议的每一条 Lane 支持 5 * 8 / 10 = 4 Gbps = 500 MB/s 的速率, x4 一共就是 16Gbps, 完全满足 10Gbps 的带宽.

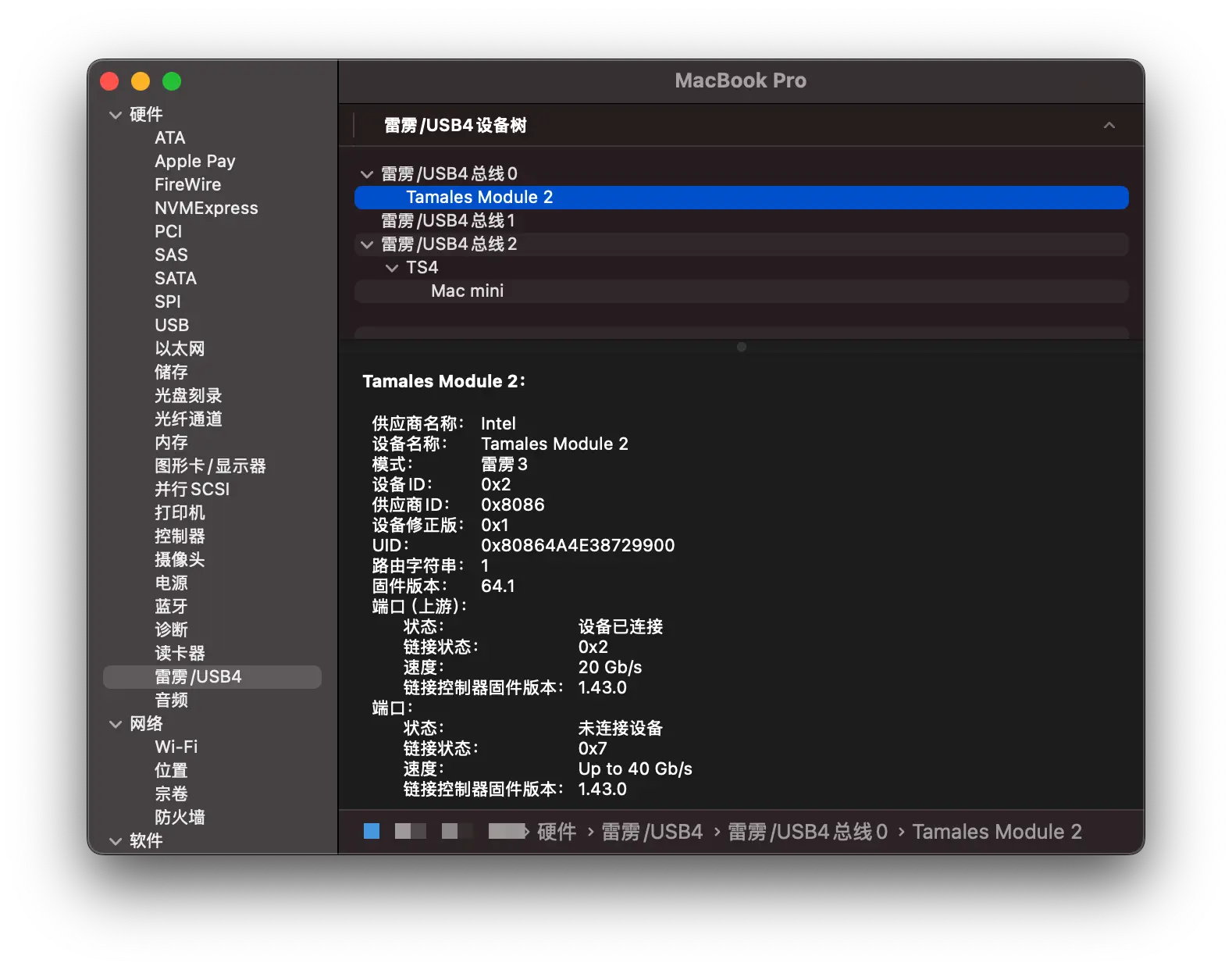

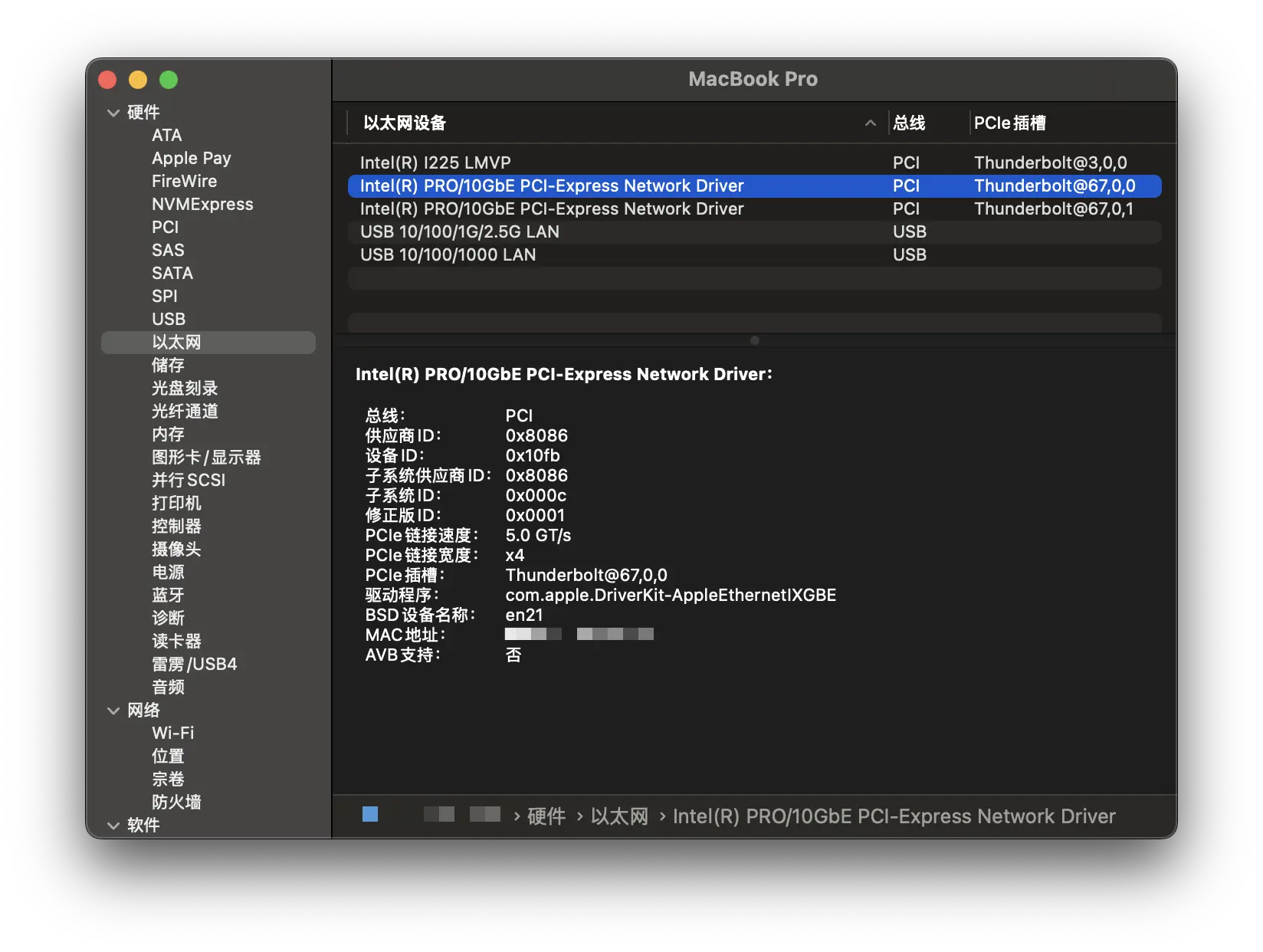

网卡的雷雳总线信息, 最高有 20Gb/s 的速度(按理说 JHL7540 最高应该有 24 Gb/s):

以太网设备信息:

I225 LMVP是 CalDigit T4 的 2.5G 网卡;- 然后是 X520-DA2 2 个光口网卡;

- 第四个是 USB 转 2.5G 网卡;

- 最后一个是另一个扩展坞上面的 1G 网卡;

最后是网络设置中的硬件信息:

网卡速度支持 1000base-SX(1 Gbps) 和 10Gbase-SR(10 Gbps), 不支持 2.5G, 而且 MTU 最高只能设置到 2034:

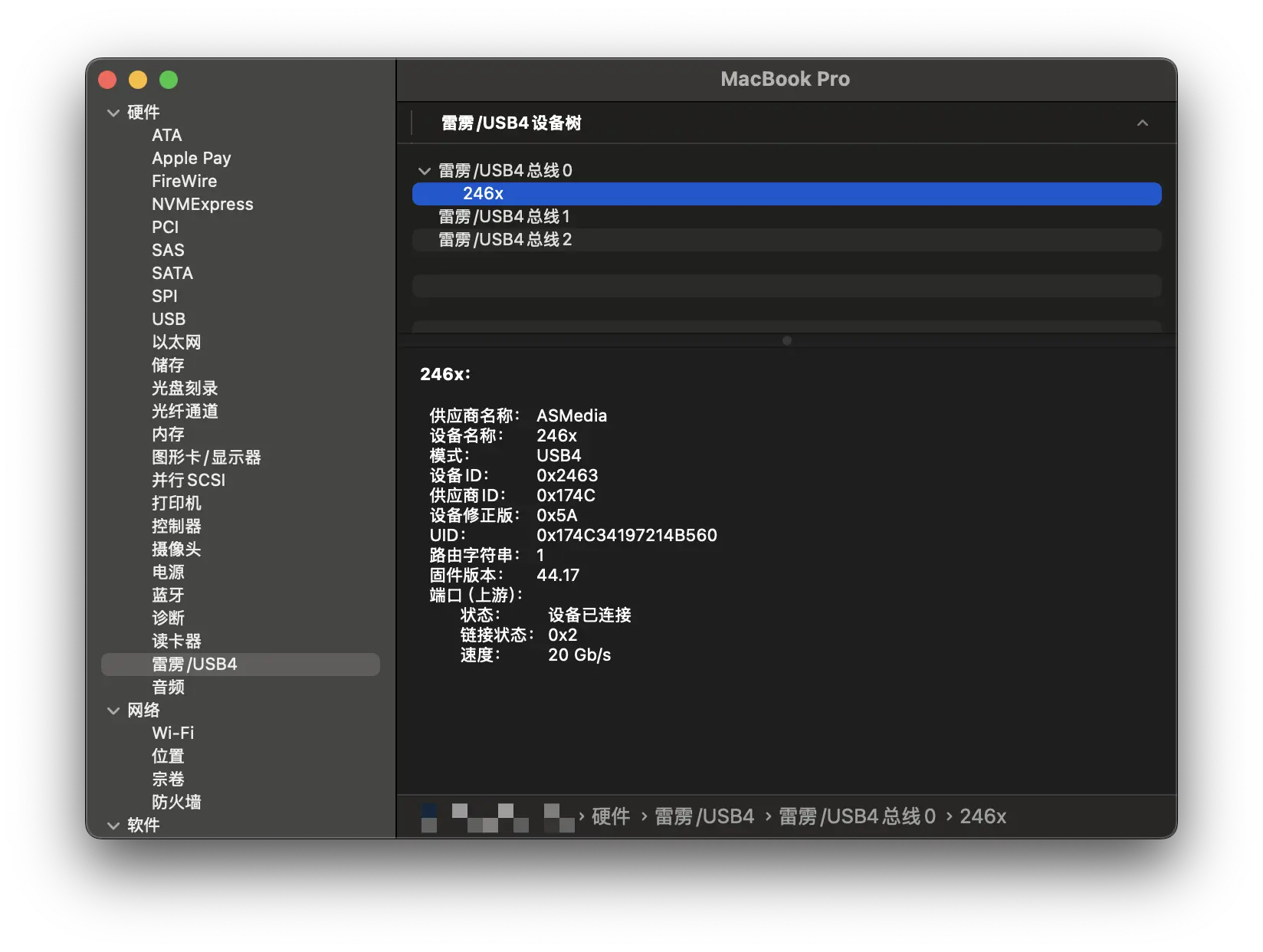

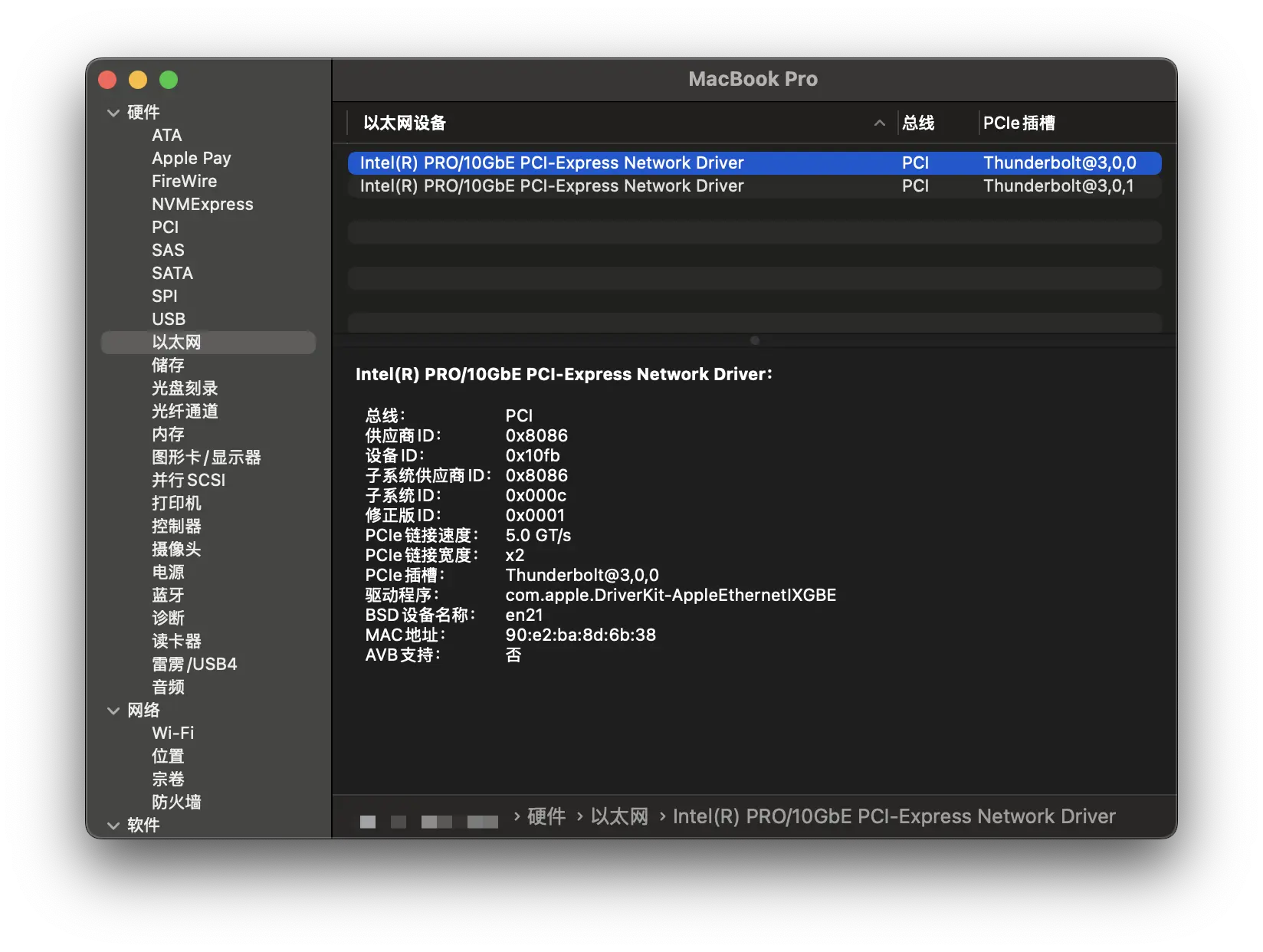

下面是使用 USB4.0 的硬盘盒的硬件信息:

在 MBP 识别出的速度是 20 Gb/s(安装的万兆网卡), 而在 Mac mini M2 上则是 40Gb/s(安装的 m.2 固态):

Intel X520-DA2 网卡成功识别:

Mac mini

Mac mini 2018 和 Mac mini M2 的网口都是万兆电口, 能够顺利开启 9000 巨帧, 且支持 100M/1000M/2.5G/5G/10G 速度:

Ubuntu

万兆设备全部接入到电信网络, 首先需要调整一下网卡的优先级.

M920x(192.168.31.77) 和 Station(192.168.31.66) 是 Ubuntu 系统, 直接在命令行下调整网卡优先级:

1 | # 首先查看一下路由表 |

设置 MTU 为 9000 后, 测试一下在不分包的情况下整个链路是否能处理 9000 字节的数据包:

1 | $ ping -M do -s 8972 -c 2 192.168.31.66 |

使用

-M do参数时, ping 会设置Don’t Fragment(DF) 标志, 要求整个数据包不能被分段. 如果数据包大于网络路径中的任何设备的 MTU, 传输就会失败并返回错误.

比如:

1 | $ ping -M do -s 8973 -c 2 192.168.31.77 |

macOS 上

ping没有-M do参数, 正确的方式应该是:ping -D -s 8972 192.168.31.66

超过了 9000 直接报错.

还可以使用 tracepath 来获取整个链路的 MTU:

1 | $ tracepath 192.168.31.77 |

DS923+

因为在使用 Synology Virtual Machine Manager , 安装了 Open vSwitch, 在 Web 端修改 MTU 9000 只是修改物理网卡, 对应的虚拟网卡还是 1500, 所以需要在命令行下去修改:

1 | # 显示 Open vSwitch 的接口: |

万兆网卡对应的虚拟网卡是 ovs_eth2, 物理网卡 eth2 MTU 已经修改到 9000, 只需要同步到虚拟网卡即可:

1 | ip link set ovs_eth2 mtu 9000 |

查看结果:

1 | ip addr show ovs_eth2 |

最后是测试全链路是否都是 9000:

1 | $ tracepath 192.168.31.2 |

效果测试

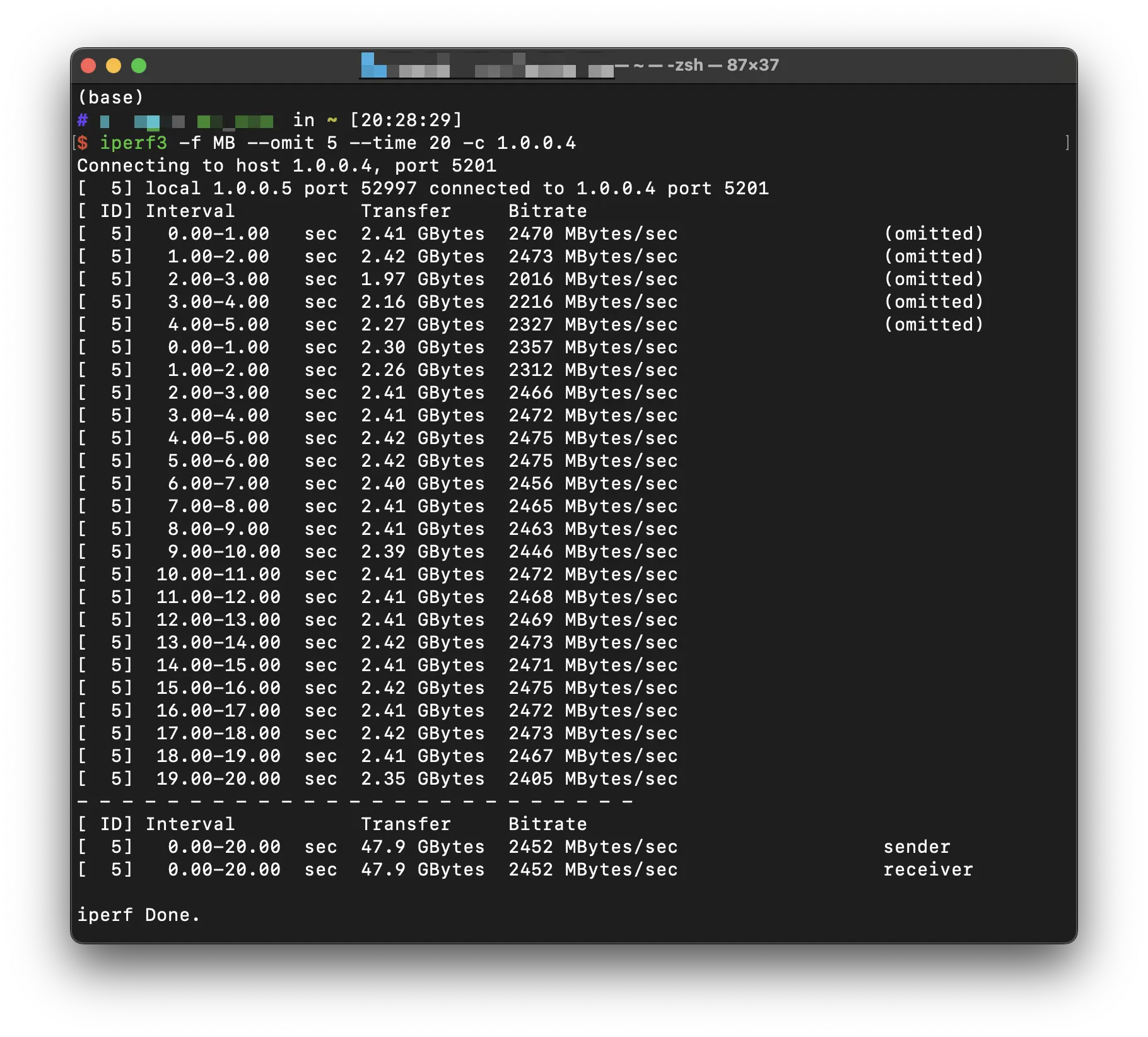

iperf3

非 MBP 设备

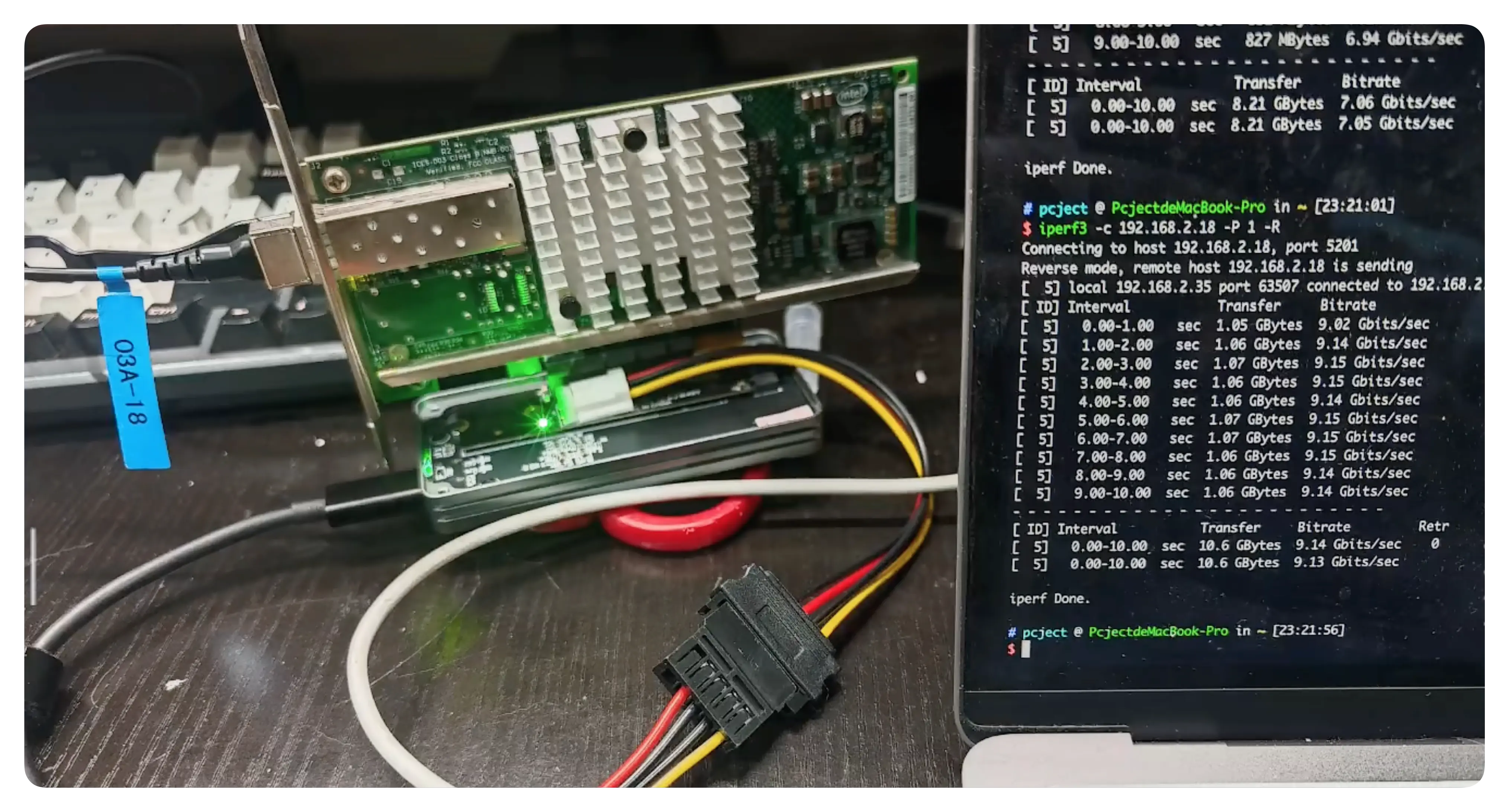

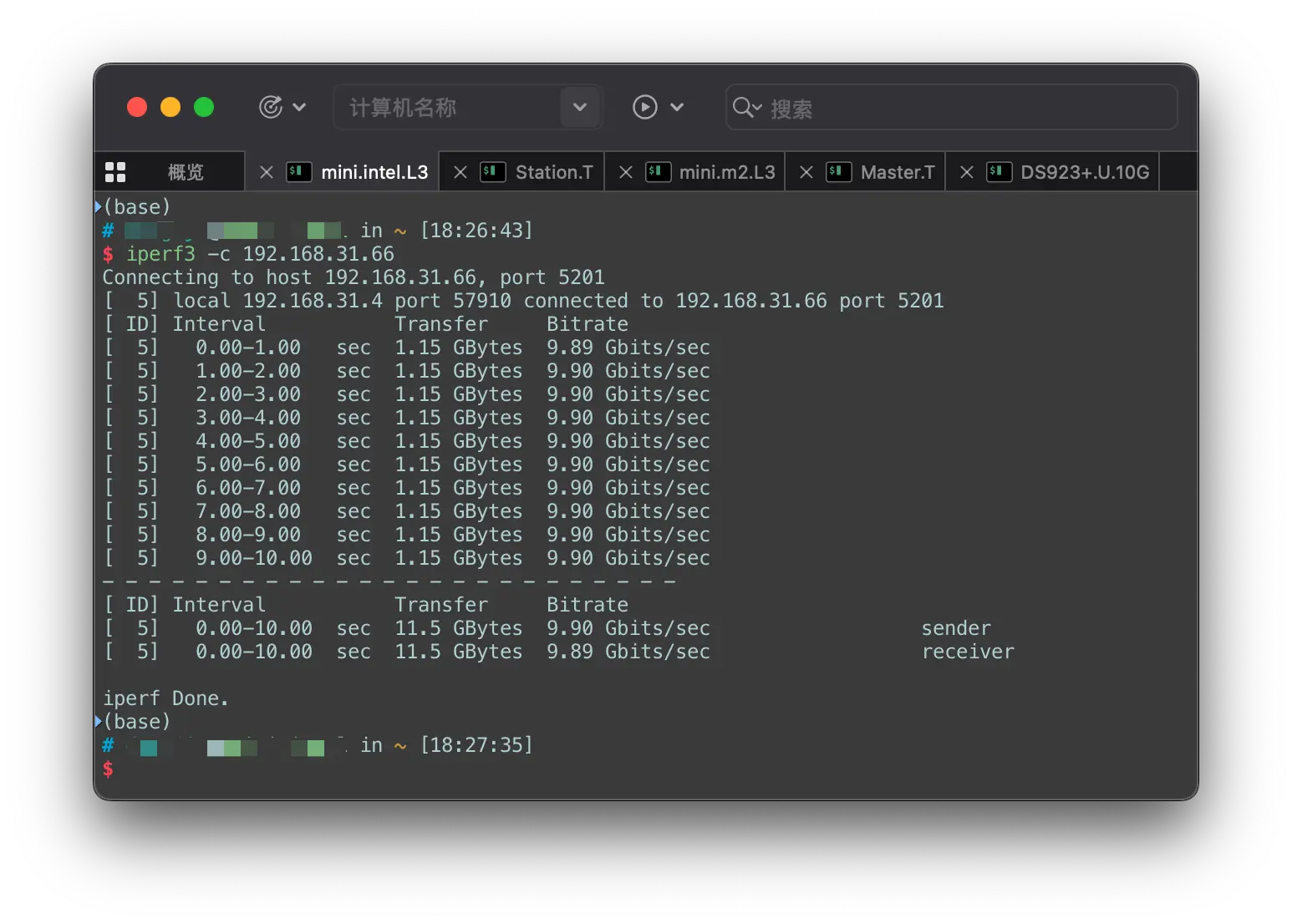

除了 MBP, 其他设备不管是上传还是下载, 使用 iperf3 都能跑完 10G 带宽:

MBP

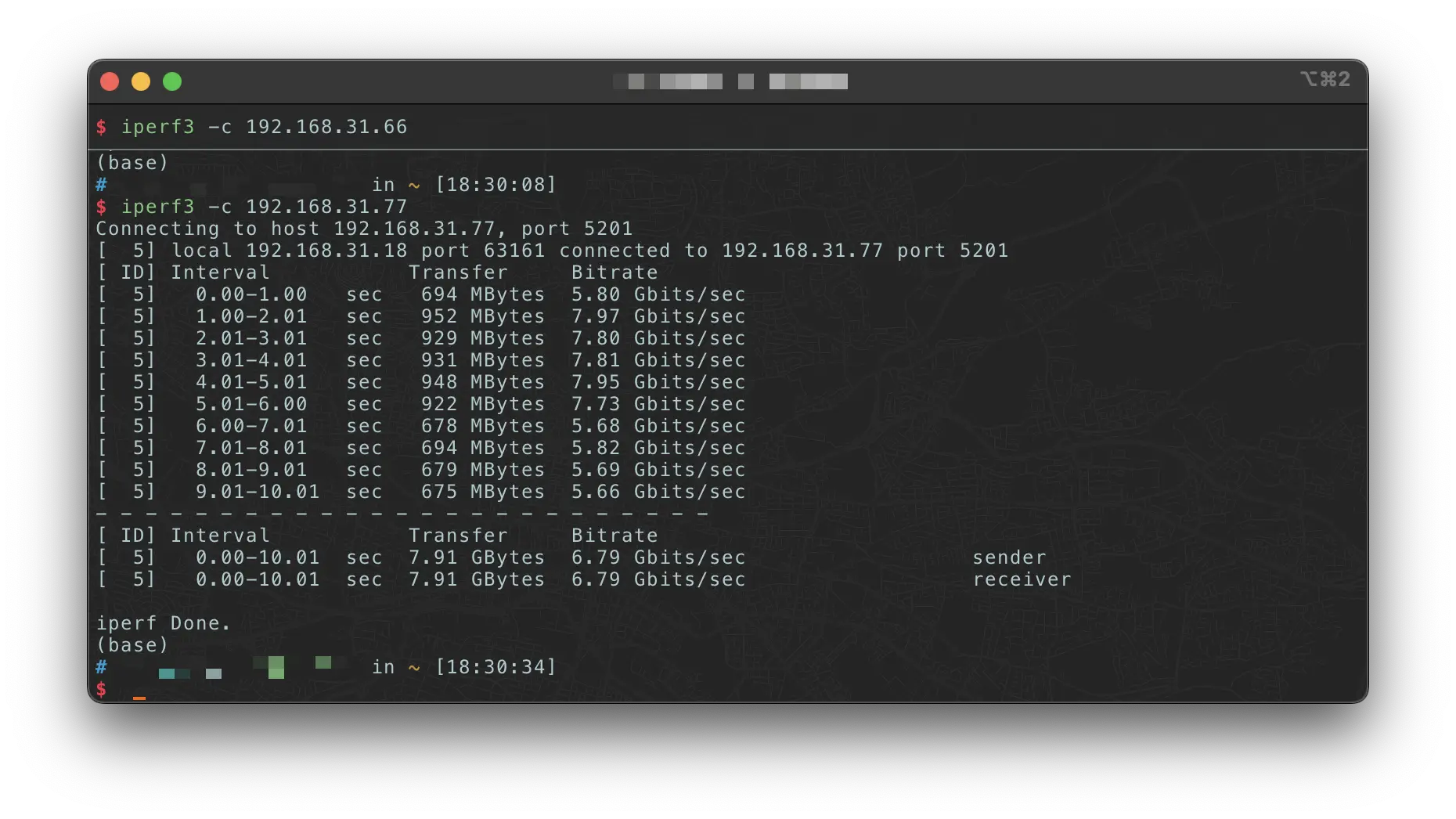

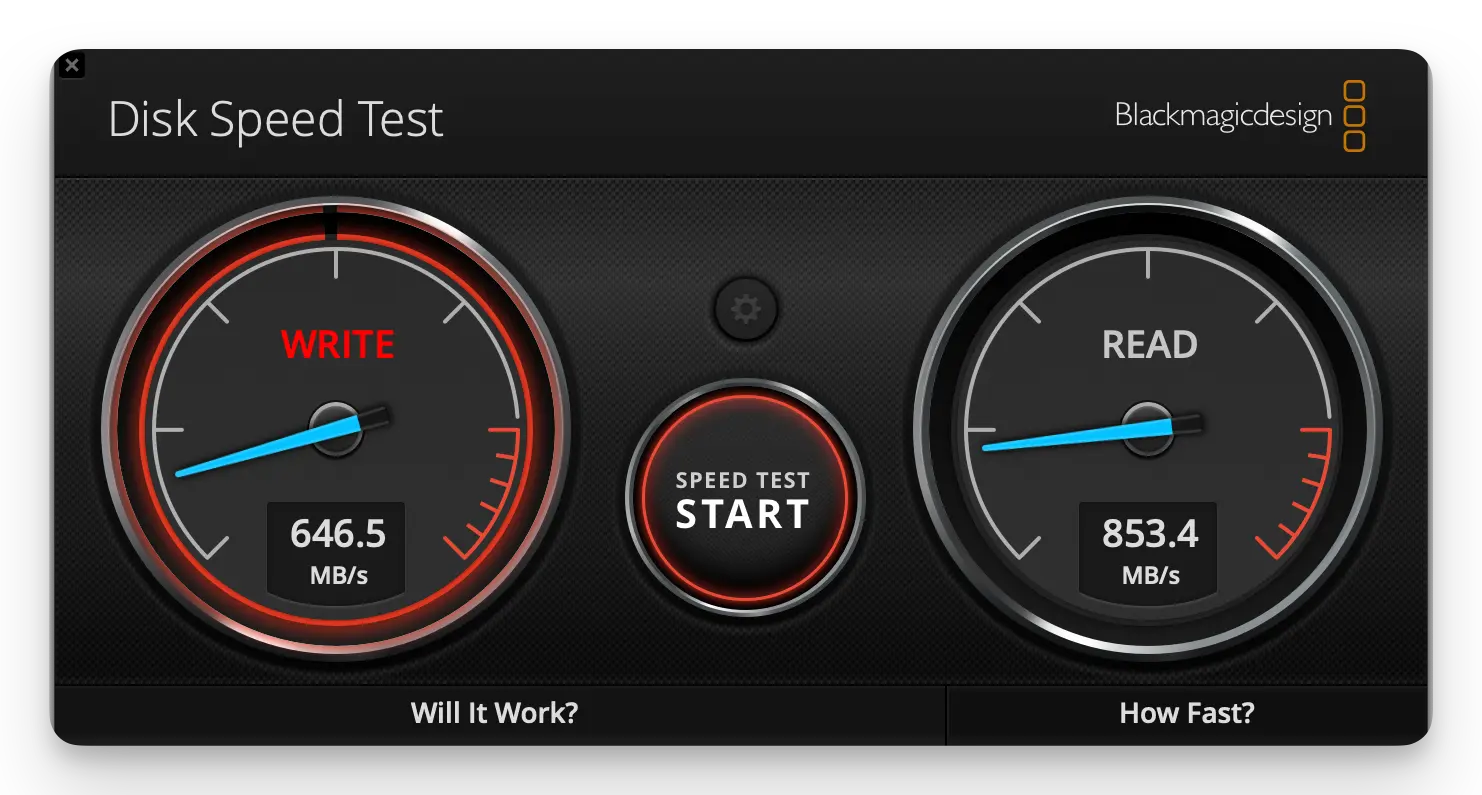

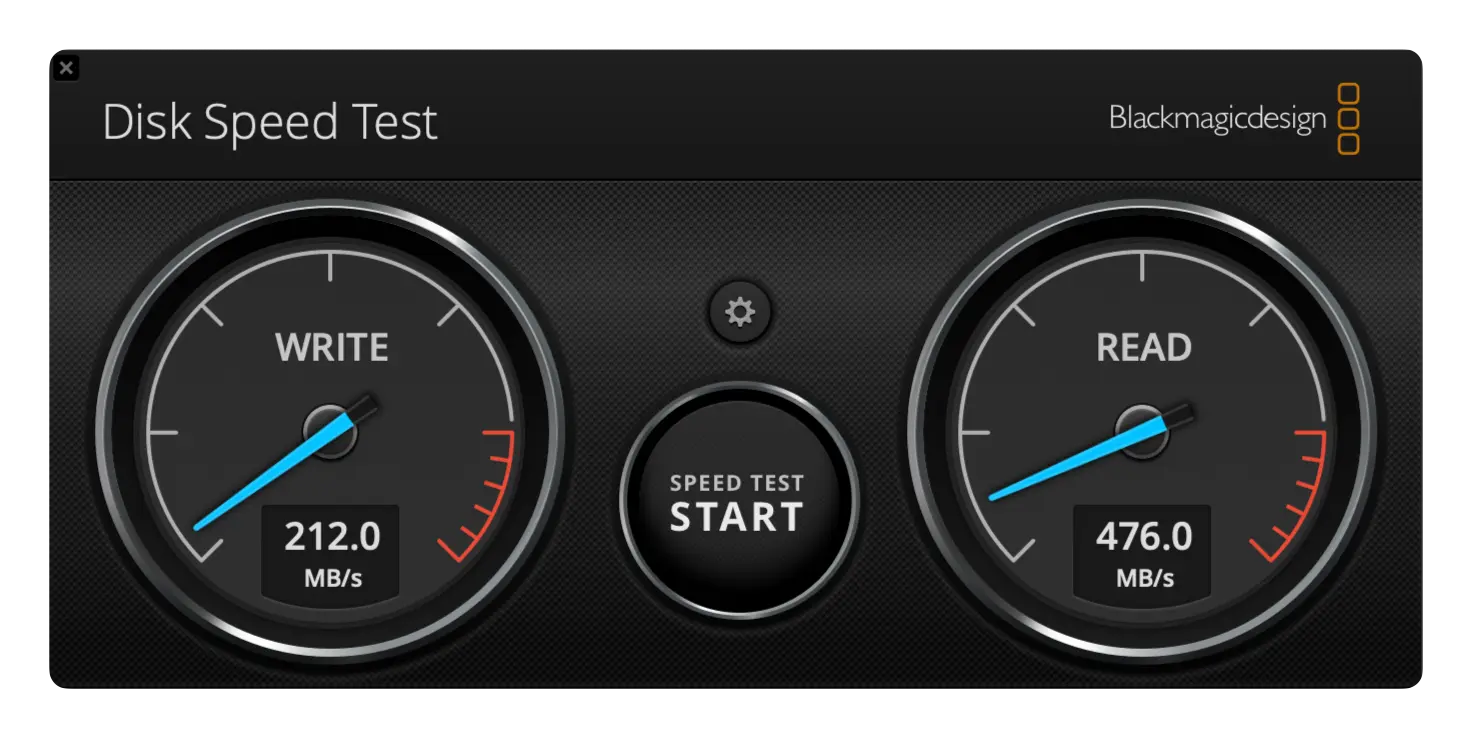

MBP 使用万兆首选方案, 因为 MTU 的原因, 上传能跑到接近 7G:

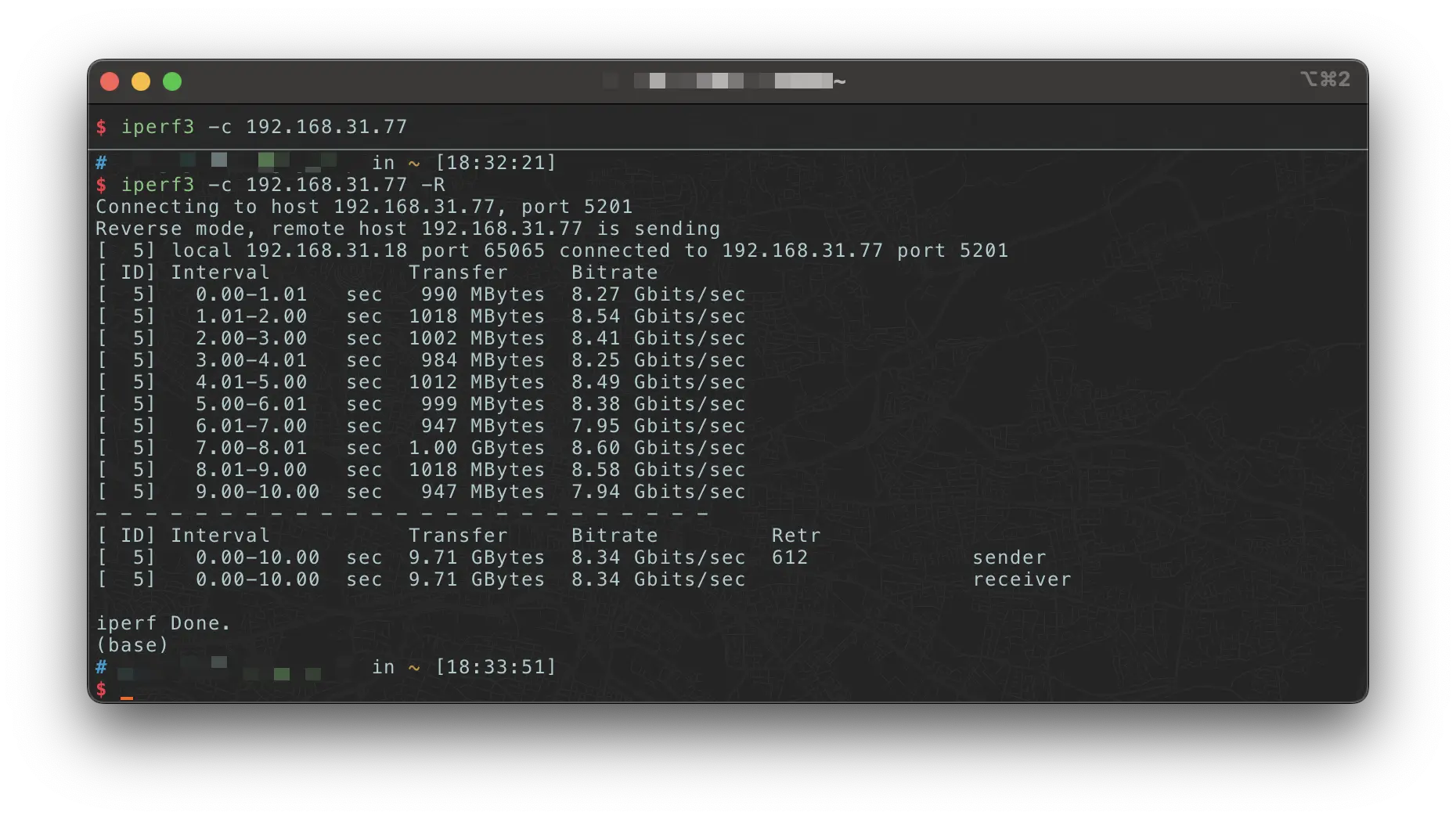

下载能跑到 8G+:

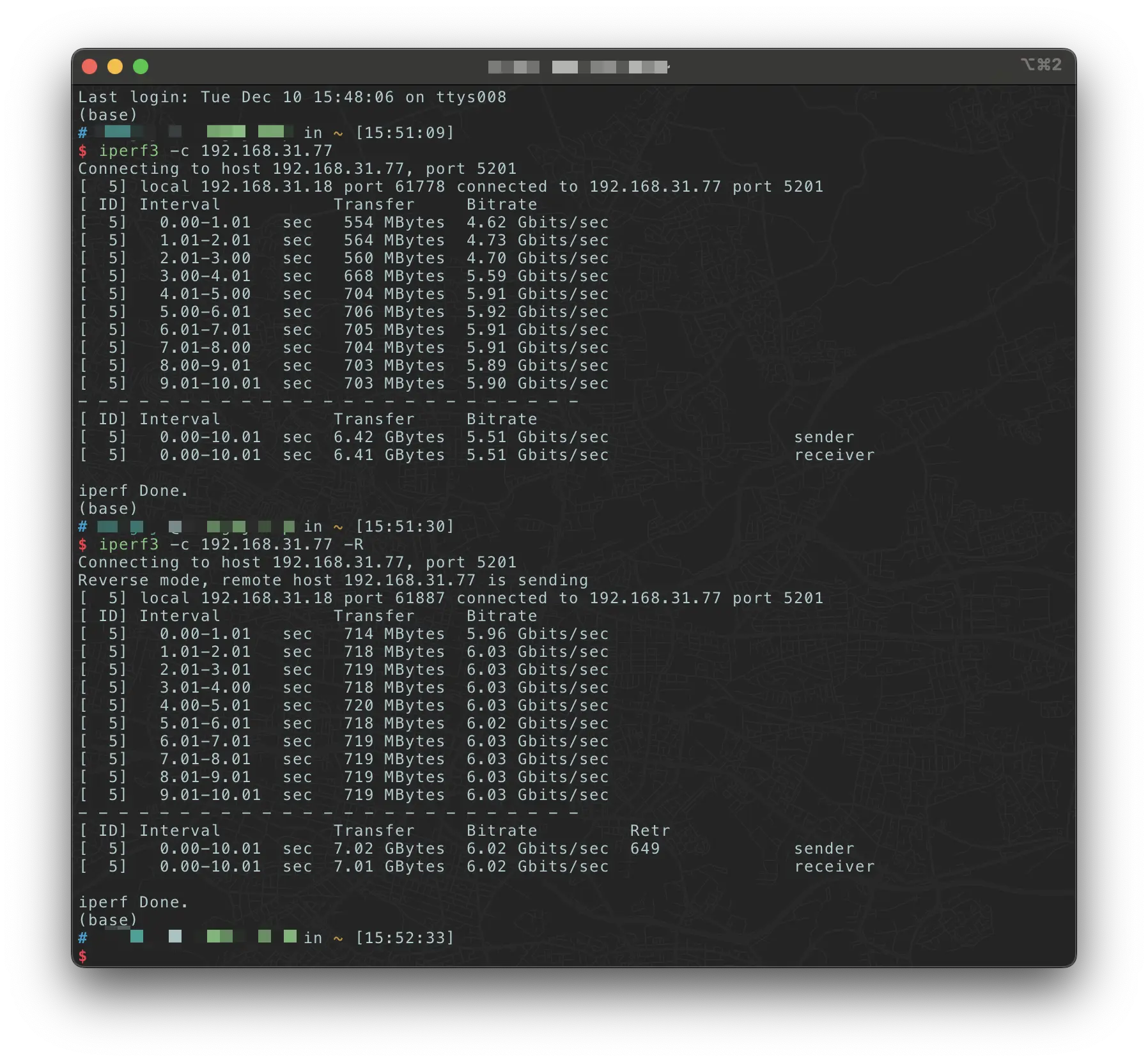

使用万兆备选方案, 上传能跑到 5.5G, 下载能跑到 6G:

所以还是选择了第一种方案, 这个硬盘盒就留给 Mac mini M2 使用了. 简单的测试了一下, 读取速度比 M2 自带的 256G 要高出 500MB/s 左右, 写入速度反而低了 500MB/s 😅, 可能跟我的固态有关, 这个问题就不去深究了, Mac mini M2 缺的是磁盘空间, 这次算是补足了.

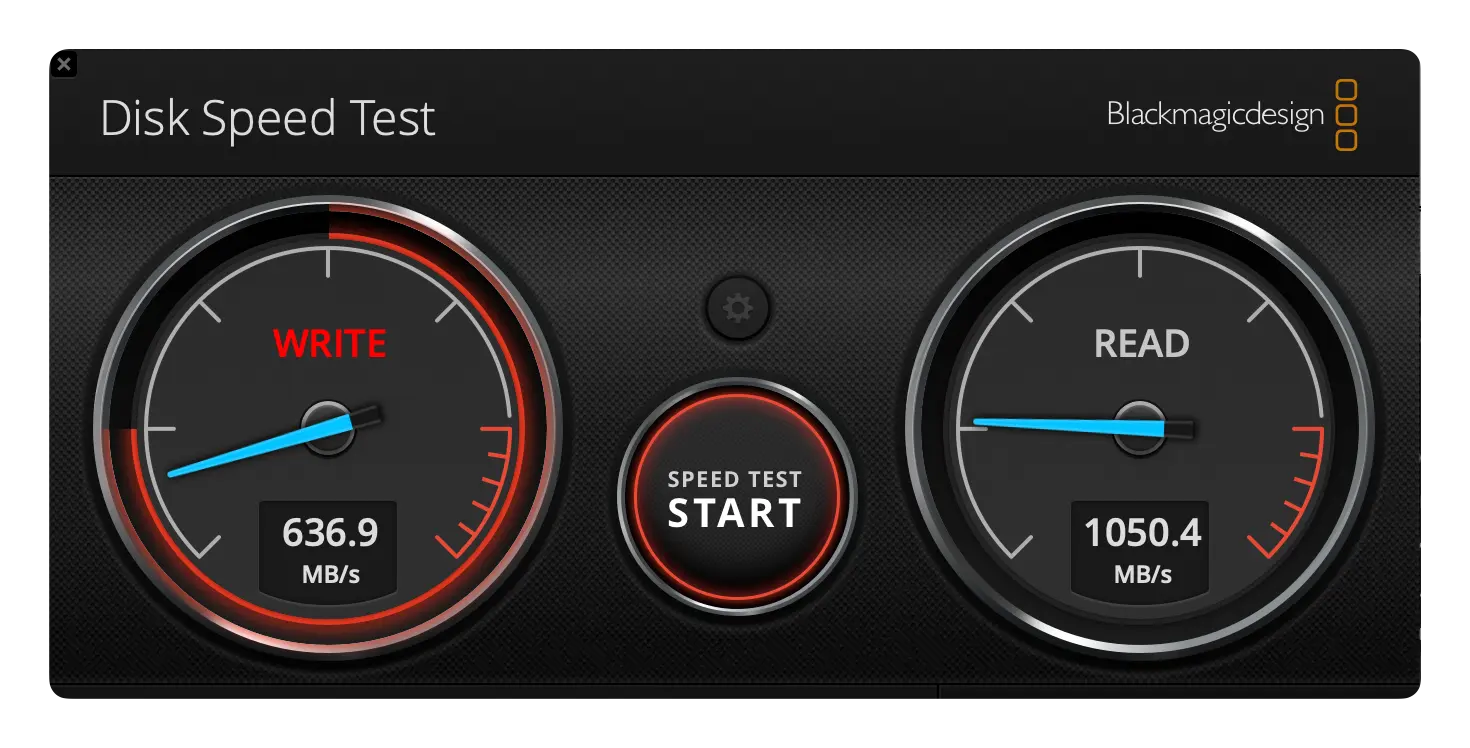

文件拷贝

测试使用 SMB 协议挂载 DS923+ 的机械硬盘到本地, 然后直接拷贝到本机.

Mac mini 2018

MBP

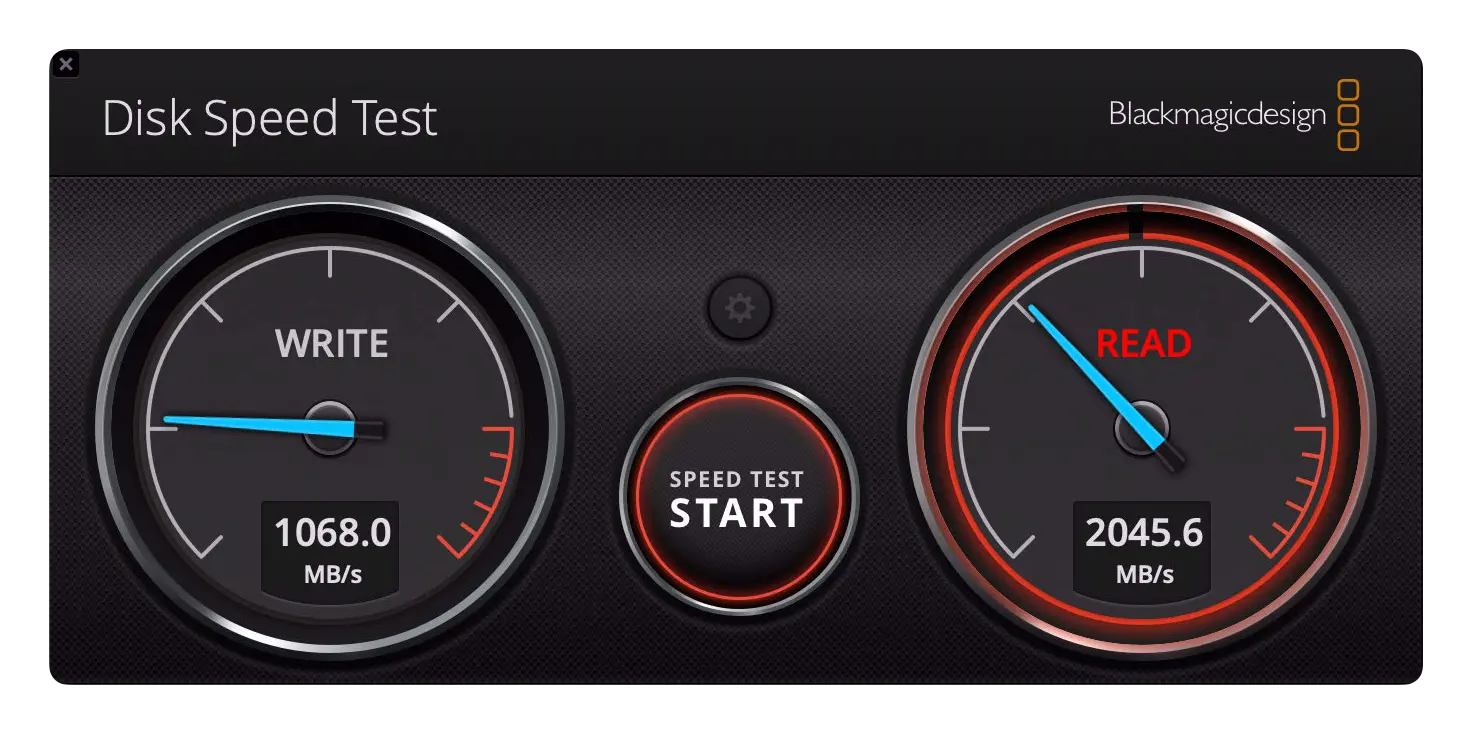

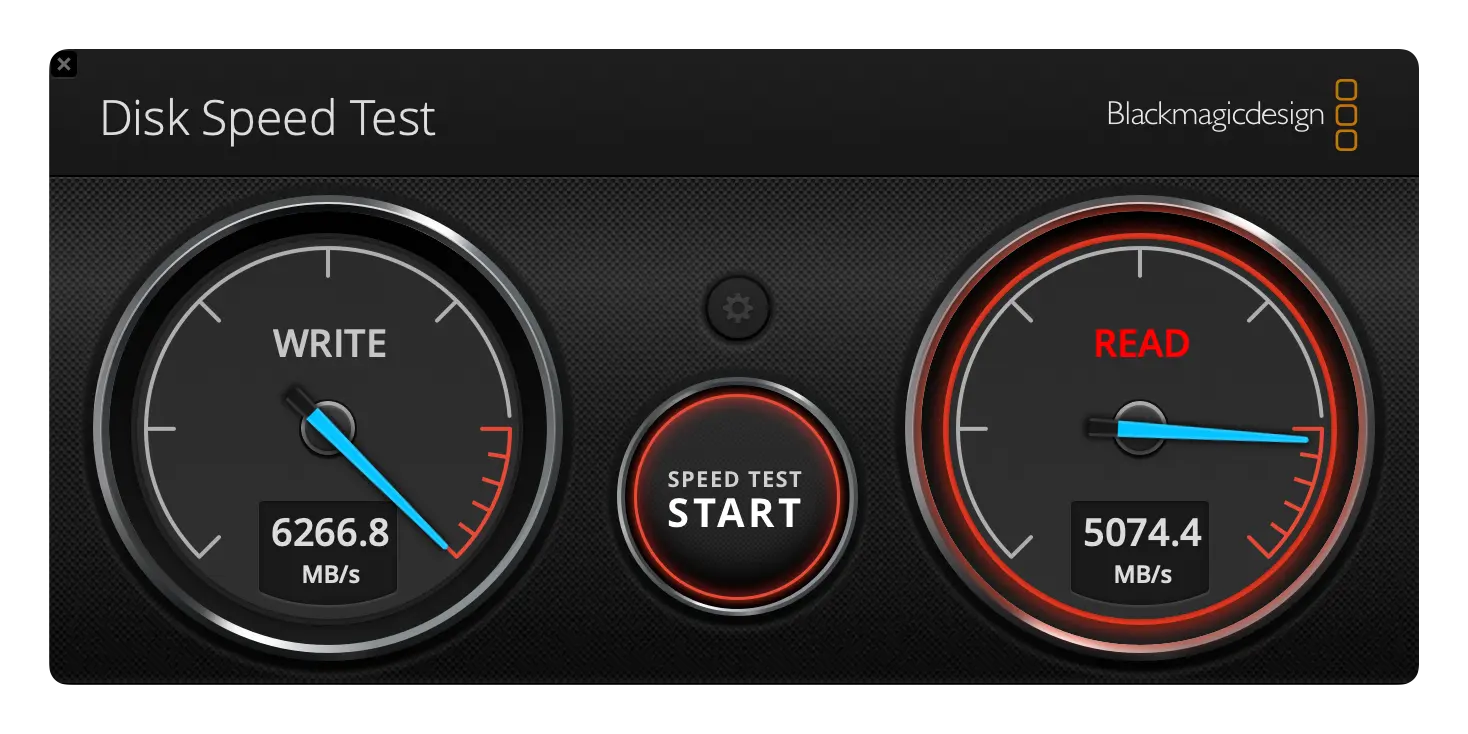

使用 Disk Speed Test 测试结果:

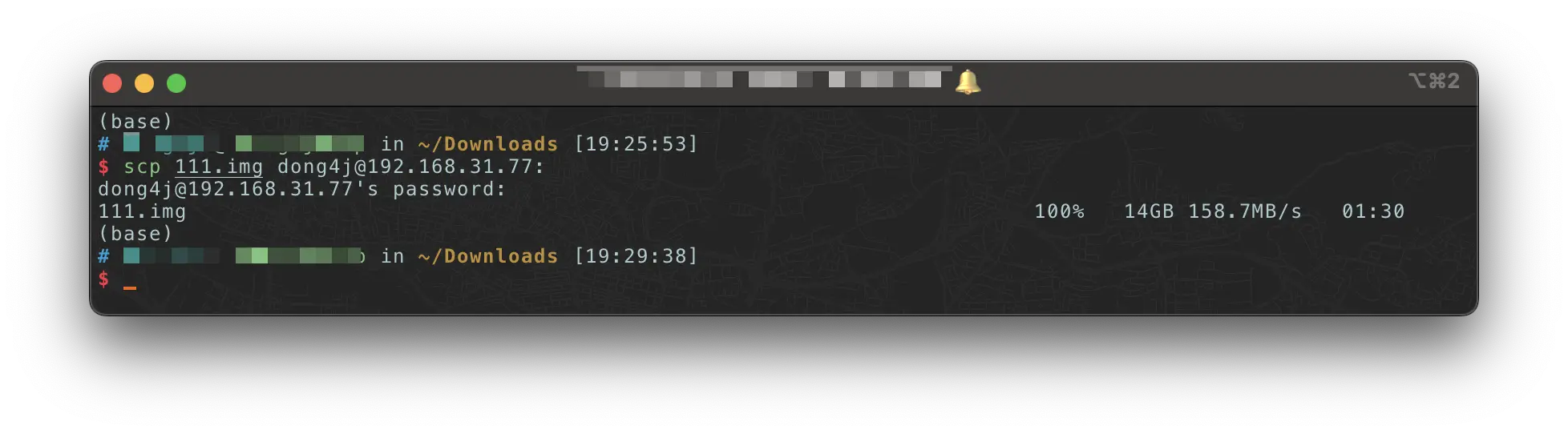

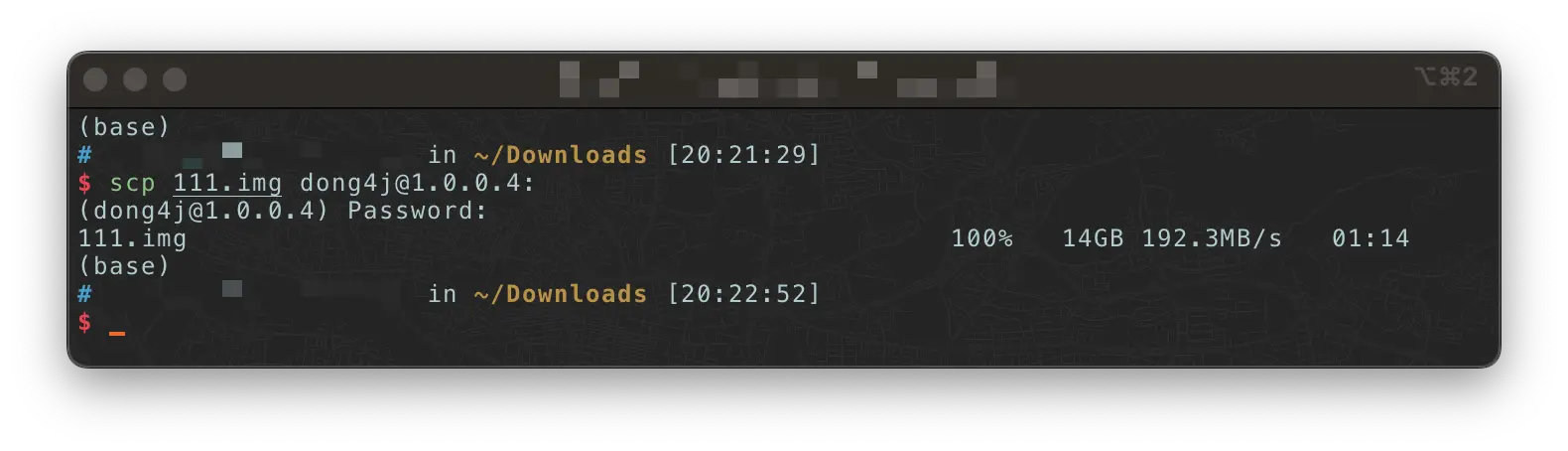

scp

在 MBP 下测试, 速度稳定在 150MB/s +

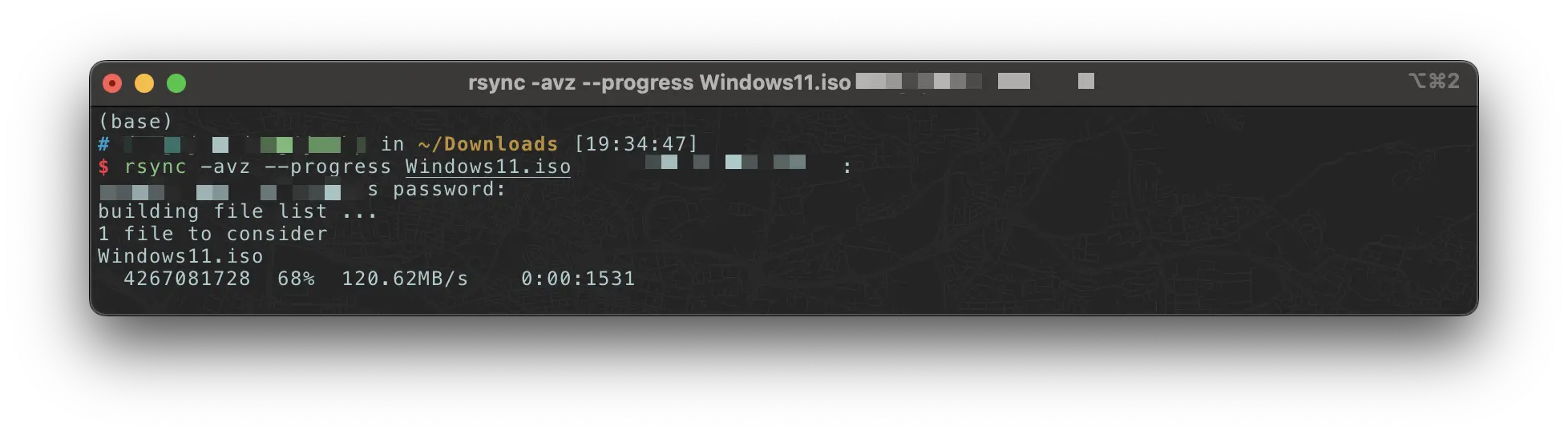

rsync

在 MBP 下测试, 稳定在 120MB/s +

遗留问题

MBP MTU

因为网卡驱动的问题, MTU 无法修改到 9000, 因为 Intel 官方并没有为其万兆网卡提供官方的驱动支持, 好在 Small Tree 这家公司为 8259x 芯片的网卡编写了 macOS 驱动, 该驱动同样可以适配到任何使用 8259x 芯片的网卡上, 包括我手头这张 X520.

但是根据 Small Tree 提供的驱动 , 它的文档明确说明了该驱动只会在 Subsystem ID 为 000A 的网卡上运行, 因此如果使用 Subsystem ID 不满足要求的话, 是无法驱动的.

所以需要通过一些办法强行修改为 000A, 然后再安装 Small Tree 的驱动即可.

还没有实际操作, 等有时间再尝试一下.

修改方式参考:

拓展坞带宽

因为给万兆网卡使用的雷雳拓展坞有 2 个雷雳接口, 原想让 MBP 通过一根雷雳 4 接口就可以把所有的设备全部带起来, 这些设备包括:

- 2 台 4K 显示器;

- 新增的万兆网卡;

- 若干 USB 设备;

但是因为雷雳 4 带宽受限, 导致部分 USB 设备无法正常使用, 只能再使用一个雷雳接口单独连接网卡的雷雳拓展坞了, 所以这次升级略带遗憾的是没有考虑到带宽的问题.

2023 年 9 月 12 日, 英特尔发布了雷雳 5 (Thunderbolt 5) 规范, 兼容最新的 USB4 V2 规格. 在对称模式下, 它提供 80Gbps 的上下行传输带宽, 是雷雳 4 的两倍;而在非对称模式下单向带宽最高可达 120Gbps, 是雷雳 4 的三倍.

而 Mac mini M4 提供 3 个雷雳 5 接口, 科技发展的真的太快了, 钱包已经跟不上了 😂.

多台 Mac 互联

雷雳技术

雷雳技术, 由英特尔开发, 是一种先进的连接标准, 它通过单一连接点提供电源、数据和视频信号. 雷雳技术的认证确保了电缆、电脑和配件满足强制性的最低要求, 以此保障不同设备和供应商之间的兼容性和互操作性. 对于终端用户来说, 基于雷雳技术的产品在连接各种配件时, 能够提供卓越的体验.

在 Apple Mac 系列产品中, 雷雳 3 和雷雳 4 端口实际上与 Intel 的雷雳 3 和雷雳 4 技术是相同的. Apple 常常为其软硬件产品赋予新的名称, 例如当 Mac 从 Intel 芯片转向 Apple 芯片时, 雷雳 3 的名称变更为“雷雳/USB4”, 尽管技术上仍然是雷雳 3. 而雷雳 4 (USB-C) 端口则是 Mac 上真正的雷雳 4 端口.

USB4 和雷雳 4 的主要差异在于, 尽管它们的最高带宽标准相同, 但雷雳 4 的最低性能标准要高于 USB4. 例如, USB4 的带宽可以低至 20Gbps, 充电功率可以低于 100W, 且连接显示器时不必满足雷雳 4 的标准.

雷雳 4 技术提供以下特性:

- 高带宽:40 Gbps 的带宽可用于数据和视频传输, 能够动态分配, 适合处理繁重的工作负载和快速文件传输.

- 快充:支持高达 100W 的电源输出, 用于为笔记本电脑充电, 以及高达 15W 的电源输出, 用于为配件供电.

- 丰富的显示选项:单个连接可以支持两台 4K 60 Hz 的显示器或一台 8K 60 Hz 的显示器.

USB-C 是一种连接器类型, 它不同于之前广泛使用的 USB-A 连接器和 Apple 的 Lightning 连接器. 雷雳 3、雷雳 4、USB4、USB3.2、USB2.0 等多种协议都可以使用 USB-C 连接器. 通常情况下, 雷雳 3 和雷雳 4 仅提供 USB-C 接口, 而 USB4 和 USB3.2 则可能同时提供 USB-C 和 USB-A 接口及线缆, 或者提供 USB-C 接口搭配 USB-A 转接头. 要区分 USB-C 的接口或线缆, 需要查看产品的印刷标志或详细参数说明.

以 Apple 的 Lightning 接口为例, 最新的 iPhone 15 系列随机附送的 USB-C 接口线缆实际上遵循的是 USB 2.0 标准, 其传输速率仅为 480Mbps. 若要提升速度, 用户需额外购买 USB 3.2 线缆或雷雳 3、雷雳 4 线缆. 值得注意的是, 只有 iPhone 15 Pro 和 iPhone 15 Pro Max 支持 USB 3.2 第 2 代, 能够实现最高 10Gbit/s 的快速数据传输.

关于 USB 版本协议的命名, 确实有些复杂. 但只需记住, USB3.2 的 10Gbit/s 是 USB3 系列的高标准速度 (而 USB3.2 Gen2x2 的 20Gbit/s 由于兼容性问题, 通常不作为主流标准) . 这一速度常用于市面上常见的 SSD 固态移动硬盘传输. USB4 有 20Gbit/s 和 40 Gbit/s 两个版本, 而雷雳 3 和雷雳 4 均提供 40Gbit/s 的带宽. 一根雷雳 3 线缆通常能够满足大多数单一设备的连接需求.

雷雳 3 和雷雳 4 均标榜一个接口多种用途, 因此, 当一根线缆通过扩展坞连接多个设备时, 其带宽是动态分配的. 雷雳 4 相较于雷雳 3, 在数据传输带宽上提供了更高的分配, 并且在连接显示器的标准上也更为严格. 因此, 如果你追求最高的数据传输速度或者需要连接多个高标准设备, 那么选择雷雳 4 线缆将是更佳的选择. 当然, 除了线缆本身, 设备间的传输接口和设备本身的性能也会对整体传输效果产生影响.

如果你想尝试一下 雷雳 5 80Gbps 的极限速度, 最新的 Mac mini M4 或许是最好的选择.

雷雳组网

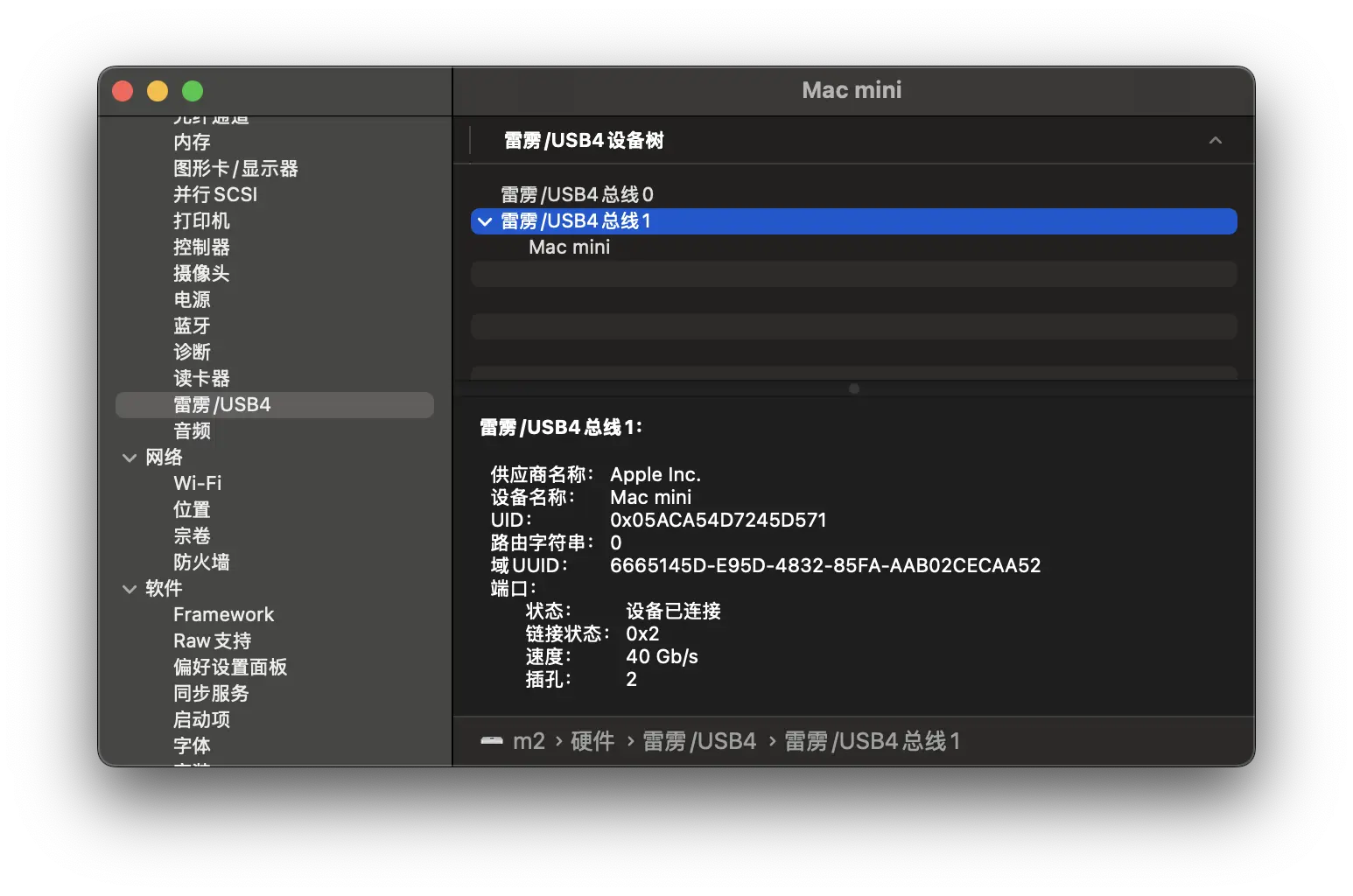

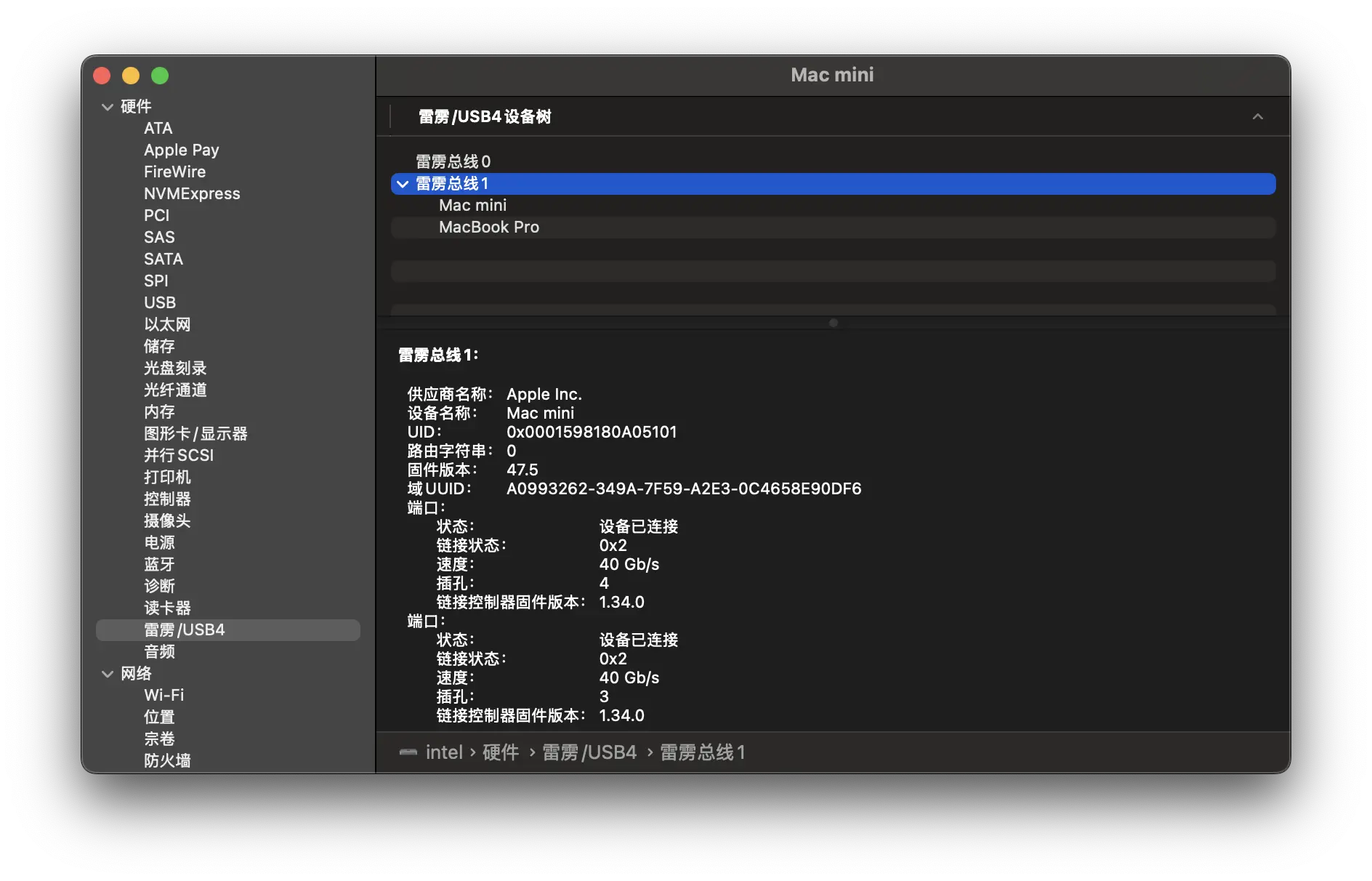

目前有 3 台 macOS 设备, 且都有空余的雷雳接口, 所以想着组个 20G 网络玩玩.

除了 Mac mini 2018 是雷雳 3 接口外, 其他 2 台全是雷雳 4 接口. 雷雳 3 理论也只有 22Gb/s 的带宽用于数据传输, 使用雷雳 4 端口+雷雳 4 数据线可以到达 32Gb/s 的理论传输速度.

下面是连接拓扑图:

最开始是将 M2 作为 MBP 和 Mac mini 2018 的中继节点来连接的, 这样至少能保证 MBP 到 M2 能达到雷雳 4 的速度, 但是实践后发现 M2 和 MBP 的雷雳连接经常断开, 连接方式是 MBP 通过雷雳 4 连接 CalDigit TS4 后再连接到 M2, 可能因为 CalDigit TS4 (2 台 4K 显示器, 其他接口基本上插满了) 挂的设备太多不稳定导致的.

所有才使用了上述连接方案, 且 Mac mini 2018 正好有 2 个空闲的雷雳接口, M2 还能空出一个雷雳 4 接口以便后续连接存储设备.

这样连接后, 只有雷雳 3 的 22Gb/s 理论速度了, 不过稳定最重要, 速度至少比 10G 网线快.

下面是具体的连接方式.

雷雳网桥

需要了解的一个前提是, 雷雳 4 宣称的 40Gbit/s 带宽是基于比特 (bit) 这一单位的. 然而, 在软件和系统显示的速度单位通常是字节 (Byte) , 其中 1 字节等于 8 比特. 因此, 当移动硬盘标榜其传输速度为 1000MB/s 时, 这实际上相当于 8000Mbit/s, 或者大约等同于 7.8Gbit/s.

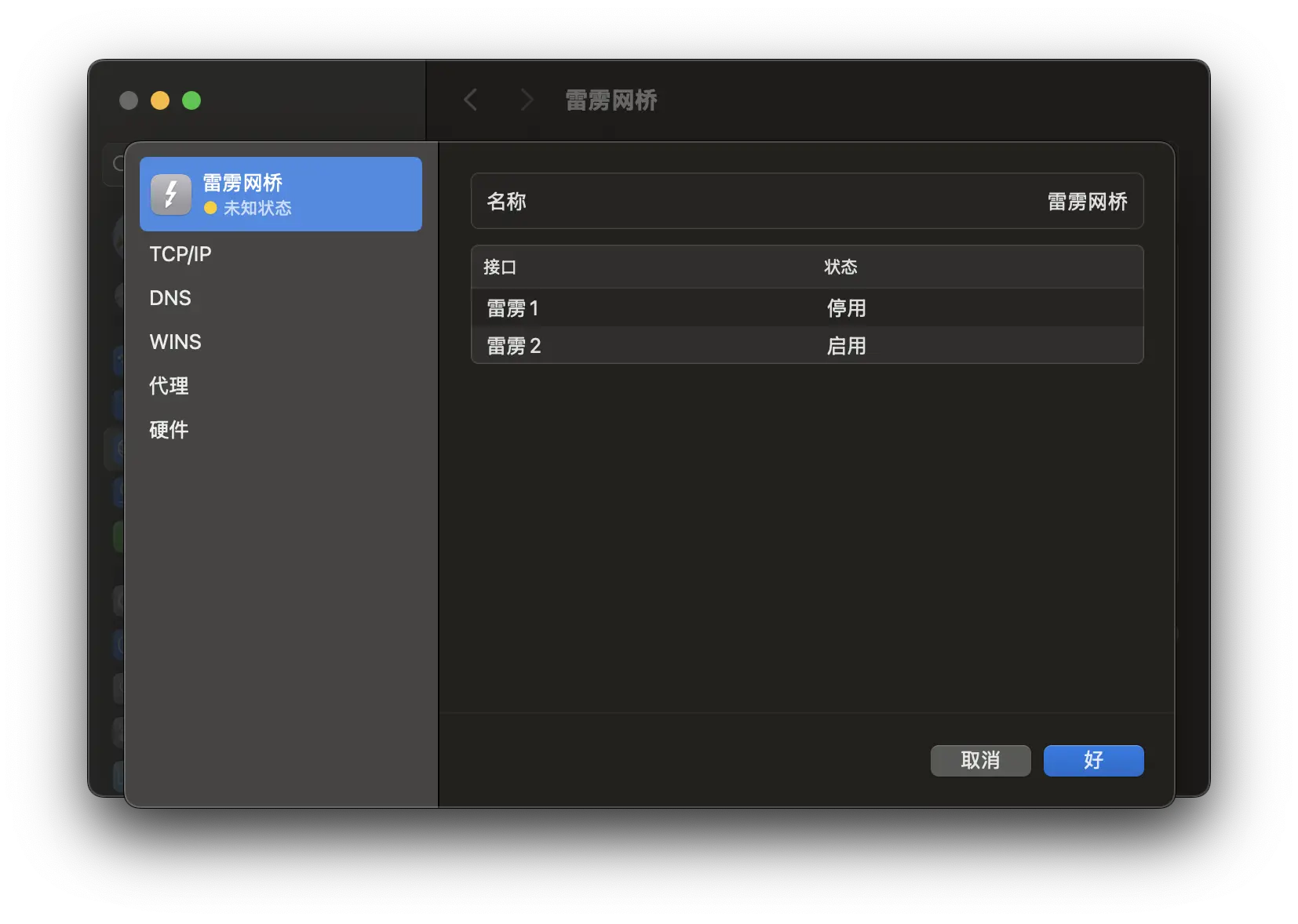

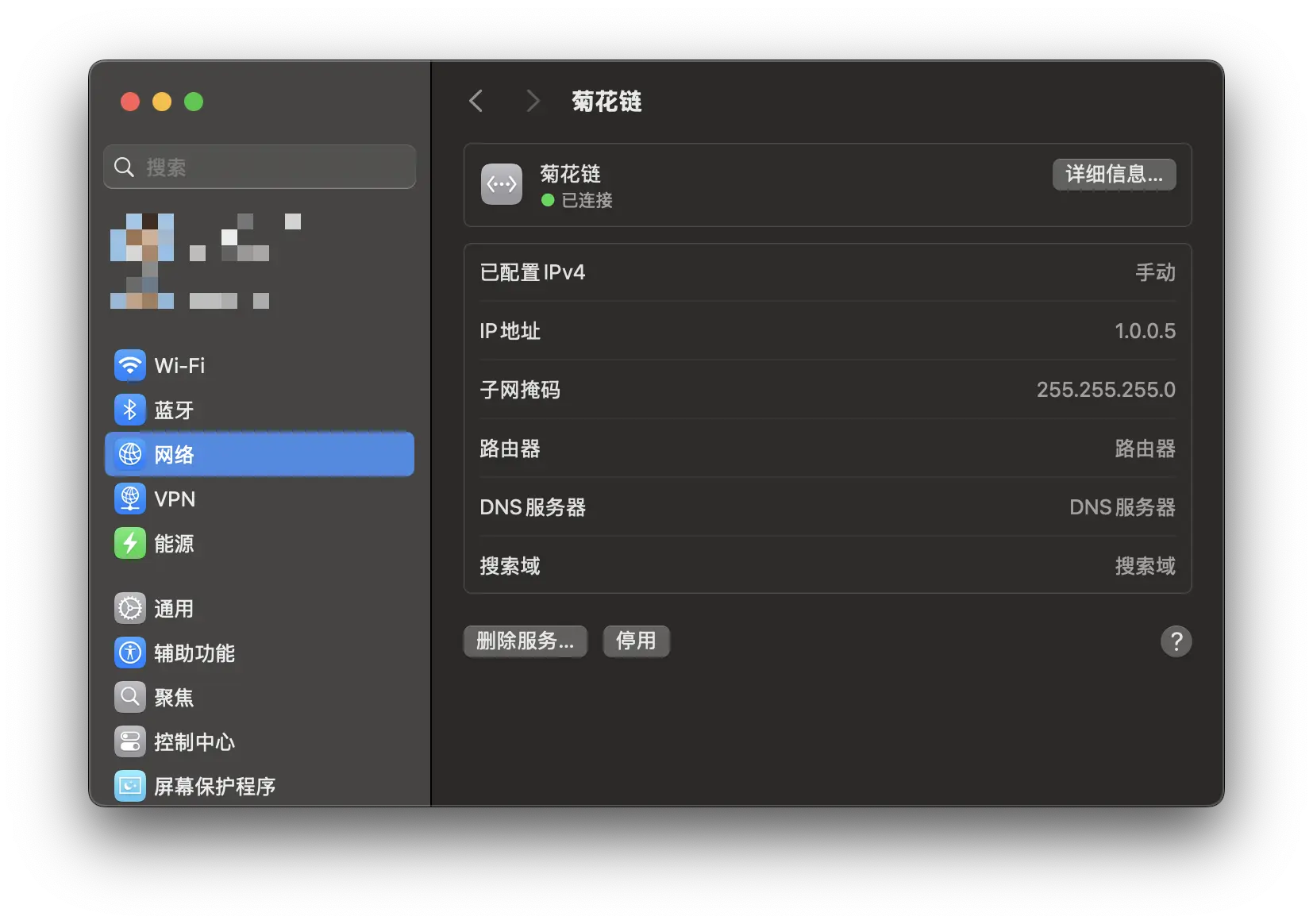

3 台 Mac 使用雷雳 3 连接后, 会自动在 网络 中创建一个名为 雷雳网桥 的接口, 然后只需要设置 IP 和子网掩码即可组网:

测试

iperf3

使用 iperf3 进行内网测试:

1 | iperf3 -f MB --omit 5 --time 20 -с 1.0.0.4 |

22 Gb/s 等于 2750 MBytes/s, 那么大概只跑到了理论速度的 90%, 对于这个结果还是比较满意的.

SMB 测试

打开 Mac mini 上的文件共享来传输文件, 连接使用 Mac mini 上雷雳网桥分配的 IP, 打开 MBP 上的访达, 按 ⌘ + K 健 (或点选菜单“前往 > 连接服务器“) , 输入 smb://1.0.0.4 , 以及对应的用户名密码就可以进行连接.

MBP ==> Mac mini 2018

Mac mini 2018 ==> MBP

MBP 的 SMB 居然还没有被限速的 256GB Mac mini 快, 我想可能的原因是 CalDigit TS4 的带宽被占用太多了, 有时间用雷雳接口直连再试试.

这就有点尴尬了, 4T 的 MBP 本地测试可以跑到 6000MB/s +:

拖动一个大于 5GB 的文件 (顺序读取) , 在菜单栏 iStat Menus 的网络监控中可以看到, 传输速度可以到达 800MB/s, 等于 6.4 Gb/s. 回传文件 (顺序写入) 则是到了 600MB/s 左右. 直接连接 USB3.2 协议的移动硬盘, 跟这个速度相差不大, 但是直接连接雷雳 4 协议的移动硬盘, 是可以轻松超过 2000MB/s 的传输速度.

scp

差一点突破 200MB/s:

未知状态

如果使用自动添加的雷雳网桥的话, 虽然连接没有问题, 但是会出现 未知状态 的警告, 对于强迫症的人肯定不能忍, 所以翻看了一些 教程 来解决这个问题.

如果有多个雷雳接口, 连接其中一个雷雳接口的时候, 系统会自动创建一个 雷雳网桥 的接口, 这个接口里面包含了所有的雷雳接口, 如下图所示, M2 的 2 个雷雳接口全部被自动添加到了这个 雷雳网桥 中, 但是只有 雷雳 2 接口在使用.

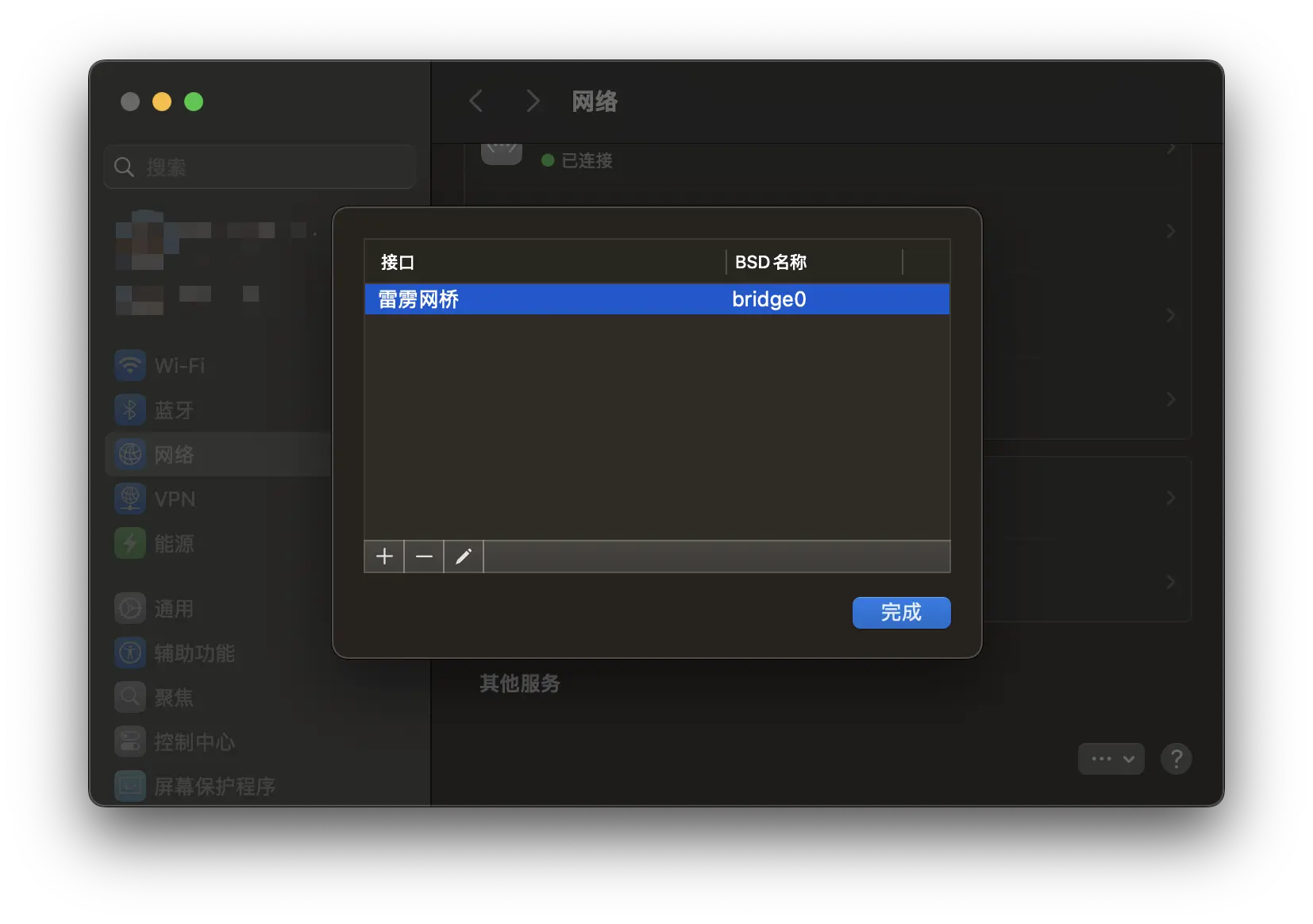

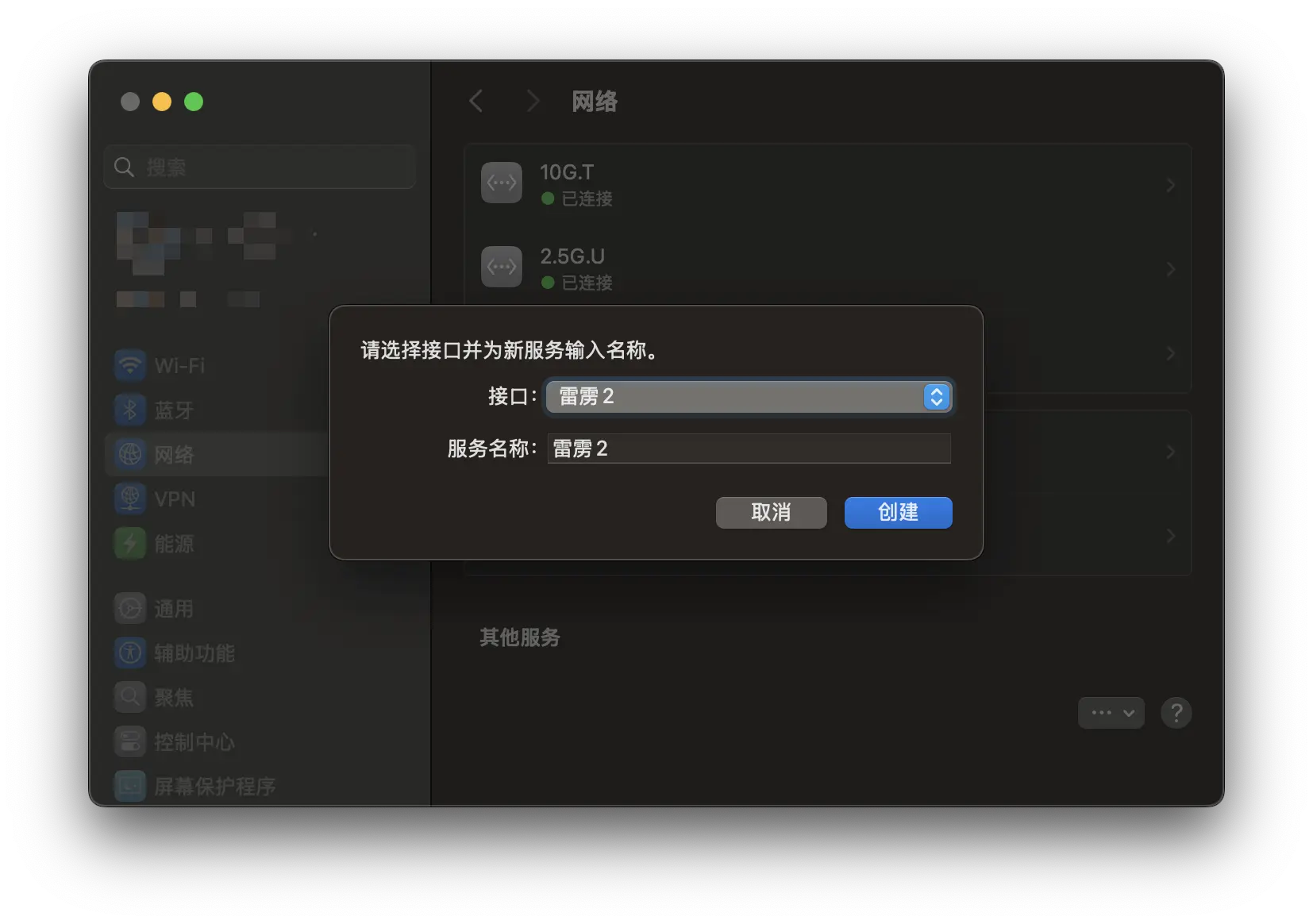

所以解决的办法就是删除这个 雷雳网桥, 然后自己创建一个雷雳接口:

点击 设置->网络 页面右下角的 …, 然后点击 管理虚拟接口:

先删除这个接口, 然后新建一个雷雳接口:

这里需要确认是第几个雷雳接口, 可以查看系统信息:

所以上面就应该选择 雷雳 2, 创建之后稍等一会, 就会出现一个已自动分配 IP 的雷雳接口, 设置 IP 后即可显示正常:

因为 Mac mini 2018 需要同时连接 Mac mini M2 和 MBP, 所以需要使用到雷雳网桥, 只需要将这个自动创建雷雳网桥中不需要的雷雳接口删除即可.

首先确认接口:

修改 雷雳网桥, 移出多余的接口即可:

总结

这次将书房的主要设备全部升级到万兆, 从学习 MBP 万兆方案, 到准备工作中对一些基础知识的了解, 最后的安装部署调试, 再到这篇博客, 耗时一周时间.

升级后的效果非常显著. 除了 MBP 由于驱动问题 MTU 无法修改到 9000 以外, 其他设备的上传和下载速度都接近或达到了理论值.

尽管在升级过程中也遇到了一些问题, 但这些问题的解决方法和未来的改进方向都已经明确. 等到换成雷雳 5 的设备时, 又可以考虑 25G 甚至时 40G 的升级方案了.

相关文章:

- 先导篇:我的 HomeLab 概要;

- 硬件篇:介绍我所拥有的硬件设备;

- 网络篇:包括网络环境、异地组网与网络安全;

- 服务篇:使用 Docker 搭建的各类服务;

- 数据篇:包括数据存储方案、备份方案和数据恢复方案;

- HomeLab数据同步:构建高效的数据同步网络

- HomeLab数据备份:打造坚实的数据安全防线

- HomeLab 网络续集:升级 10G 网络-再战 10 年

- NAT 内网穿透详解:揭秘网络连接背后的奥秘